Dans la première partie de cet article, nous avons dressé un tableau des pathologies de l’information, avant d’examiner leurs effets sur la formation des opinions et le comportement des citoyens. Nous avons également discuté d’une éventuelle mutation du virus « infox », à la faveur des développements de l’intelligence artificielle, notamment générative. Dans cette seconde partie, nous montrons le rôle positif inversement joué par l’IA dans la lutte contre l’infox, avant de décrire très succinctement le cadre réglementaire français et européen.

Les outils de lutte contre la désinformation

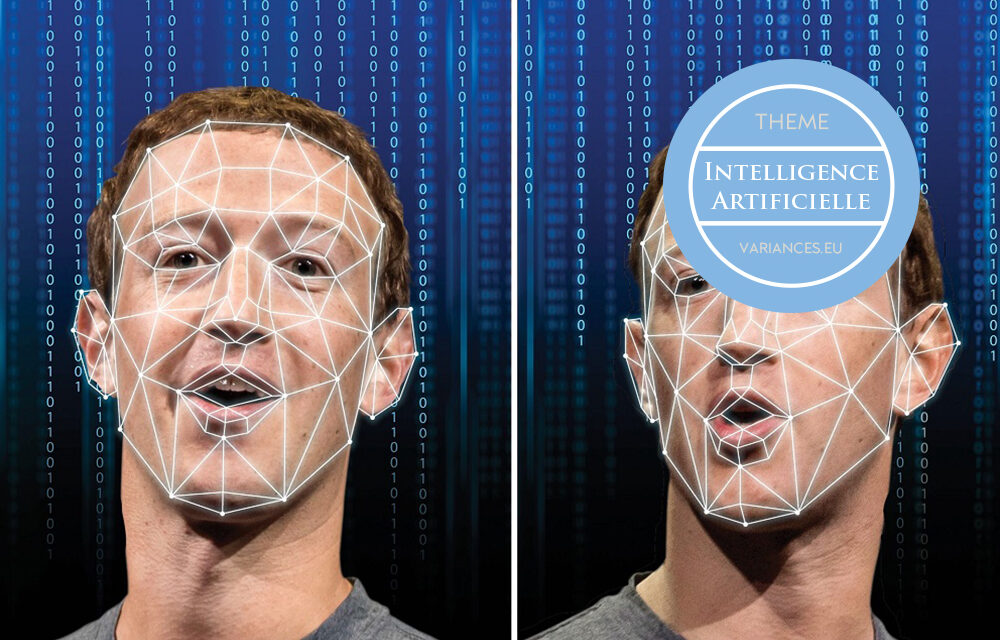

L’IA, telle le pharmàkon des Grecs anciens, est à la fois poison et remède, venin et antidote : si elle peut être falsificatrice, elle sait aussi se faire réparatrice. Du côté face de la médaille, l’IA permet par exemple de repérer sur les réseaux sociaux des « comportements non authentiques coordonnés », révélant la présence d’un nid d’agents conversationnels artificiels (chatbots). Elle permet également d’identifier des contenus de synthèse issus de l’IA générative, quels qu’en soient les supports : sur cet aspect, les initiatives se multiplient en Europe et dans le Monde, émanant de l’industrie comme des institutions publiques.

Dans le cadre de la Coalition for Content Provenance and Authenticity (C2PA)[1], groupement professionnel visant à instaurer un système de Content Credentials, Adobe a créé un symbole pour inciter au marquage des contenus engendrés par l’IA (watermarking), adopté par les principales plateformes : Google, Microsoft ou Meta. Cependant, il est facile d’échapper à ces démarches volontaires et, plus aisé encore, d’ajouter de faux watermarks à d’authentiques images.

Des organisations à but non lucratif, telles que TrueMedia[2], mettent à la disposition des professionnels et des particuliers des outils de détection. Ces outils utilisent l’apprentissage automatique et le traitement du langage naturel. Ils visent principalement à repérer ce qui serait « authentiquement » d’origine humaine. Cependant, ils ne fournissent que des conclusions probabilistes, laissant ainsi une grande marge d’interprétation.

Le projet européen vera.ai, lancé en septembre 2022, a pour ambition de développer de nouveaux outils multilingues de lutte contre la désinformation attachée à tout type de marqueur – texte, photo, vidéo, audio –, en recourant à des algorithmes et des méthodes d’intelligence artificielle[3]. Vera.ai développe et teste ses outils en collaboration avec des fact checkers, dont 130 journalistes d’investigation couvrant 85 pays. L’Agence France-Presse (AFP) est fortement engagée dans cette démarche : elle a créé la structure Medialab pour participer à des programmes d’innovation et de recherche, notamment le navigateur InVID-WeVerify, actuellement utilisé par 90 000 internautes et 224 pays, dont l’objectif est de vérifier les contenus du web, singulièrement sur les réseaux sociaux, par la combinaison d’une approche humaine participative, d’algorithmes en open source et de l’apprentissage machine.

Le papier blanc « Generative AI and Disinformation : Recent Advances, Challenges, and Opportunities », co-écrit par AI4media, AI4TRUST, TITAN et vera.ai, identifie avec clarté les défis et les limites de l’IA au service de la lutte contre la mésinformation, en distinguant les différents médiums concernés (Bontheva, 2024). Qu’en ressort-il principalement ?

En premier lieu, les progrès dans la détection d’images et vidéos synthétiques, bien que non négligeables, restent limités.

Vidéos et images. La détection d’images et vidéos synthétiques repose sur l’entrainement de modèles de deep learning à l’aide des bases de données publiques les plus populaires, telle FaceForensics (base de 500 000 images contenant des visages provenant de 1004 vidéos, utilisable pour reconnaître des contrefaçons d’images ou de vidéos), ou encore ForgeryNet (base de 2,9 millions d’images et 221 247 vidéos, annotées et classifiées pour détecter les contrefaçons faciales).

Les architectures de détection sont des réseaux convolutifs, tels que ResNets (réseaux de neurones résiduels) ou, plus récemment, VisionTransformers (décomposition d’une image d’entrée en une série de patchs pour améliorer la classification). Un outil de fragmentation des vidéos alimenté par l’IA, très utilisé, permet d’extraire des images clés qui sont ensuite soumises à des moteurs de recherche, afin de vérifier si elles sont déjà connues et indexées.

Des avancées récentes portent sur la scrutation de vidéos multi-identités, par exemple provenant de téléphones. Vera.ai s’appuie sur les caractéristiques audio et visuelles d’une personne classée « person of interest », pour créer un détecteur de deep fake. Si la détection est la plus avancée pour les vidéos et pour le son, des progrès sont également accomplis dans la détection de photos synthétiques.

Cependant, ces différentes percées demeurent embryonnaires. Certains outils, tel Adobe Firefly, échappent encore à la détection. Mais, surtout, chaque modèle de détection est spécialisé. Il faudrait donc combiner une batterie de modèles au sein d’un système global, afin de généraliser la détection. Par ailleurs, les « faux positifs », c’est-à-dire les vidéos déclarées comme fausses, alors qu’elles sont vraies, discréditent en partie la démarche. Enfin, les défis techniques s’accumulent : obsolescence des outils en raison de l’apparition de nouveaux formats d’encodage ; manque de fiabilité face à la faible qualité et le haut niveau de compression qui caractérisent les contenus sur internet ; et, tout à l’inverse, exigence d’une grande puissance de calcul afin d’examiner des vidéos longues en haute définition.

En deuxième lieu, l’identification de contenus sonores synthétiques pâtit à ce stade d’un défaut de financement et de la disponibilité de bases de données d’entrainement, qui entravent la dynamique de cet axe d’innovation.

Sons. La détection de sons synthétiques, à travers les systèmes Text-to-Speech (TTS) ou Voice Conversion (VC), est récente. Elle n’est en effet devenue une priorité que lorsque sont apparus des premiers discours de synthèse suffisamment sophistiqués pour être jugés problématiques. Afin de satisfaire à cette priorité, il convient urgemment : d’une part, de bâtir un écosystème robuste de recherche et de développement sur cette thématique, au financement assuré ; d’autre part, de disposer de bases de données qui soient à la fois conformes à la réglementation et de taille suffisante pour entrainer et tester les technologies de détection.

En outre, plutôt que se concentrer uniquement sur la reconnaissance de l’origine des contenus sonores, il serait précieux de procéder parallèlement à des recherches linguistiques visant à mieux cerner les mécanismes de manipulation par le langage oral, de mieux appréhender la culture énonciative de la falsification.

En troisième lieu, la détection d’écrits de synthèse s’est jusqu’ici focalisée sur des contenus en langue anglaise.

Écrits. La détection de désinformations engendrées par l’IA sous un format écrit est une voie de recherche très active. Les chercheurs ont montré que les textes de synthèse sont tellement fluides qu’un humain ne peut guère les identifier, et peut même les considérer comme plus fiables que des textes authentiques (Zellers et alii, 2020). Les systèmes de détection reposent sur la « stylométrie », ou reconnaissance des spécificités stylistiques d’un auteur. Ils utilisent le deep learning et la statistique : hybridées, ces deux techniques sont performantes et savent très bien détecter des formats longs, articles ou blogs artificiels.

En revanche, la détection automatique appliquée à des textes courts est défaillante. Or elle devrait être une priorité, dans la mesure où les grands modèles de langage (LLM) engendrent des messages courts de plus en plus élaborés et crédibles, et où la multiplication des bots pilotés par l’IA sur des plateformes telles que X crée un puissant vecteur de désinformation potentielle.

Dans leur majorité, les outils de détection ont été exclusivement entrainés et testés sur des contenus rédigés en anglais. Les textes engendrés par l’IA dans d’autres langues ne sont donc pas détectés, ou piètrement détectés à l’aide d’une approche exclusivement statistique. Il est par conséquent à craindre que les pays dont les langues sont les moins parlées, pour lesquels les bases de données sont les moins fournies, soient les plus ciblés par des manœuvres de désinformation. D’où l’ambition des initiatives européennes VIGILANT et vera.ai de constituer un corpus d’entrainement et une batterie de modèles multilingues : la création de bases de données dans toutes les langues parlées en Europe, dont certaines annotées par l’homme afin d’améliorer la performance, est désormais une impérieuse nécessité pour l’entraînement de modèles européens.

Plusieurs points sensibles sont de nature transversale, c’est-à-dire indépendants du support :

- Les systèmes de détection, parce que programmés en open source, sont accessibles aux acteurs de la désinformation qui savent comment déjouer ces systèmes, en appliquant des techniques d’obstruction ou de correction humainement indétectables.

- Aussi efficaces que soient les modèles de reconnaissance des « informations » créées par l’intelligence artificielle générative, distinguer le « vrai » du « faux » ne peut pour autant être totalement automatisé et réclame une expertise humaine en dernier ressort. Ce « principe d’un humain dans la boucle » (human oversight), au cœur du Règlement européen AI Act, soulève à son tour d’autres questions : que doit-on vérifier, à quelles fins, quand et par qui (Enquvist, 2023) ?

- Les outils de détection, parce qu’ils bénéficient des avancées de l’IA, permettent d’analyser un volume toujours plus important de données. Mais ils ne peuvent que très imparfaitement, du moins à ce stade, saisir les subtilités de l’intentionnalité humaine, détecter à coup sûr les éléments stylistiques typiques des fake news tels que la polarisation émotionnelle[4], ni déceler les mécanismes de manipulation psychologique qui exploitent les vulnérabilités et les préjugés.

Aider les professionnels de l’information

Ayant pour principe d’identifier la source d’une information afin d’en vérifier la fiabilité, les plateformes luttant contre la désinformation sont démunies face à l’IA générative, celle-ci brouillant par nature la traçabilité de l’information. À cet égard, l’IA curatrice fournit de précieux instruments d’assistance aux vérificateurs de faits (fact checkers) et aux journalistes : elle est tout à la fois utile à identifier les risques de mésinformation, à améliorer la fiabilité des contenus, et à former les professionnels de l’information.

L’impératif premier est de sensibiliser aux risques de désinformation liés à l’IA. Le projet européen AI-CODE développe à cet effet des modules d’éducation à destination des médias, aidant à mieux comprendre les technologies d’IA générative, leurs risques et leurs limites. Ce système interconnecté de différents services d’IA est développé avec des professionnels, afin non seulement d’identifier des contenus fallacieux, mais également de proposer des mesures proactives contre la désinformation. Un assistant basé sur l’IA générative fournit aux journalistes un instrument d’évaluation et de suivi de leur propre création de contenus, afin de mieux leur faire percevoir la menace potentielle de désinformation qui résulterait d’un détournement de leur canevas argumentatif et d’une réinterprétation contrefaite de leurs analyses.

Une entreprise plus ambitieuse consiste à s’appuyer sur l’IA pour aider les fact-checkers, dont le travail est devenu très lourd et complexe. Le projet AI4TRUST[5] a ainsi pour objectif de mettre à leur disposition une plateforme d’outils dont l’originalité réside dans son socle fondateur : une modélisation des mécanismes sociaux à l’œuvre dans la désinformation. La plateforme permet d’identifier des schémas comportementaux et relationnels propices à la diffusion de l’infox et de repérer des groupes à risque favorisant la diffusion de désinformation. Cette dimension sociométrique du projet conduit ainsi à une caractérisation des profils des super-spreaders, individus diffusant massivement l’information.

S’agissant de la sélection et de la vérification des sources, l’IA peut aider à référencer les contenus de notices encyclopédiques. Wikipedia a pour règle d’asseoir ses affirmations sur des citations sourcées : animés par leur sens des responsabilités, les éditeurs vérifient ces sources, leur fiabilité, comme leur pertinence, ce qui suppose une compréhension fine du langage. La plateforme SIDE utilise l’IA pour : d’une part, aider les éditeurs de Wikipedia à identifier les citations dont les sources sont contestables ; et, d’autre part, rechercher sur le web des sources alternatives, plus pertinentes. SIDE a été entrainé sur le corpus Wikipedia en langue anglaise et il a été évalué – sous forme d’annotation humaine – au regard de sa capacité à proposer des citations alternatives appartenant déjà au corpus Wikipedia dans des articles jugés de haute qualité. Il est estimé que, dans 60 % des cas, les vérificateurs préfèrent les citations suggérées par SIDE (Petroni et alii, 2023).

Pour conclure sur l’IA curatrice, il apparaît qu’en dépit des nombreuses initiatives dont elle est l’objet, son bilan est en demi-teinte : elle progresse avec retard par rapport à l’IA falsificatrice. Plus précisément, ainsi que nous l’avons souligné supra, si les apports de l’intelligence artificielle dans la lutte contre la désinformation demeurent modestes, les freins sont moins technologiques que budgétaires. Très frappant est le déséquilibre des moyens engagés entre : d’un côté les compagnies, qui investissent des milliards dans le développement des LLM (Large Language Models) et des NLP (Natural Language Processing) ; et, de l’autre, l’Europe et les États, qui parviennent péniblement à mobiliser quelques dizaines de millions d’euros pour développer des recherches et des outils de lutte contre la désinformation.

On peut enfin regretter que les ressources documentaires sur la capacité de l’IA à détecter des contextes ou des indices de désinformation soient moins abondantes que celles consacrées à la détection des contenus de synthèse. Cette voie semble pourtant particulièrement prometteuse, dans la mesure où l’IA y joue pleinement son rôle d’appui à l’intelligence humaine.

Les dispositions réglementaires

Par rapport à d’autres régions du monde, l’Europe est en avance, s’agissant de la production de textes législatifs visant à éradiquer la désinformation en ligne et à promouvoir l’honnêteté de l’information. Devançant le processus européen, la France a promulgué, dès décembre 2018, une loi de lutte contre la manipulation de l’information, dite loi « infox ». Celle-ci impose notamment aux grandes plateformes numériques l’obligation de mettre en œuvre des mesures en vue de lutter contre la diffusion de fausses informations susceptibles de troubler l’ordre public ou d’altérer la sincérité d’un scrutin électoral.

La loi fournit par ailleurs, sans toutefois l’assortir de sanctions en cas d’infraction, une liste de recommandations s’adressant aux acteurs numériques : plus grande transparence sur les algorithmes ; mise en avant des contenus issus des médias traditionnels ; lutte contre la propagation massive de fausses informations ; affichage de la sponsorisation de certains contenus ; information des utilisateurs sur la nature, l’origine et les modalités de diffusion des contenus ; contribution à l’éducation aux médias et à l’information du public.

Sorti en 2022, le Règlement européen sur les services numériques (Digital Services Act ou DSA) impose aux plateformes d’effectuer une analyse de risques de désinformation et de mettre en œuvre des mesures techniques et humaines pour les réduire. Le Règlement est assorti d’un code informel de bonnes pratiques, ayant vocation à s’y intégrer progressivement. Il s’applique en France depuis le printemps 2024, où ses dispositions se substituent à celles de la loi de 2018, en les renforçant. Par ailleurs le Règlement sur l’intelligence artificielle (AI Act), fraîchement paru début août 2024, contient plusieurs dispositions complétant celles du DSA, obligeant notamment les fournisseurs de services d’IA à marquer les contenus synthétiques et les exploitants de ces services à signaler les infox qu’ils détectent. Enfin, en matière de risque d’ingérences étrangères, a été créé en France en 2021 le service VIGINUM, rattaché au Secrétariat national de la défense et de la sécurité nationale.

En bref, même si certaines dispositions complémentaires – notamment en matière de sanctions applicables en cas d’infraction – gagneraient à être ajoutées, nous disposons d’un cadre réglementaire pertinent, au service d’un enjeu démocratique fondamental : la confiance raisonnée des citoyens en leurs moyens d’information à l’ère numérique.

Mots-clés : Désinformation – Deep fake – Intelligence artificielle générative – Détection des contenus de synthèse – Fact-checkers – Journalisme – AI Act – Digital Services Act – Élections – Régulation.

* Cet article en deux parties est tiré d’une conférence donnée par l’auteur lors d’une soirée-débat sur le thème « IA générative et mésinformation : un cataclysme… ou pas ? », organisée le 13 juin 2024 par l’association ENSAE Alumni, dans le cadre de son cycle Data &IA. L’article s’inspire par ailleurs des travaux actuellement menés par le groupe de travail « Mésinformation et IA générative », piloté par l’auteur au sein de l’Académie des technologies ; que soient ainsi remerciés les membres de ce groupe, en particulier Chantal Jouanno, Joëlle Toledano et Winston Maxwell, dont les apports ont nourri la conférence comme l’article. Enfin, ce texte complète et enrichit deux articles précédemment parus dans Variances : le premier, datant de juin 2023, porte sur les récents développements de l’IA : « Que faut-il connaître, espérer et craindre de l’intelligence artificielle générative ? », partie 1 « Qui est-elle et que fait-elle ? », partie 2 « Quels risques, quelles régulations » (juin 2023) ; et le second, datant de mai 2020, aborde la crise de la cognition : « Connaissance à l’ère numérique : la possibilité du vrai ? » .

Références

Enqvist, Lena, « Human oversight in the EU artificial intelligence act: what, when and by whom?”, Law, Innovation and technology, volume 15 (2023).

Petroni, Fabio, et alii, “Improving Wikipedia Verifiability with AI” in Nature machine intelligence, 5: 1142-1148 (2023).

Bontcheva, Kalina, et alii, “Generative AI and Disinformation: Recent Advances, Challenges, and Opportunities”, editor University of Sheffield, (February 2024).

Zellers, Rowan et alli, “Defending Against Neural Fake News”, Proceedings of the 33rd International Conference on Neural Information Processing Systems (2019).

[1] C2PA développe des standards techniques de certification de la source et de la provenance des contenus médiatiques en ligne. Le projet résulte d’une alliance entre Adobe, Arm, Intel, Microsoft et Truepic.

[2] Outre TrueMedia, fondée par le docteur Etzioni, on peut également citer Copyleaks, Content at Scale, OriginalityAI, GPT Zero ou encore Crossplag.

[3] Le projet, auquel participent les médias suisses (EBU) et allemands (Deustche Welle) et dont le Centre Borelli de l’ENS de Paris-Saclay est également partenaire, est coordonné par l’équipe Mever (Media Verification) de l’Institut de recherche en informatique de Thessalonique (ITI-CERTH).

[4] Cet aspect particulier est examiné au sein du projet allemand DeFakts, piloté par le Centre de recherches sur l’informatique (FZI), en collaboration avec les Ministères fédéraux de l’éducation et de la recherche ; pour déceler la désinformation sur les réseaux sociaux et les groupes de messageries, l’équipe a constitué des bases de données provenant de X et de Telegram.

[5] Projet financé par l’Union européenne, coordonné par la Fondazione Bruno Kessler et impliquant un consortium de partenaires, dont le CNRS, issus de 11 pays.

- Le beau, le vrai et le bon - 19 décembre 2024

- Faire face à l’invasion du faux !* – Partie 2. Les remèdes technologiques et juridiques - 19 septembre 2024

- Faire face à l’invasion du faux !* – Partie 1. Les pathologies de l’information et leurs impacts - 12 septembre 2024

Commentaires récents