Partie 1. « Qui » est-elle et que fait-elle ?

L’I.A. générative, dernière percée de la révolution numérique

L’intelligence artificielle générative fait couler beaucoup d’encre depuis novembre 2022, date d’apparition de l’application Chat GPT-3 développée et commercialisée par la start-up américaine Open AI, permettant d’engendrer des textes – d’où le qualificatif « générative » –, en réponse à des requêtes soumises par ses utilisateurs. Cette I.A. appartient à la famille des LLM (Large Language Models), très rapidement évolutive : en quelques mois, Chat GPT-3 est devenu Chat GPT, puis Chat GPT-4 et d’autres acteurs ont lancé des logiciels comparables, tels que BERT, BLOOM, CLIP ou Google Bard. Dans le domaine de la génération d’images, Midjourney connaît un succès comparable.

Ces produits sont emblématiques des plus récents développements de l’informatique et certains voient dans cette percée un tournant décisif, une révolution à part entière au sein de la révolution numérique née des progrès considérables accomplis par l’informatique depuis la fin de la seconde guerre mondiale et poursuivis sans relâche pendant près de 80 ans.

Les deux précédentes révolutions industrielles, celle de la machine à vapeur au XVIIIe siècle, puis celle de l’électricité, la chimie, la voiture, l’avion au XIXe, se fondaient sur des technologies, qui certes changeaient les conditions de production, de consommation, de vie, d’habitat, de mobilité, mais demeuraient pour autant des outils dans la droite ligne du silex ou de la hache, c’est-à-dire fondamentalement des prothèses de la main. Avec la révolution numérique, nous nous trouvons confrontés à une grappe technologique qui se rapporte aux fonctions du cerveau et qui affecte donc en profondeur l’exercice de nos fonctions cognitives, la manière dont nous pensons, communiquons et nous exprimons. Désormais, avec Chat GPT, une machine informatique est devenue, selon une terminologie due à l’Académie des technologies, un « langageur », c’est-à-dire un robot conversationnel capable de produire du langage naturel, une faculté qui était jusqu’ici l’apanage de l’homme (Académie des technologies, 2023).

Ce qu’il est aujourd’hui convenu d’appeler « le » numérique, un terme générique évoquant la présence ambiante et englobante des technologies qu’il désigne, apparaît comme l’équivalent de l’écriture il y a 5000 ans ou de l’imprimerie il y a 500 ans. Il s’agit d’une révolution cognitive et culturelle, dont la périodicité s’établit à l’échelle du millénaire, et non pas simplement d’une révolution technique et industrielle, dont la fréquence est plutôt séculaire. Néanmoins, le numérique a également enclenché une révolution industrielle dont l’impact est considérable sur l’économie et sur la société, avec l’émergence d’usines intelligentes, la disparition, la transformation et la création d’emplois, à « l’ubérisation » de nombreux secteurs d’activité, à l’explosion du commerce en ligne, à la mutation des méthodes d’éducation et d’enseignement, etc. À l’ère numérique, le délai qui sépare une innovation de son impact massif dans la vie quotidienne est singulièrement plus court qu’aux temps du moulin à vent, de la vapeur ou même de l’électricité.

Dans ce contexte, l’intelligence artificielle générative s’inscrit-elle dans la continuité des effets du numérique, ou bien marque-t-elle réellement une rupture, l’émergence d’une ère nouvelle ? On pourrait après tout plaider le contraire, en faisant remarquer que l’I.A. générative existait dès les années 1960 sous une forme embryonnaire, à travers les « systèmes experts », ces logiciels articulés autour d’une base de faits, d’une base de règles et d’un moteur d’inférence, capables de rendre à une entreprise ou une organisation un service d’aide à la décision. Pour se faire une idée de la réelle originalité des outils numériques nouvellement mis sur le marché, il est tout d’abord utile d’examiner le principe de fonctionnement d’une I.A. en général et d’une I.A générative en particulier.

Comment l’I.A. fonctionne-t-elle ?

Comme son son nom l’indique, l’I.A. cherche à imiter la structure de la pensée humaine. On se représente parfois celle-ci comme un système arborescent, alors qu’il est plus juste de la voir comme un système réticulaire. En effet, l’arbre n’est qu’un cas très particulier de réseau, dans lequel chaque nœud n’a qu’un seul antécédent et où l’on ne peut passer d’un nœud à un autre sans remonter à leur plus proche prédécesseur commun. Une intelligence purement arborescente serait donc assez pauvre ! L’intelligence naturelle fonctionne plutôt selon le modèle d’un réseau maillé, à l’image même du réseau formé par les neurones de notre cerveau. La pensée ne suit généralement pas le chemin direct d’une sève qui va du tronc d’un arbre jusqu’à ses feuilles en passant par ses branches. Au contraire, elle fait des boucles, prend des chemins de traverse, met à profit des courts-circuits, connecte entre eux des nœuds qui ne sont pas nécessairement liés de manière hiérarchique. Dans son parcours sinueux, la pensée garde la mémoire des impasses et aussi des portes entrouvertes sans succès en certains nœuds, mais qui pourront être fructueusement ouvertes en d’autres nœuds, au fil du cheminement psychique.

Simulant le cerveau, l’I.A. générative fonctionne selon le modèle d’un réseau de neurones artificiels. Imaginez un grand nombre d’unités logicielles élémentaires, chacune équivalant à un neurone du cerveau humain. Ces neurones artificiels sont répartis en couches successives, de la couche d’entrée jusqu’à la couche de résultat, et ils sont reliés entre eux par une multitude de synapses artificielles, aussi bien horizontalement, au sein d’une couche donnée, que verticalement, entre deux couches successives. Lorsqu’un neurone reçoit un signal d’un autre neurone, il émet ou non un signal vers un ou plusieurs des neurones auxquels il est connecté. Au cours de la phase d’entraînement de l’I.A. sont réglés les paramètres, ou « poids », c’est-à-dire les seuils de déclenchement d’émission d’un neurone vers un autre. Cet apprentissage s’opère en partie sous la supervision du programmeur, et en partie à l’initiative de la machine elle-même, selon un mécanisme de « rétro-propagation des erreurs » et de renforcement des connexions qui tendent à améliorer les résultats délivrés. Pour Chat GPT-3, environ 175 milliards de paramètres ont été ainsi ajustés !

Pour bien comprendre cette procédure, considérons un autre domaine d’application que la production de langage, celui la reconnaissance des formes. Si l’on veut faire reconnaître à une I.A. un chat sur une image, on lui soumet une image de chat et on lui indique : « Ceci est un chat. ». L’I.A. a exploré et retenu tous les pixels de la photo considérée mais, à ce stade, elle ne saurait pas reconnaître un chat sur une autre photo dont les pixels ne seraient pas en tout point identiques à ceux de la précédente. Si, au lieu d’une seule, on lui montre quinze milliards de photos contenant des chats, l’I.A. finit par reconnaître des aspects communs entre ces images, des patterns identiques, des traits félins en quelque sorte, et elle n’est alors plus contrainte d’analyser une nouvelle image pixel par pixel. Elle saura dire si un chat est présent ou non sur une image qu’elle ne connaît pas encore, par similarité avec la myriade d’images qu’elle connaît déjà. Au cours de cet apprentissage, en grande partie automatique, les paramètres du réseau de neurones s’ajustent selon un processus d’essais-erreurs, à la manière de potentiomètres, afin que la probabilité de donner une bonne réponse augmente.

Apprentissage machine

Insuffisamment entraînée, une I.A. risque de se fourvoyer gravement. Si on ne lui a précédemment montré que des chats gambadant en extérieur et que maintenant on lui en montre un se prélassant dans un appartement, elle peut se tromper car elle ne voit aucune image ressemblante dans sa base d’entraînement. Il convient donc de l’entraîner sur des images de chats photographiés dans toute une variété de contextes différents. Et si, plus généralement, on souhaite rendre l’I.A. capable de décrire une image dans tous ses détails, alors il faut lui apprendre à reconnaître, non seulement des chats, mais aussi des chiens, des voitures, des immeubles, des feux rouges, des fleurs, des champs, etc. Et la machine apprend si mécaniquement et si laborieusement qu’elle consomme une énorme quantité de ressources informatiques (Académie des technologies, 2018).

S’il est juste de dire que l’intelligence artificielle est capable d’apprendre, à la fois par ses propres moyens et sous supervision, il convient de préciser que cet apprentissage intervient uniquement lors de la phase amont de l’entraînement et non pas au cours de la phase aval d’utilisation. Tant que la base de données n’est pas réalimentée, que le réglage des paramètres n’est pas révisé en tenant compte des données ajoutées, aucune évolution spontanée n’est possible. Ce qui peut néanmoins surprendre est que le programmeur ne sait jamais lui-même exactement comment la machine opère pour reconnaître un chat ! Il y a en effet une part empirique et aléatoire dans l’ajustement des neurones artificiels, une part de « bidouille ». Mais la chimie et l’électricité dans le cerveau fonctionnent aussi un peu de cette manière…

Bien qu’elle mimique l’organisation d’un réseau humain de neurones, l’intelligence artificielle apprend sans comprendre : elle reconnaît un chat sans savoir ce qu’est un animal, elle lit et écrit des textes sans en comprendre un seul mot ! Mais est-elle en cela si différente de beaucoup humains ? À l’école, certains élèves sont studieux mais pas très astucieux. Ils ne comprennent pas grand-chose mais ils apprennent beaucoup et ils connaissent par cœur le cours magistral ainsi que les solutions d’exercices élémentaires. Ces élèves s’en sortent toujours à l’examen : ils n’ont jamais 18 ou 20, mais ils ont 12 ou 14. Ils ont appris mais ils n’ont pas compris. Les machines numériques, comme ces élèves, ne franchissent pas le seuil de la compréhension. Elles n’ont aucune capacité de créativité lorsqu’elles sont confrontées à des problèmes nouveaux, exigeant des modes de raisonnements qu’ils n’ont pas acquis. Bien que la machine ne comprenne pas, ses résultats peuvent néanmoins se montrer impressionnants. La frontière entre apprendre et comprendre est en réalité assez subtile. La machine agit comme un élève studieux qui sait établir des liens entre les bouts de savoir qu’il a emmagasinés. Si Sénèque a parlé de certaines sujets dont Montaigne parle également, alors Chat GPT pourra écrire une phrase, crédible sinon pertinente, qui associe les deux auteurs.

Prouesses et faiblesses de l’I.A. générative

Pour s’en tenir aux langageurs, l’outil Chat GPT est la réunion d’un générateur de langage (Generative Pretrained Transformer) et d’un robot conversationnel (Chat), servant d’interface. Dans la version GPT-3, le logiciel a été entraîné sur une base de données d’environ cinq cents milliards de mots, à réaliser la tâche « élémentaire » suivante : à partir d’une séquence de mots fournie en entrée par l’utilisateur, produire en sortie une séquence de mots prolongeant la séquence d’entrée de la manière « la plus probable ». Ainsi Chat GPT ne fait qu’extrapoler des séquences de mots. Quand vous lui soumettez une question, ou un texte, il va chercher dans sa base d’entraînement des mots qui sont susceptibles de prolonger le plus naturellement ceux que vous lui avez soumis. Et grâce à ce simple mécanisme, il réalise parfois des prouesses… et peut aussi commettre des erreurs grossières. En outre, la composante Chat vous dit poliment bonjour quand vous l’interrogez, vous remercie de l’avoir questionnée… C’est peut-être d’ailleurs surtout à cela que l’on distingue cette machine d’un humain !

Ainsi, Chat GPT n’est pas intelligent au sens où on l’entend habituellement. Il fait preuve en revanche d’une étonnante capacité algorithmique à fournir des données de sortie à partir de données d’entrée, et ceci avec une rapidité confondante.

Chat GPT ne possède strictement aucune forme de savoir au sens ordinaire. Il n’a retiré aucun sens de l’énorme corpus qu’on lui a donné à lire ! En revanche, il a appris à faire des associations, à reconnaître sans les comprendre des configurations de mots. C’est de cette façon qu’il est en mesure de composer des phrases excellemment écrites, en français… comme dans la centaine d’autres langues sur lesquelles il s’est exercé ! Il manie la syntaxe à merveille, mais ne possède aucune capacité sémantique. La « supercherie » réside dans la taille de la base de données, donnant l’illusion que seule l’intention de délivrer une signification puisse sous-tendre ce qui n’est en réalité qu’un mirage statistique.

Par construction même, si l’on soumet une ânerie à Chat GPT, il prolongera avec zèle cette ânerie par une autre ânerie, sans remettre en cause la véracité de l’entrée. Demandez-lui pourquoi les vaches pondent de plus gros œufs que les autruches. Il vous fera une réponse plus intelligente que ne le laisserait espérer l’ineptie de votre question, mais toutefois absurde :

– Les vaches sont des animaux domestiqués, bien nourris, élevés pour la reproduction. Elles sont donc dans de meilleures conditions pour pondre que les autruches, vivant en milieu sauvage. Par ailleurs, les vaches étant plus grosses que les autruches, il est normal qu’elles pondent de plus gros œufs.

Si vous demandez à Chat GPT quand Christophe Colomb a découvert l’Amérique, la réponse sera correcte : « 1492 ». En effet, dans sa base de données, les unités lexicales « Christophe Colomb », « découverte », « Amérique », « 1492 » sont très souvent proches les unes des autres et donc Chat GPT les associe. Et si vous lui demandez en quelle année Nicolas Curien a découvert l’Amérique, Chat GPT vous répondra encore « 1492 », car la présence d’un seul intrus dans la phrase soumise ne suffit pas à casser les liens forts unissant les autres mots de la requête.

Si, en réaction à une réponse erronée, vous le signalez à la machine, alors elle se confondra en excuses, non pas du tout parce qu’elle a réalisé son erreur et se montre contrite, mais parce que son corpus éducatif l’a instruite que telle est la répartie la plus fréquente à la suite d’une réclamation !

Pour échafauder une pensée, l’esprit humain s’appuie sur la base de ses connaissances, sur son agilité à les relier entre elles, sur son habileté à répondre aux questions qu’il se pose à lui même. Tout cela est à la portée d’une I.A bien entraînée. Mais une part importante de l’intelligence naturelle réside aussi dans l’intuition qui, contrairement à une idée répandue, ne s’oppose pas au raisonnement logique, mais l’oriente dans les directions semblant les plus prometteuses. Il y a dans l’intuition une sorte de génie, une créativité, dont les machines intelligentes sont aujourd’hui encore incapables. L’I.A. sait se faire générative, mais pas créative.

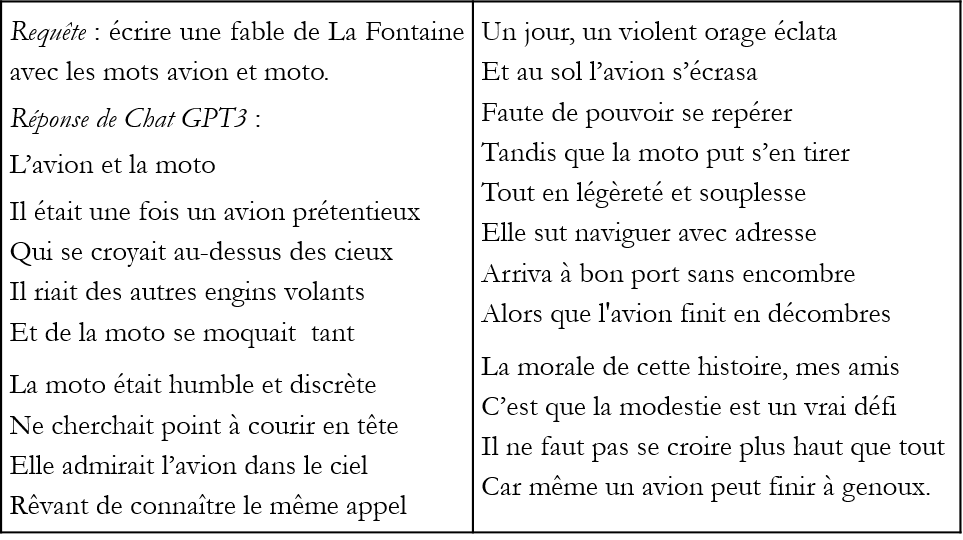

Néanmoins, les données contenues dans la base d’entraînement d’une I.A. générative ont été produites par des auteurs qui peuvent avoir eux-mêmes fait preuve d’intuition et de génie. Par ailleurs, une I.A. réalise sans peine des associations surprenantes, si bien qu’elle peut bluffer son utilisateur au jeu du « À la manière de… » ! Jugez plutôt à cet égard de la remarquable prouesse réalisée par Chat GPT, à qui l’on a demandé de composer une fable à la façon de Jean de La Fontaine, sur la base des mots « moto » et « avion ».

Dans un registre plus concret, aurait-on obtenu une réponse pertinente si l’on avait consulté Chat GPT sur la réforme des retraites ? Il est très vraisemblable que certains ont essayé ! Quand on lui pose ce genre de question, le langageur est assez efficace pour rapporter les différents points de vue en présence. En l’occurrence, il présentera celui des syndicats qui refusent tout allongement de la durée de travail, et celui du gouvernement, qui veut parvenir à l’équilibre du système en réglant ses nombreux paramètres, dont l’âge de départ à la retraite. Il synthétisera également des comparaisons internationales. Mais peut-on en attendre davantage ? Oui et non. L’I.A. générative ne peut inventer un nouveau système ex nihilo mais elle pourrait proposer un hybride de systèmes existants. Si on l’a entraînée exclusivement à partir de données décrivant des systèmes de retraite par répartition, elle ignorera le modèle par capitalisation. En revanche, si sa base d’entraînement inclut des régimes de retraite structurellement très différents, alors l’I.A. pourra suggérer un régime inédit en mixant des régimes existants.

Plus large est la base de données sous-jacente, plus forte est la probabilité que, grâce à sa puissance de calcul, l’I.A. générative puisse, au sein de cet immense corpus, associer deux idées que personne auparavant n’avait pensé à relier. La pensée humaine procède beaucoup par analogies mais elle est bornée par sa capacité limitée à explorer toutes les combinaisons possibles. La machine, quant à elle, est nettement moins sujette à cette limitation.

Plongés dans le monde de l’I.A.

L’I.A. est devenue omniprésente. Déjà existante dans les moteurs de recherche et dans les algorithmes de recommandation des grandes plateformes, elle percole dans tous les domaines d’activités, avec la montée en puissance des jeux vidéo, des métavers, de la réalité virtuelle et de la réalité augmentée. Le numérique est invasif et la génération Z nous donne un aperçu des comportements qui s’étendront bientôt à l’ensemble de la population. Très vaguement attentif aux congénères de sa bande pourtant présents à ses côtés, un jeune d’aujourd’hui est occupé à échanger des likes avec des « amis » distants sur les réseaux sociaux, ou à interroger Chat GPT, tout en écoutant à fond de la musique en streaming à travers les écouteurs de son portable. Ils fait ainsi trois ou quatre choses à la fois, exerçant ses fonctions cognitives de façon très différente de ce que je faisais lorsque j’avais son âge. Mon père me répétait « on ne fait bien qu’une seule chose à la fois ! » et je ne pouvais, à l’époque, que lui donner raison : si l’on réalise plusieurs tâches à la fois, chacune d’elles est nécessairement moins soigneusement accomplie que si l’on s’y consacrait exclusivement ! Néanmoins, le mode multitâches, désormais caractéristique du monde numérique, ne peut tout à fait se résumer à une perte d’efficacité, car il permet de développer des synergies imprévues entre activités menées de front.

Le multitâches est un effet de la multi-sollicitation : s’ajoutant aux médias historiques, la multitude des sites accessibles sur internet fait que chacun baigne constamment dans un univers sans limite apparente, empli d’informations et de contenus les plus divers. Jeune, j’avais l’impression chaque soir que j’avais terminé tout ce que j’avais à faire en réaction aux stimuli auxquels j’avais été soumis durant la journée. Aujourd’hui, cela n’aurait plus de sens ! On ne peut plus prêter attention à tout. Sur l’application mail, je passe davantage de temps à jeter des spams dans la corbeille qu’à lire des messages présentant un réel intérêt pour moi. À l’ère numérique, la faculté intellectuelle sans doute la plus importante est devenue la capacité de trier avec discernement l’utile de l’inutile, et surtout du nuisible, au sein d’un tsunami numérique, ou « tsunumi », qui nous submerge en permanence.

Les nouveaux outils de l’IA participent de cette confusion générale, en renforçant le risque de propagation virale de fausses informations. « Chat GPT, explique-moi pourquoi la terre est plate ? », et votre langageur favori mettra un point d’honneur à vous l’expliquer d’une manière attrayante et pédagogique. Parce qu’elle ne comprend pas les données qu’elle traite, que le statut de vérité n’a pas de sens pour elle, l’I.A. générative est potentiellement un redoutable moteur de fake, et même de deep fake, car elle ne manque certes pas de talent d’illusionniste ! Par exemple, si on exige de Chat GPT qu’il source ses propos, il peut inventer des références entièrement fantaisistes mais imitées à la perfection, en respectant le format des vraies bibliographies incluses dans sa base d’entraînement. La production de faux représente un réel danger car, même sans intention délibérée de nuire, même si ses concepteurs ont veillé à ne pas la nourrir d’informations incorrectes, l’I.A. générative, à travers ses inévitables erreurs, en produira elle-même et elle les propagera !

Ce que démultipliera l’I.A. générative est en réalité déjà à l’œuvre sur le web 2.0 équipé d’un simple moteur de recherche comme Google. On observe effectivement que, notamment pour les plus jeunes, il n’est pas simple de sélectionner les sites fournissant des informations pertinentes et fiables. Les séniors sont moins handicapés à cet égard, car ils ont jadis appris à séparer le bon grain de l’ivraie en recherchant des sources dans des bibliothèques physiques. Certes, la multiplicité grandissante des canaux d’information autorise des recoupements et permet donc en théorie au citoyen de porter plus facilement un regard critique qu’en l’absence de pluralité des courants de pensée et d’opinion. Néanmoins, on assiste à une victoire de la pensée paresseuse contre le sens critique. Il est frappant et inquiétant de noter que l’encyclopédie bénévole en ligne Wikipédia, qui offre un bon niveau de fiabilité informationnelle, peine à survivre dans un écosystème numérique où l’attention des internautes se porte en premier vers des contenus faux, mais attractifs car inattendus, peu coûteux à produire et très coûteux à réfuter. Le sensationnel prime et paye ! À travers la mécanique économique de génération de profits à partir de l’audience, des sites vertueux finissent ainsi par être marginalisés et des sites trompeurs, sectaires ou haineux réussissent, sous couvert d’anonymat, à occuper le devant de la scène.

Le rôle de l’éducation

Certains enseignants réagissent très négativement à la diffusion de l’I.A. générative, qu’ils perçoivent comme catastrophique, s’alarmant de ce qu’elle incite les élèves à la paresse et les encourage à déléguer leurs devoirs à la machine. Il faut raison garder. N’importe quelle technologie est capable du meilleur comme du pire, suivant la façon dont on l’emploie, dans l’enseignement comme dans tout autre domaine. Plutôt que refuser l’outil, les professeurs devraient s’attacher à montrer aux élèves quels bénéfices ils peuvent tirer d’un langageur comme Chat GPT, au-delà de la fraude scolaire ! Pourquoi en effet se priver d’un outil qui produit des résultats intéressants sous certaines conditions d’usage et qui peut donc s’avérer utile dans la formation du savoir ?

Les modalités d’accès aux contenus étant bouleversées dans cette phase nouvelle du progrès technique affectant le registre cognitif, les enseignants doivent se donner pour mission d’aider les étudiants à se repérer dans la masse énorme et mouvante d’informations qui les entoure et parfois les assaille. Par ailleurs, ils doivent les éduquer au bon usage des outils numériques. À l’époque de Leonard de Vinci, chacun pouvait se représenter à peu près convenablement le fonctionnement de toutes les machines alors existantes. Aujourd’hui, il nous est impossible de connaître le fonctionnement de tous les outils que nous utilisons quotidiennement et c’est essentiellement à travers leur usage que nous découvrons leurs bienfaits ou leurs méfaits.

L’objectif éducatif est que les élèves d’aujourd’hui deviennent demain des citoyens responsables de la société numérique, qui maîtriseront l’usage des outils de l’I.A. et œuvreront à leur amélioration, plutôt que des utilisateurs paresseux et passifs, ne faisant que manier automatiquement ces outils, parfois pour le pire. L’homme doit apprendre à ne pas devenir l’instrument de la machine. Il est au contraire indispensable qu’il en maîtrise activement les effets, luttant contre la tendance délétère d’une relégation au rôle de consommateur irréfléchi et asservi, exposé à la désinformation et à la manipulation.

Dans la société numérique, chacun ne détenant qu’une petite parcelle de savoir, la confiance accordée à une source devient une valeur fondamentale. C’est sur la confiance que repose la distinction entre croyance et connaissance. Une majorité de personnes ne sait pas démontrer le théorème de Pythagore mais elle pense à juste titre qu’il est vrai : son auteur l’a jadis prouvé, les professeurs de mathématiques l’enseignent depuis des siècles, donc je peux moi-même raisonnablement attribuer à ce théorème le statut de connaissance et non de simple croyance… Beaucoup de ce que nous tenons pour vrai provient, non pas à notre capacité à le prouver, mais de la confiance que nous accordons à ceux qui nous le transmette. L’École doit donc apprendre aux jeunes à reconnaître les puits d’information auxquels ils peuvent s’abreuver sans risquer l’empoisonnement, à savoir comment soumettre efficacement des requêtes à Google search ou à Chat GPT. L’éducation aux médias doit être étendue au-delà des médias historiques, pour inclure la communication en ligne et les applications issues de l’I.A.

****

Dans la seconde partie de cet article, à paraître très prochainement, nous identifierons les différents risques liés au développement de l’I.A. générative, décrirons les dispositifs d’encadrement en passe d’être mis en œuvre dans différentes parties du monde, avant de dessiner les contours de que pourrait être une régulation française de l’I.A, en conformité avec le cadre européen.

Mots-clés : Intelligence artificielle générative – Grands modèles de langage – Réseaux de neurones – Apprentissage – Syntaxe – Sémantique – Révolution numérique – Régulation

Références

ACADÉMIE DES TECHNOLOGIES, avril 2023, Prouesses et limites de l’imitation artificielle de langages, les agents conversationnels intelligents dont ChatGPT, Avis de l’Académie.

ACADÉMIE DES TECHNOLOGIES, avril 2018, Renouveau de l’intelligence artificielle et de l’apprentissage automatique, Rapport de l’Académie.

- Le beau, le vrai et le bon - 19 décembre 2024

- Faire face à l’invasion du faux !* – Partie 2. Les remèdes technologiques et juridiques - 19 septembre 2024

- Faire face à l’invasion du faux !* – Partie 1. Les pathologies de l’information et leurs impacts - 12 septembre 2024

Commentaires récents