La falsification des faits et la manipulation des croyances ont existé de tout temps, menaçant à la fois la qualité de la connaissance humaine et le fonctionnement des démocraties. La révolution numérique, parce qu’elle mobilise les technologies de l’information et de la communication et qu’elle attise le feu de la circulation et du traitement des données, a offert à ces phénomènes un espace naturel d’expansion : aujourd’hui, Internet est devenu le berceau de contenus déviant dangereusement de la réalité des faits, exposant la société à une véritable intoxication informationnelle. Gérald Bronner, auteur d’un important rapport intitulé « Les lumières à l’ère numérique » (Bronner, 2022), n’hésite pas à qualifier cette situation d’apocalypse cognitive et de crise civilisationnelle.

Dans cet article en deux parties, nous nous efforçons d’apporter des éléments de réponse aux questions suivantes :

- De quelles pathologies souffre aujourd’hui l’information et quels en sont les impacts (partie 1) ?

- De quels remèdes techniques et réglementaires dispose-t-on (partie 2) ?

Les pathologies de l’information

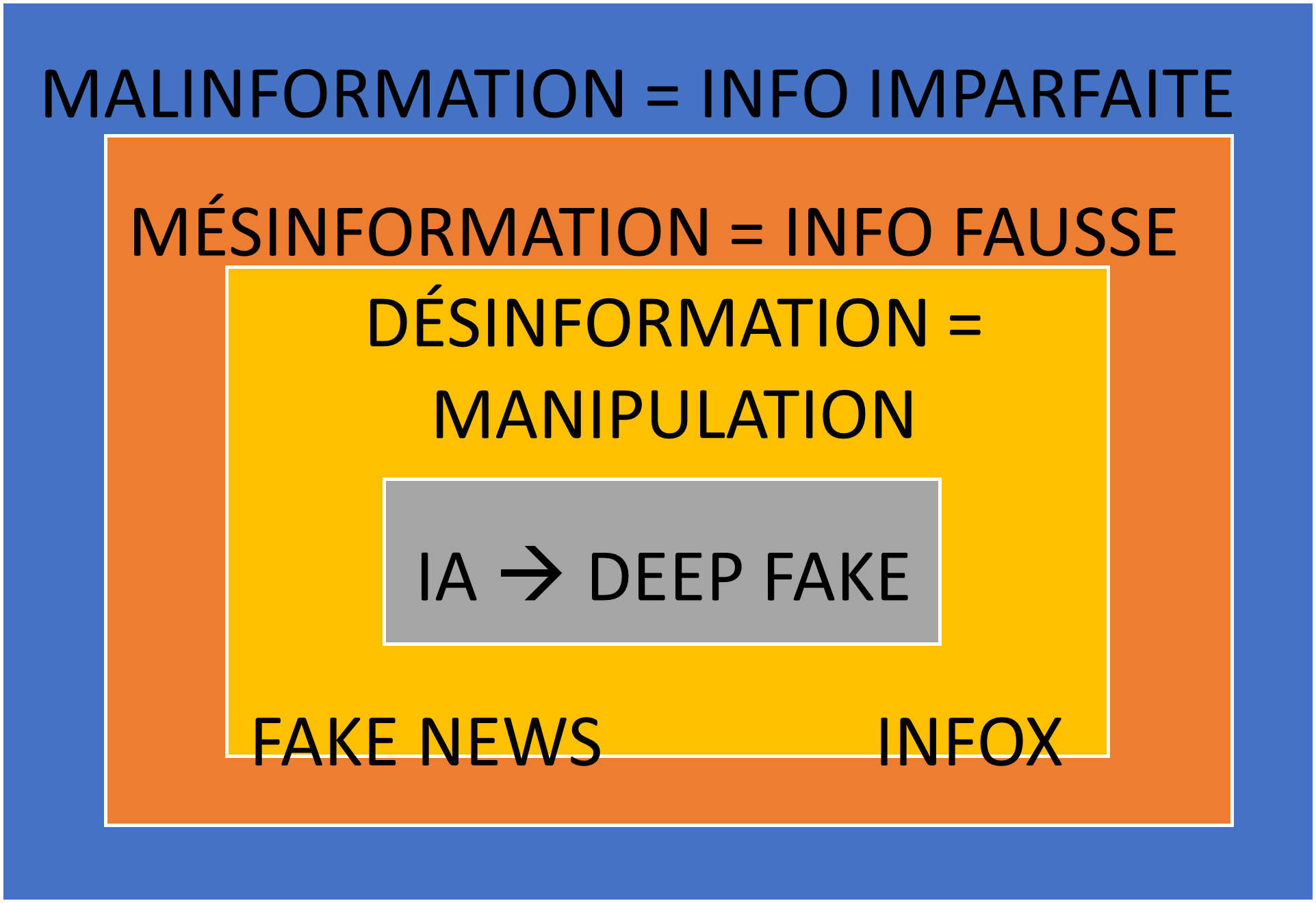

Elles se divisent en trois grandes catégories : l’information qui, sans être à proprement parler inexacte, est incomplète, tronquée ou partisane ; l’information erronée, c’est-à-dire non conforme à la réalité, qu’elle provienne d’une conviction infondée ou d’un défaut de vérification ; et l’information falsifiée dans l’intention délibérée de manipuler les esprits. Selon une structure en poupées russes (cf. schéma), dans les trois cas règne la « mal-information », qui se mue en « mésinformation » dans les deux dernières situations, et en « désinformation » ou « infox », ou encore fake news, dans la dernière. Enfin, un deep fake, ou hyper-trucage (expression canadienne), est une désinformation produite à l’aide de l’intelligence artificielle.

Alarmistes et objectivistes

Les maux informationnels ont fait l’objet de nombreux travaux académiques (Aïmeur, 2023). À une première vague d’articles dont la tonalité est très alarmiste succède aujourd’hui une seconde vague, se voulant plus « objective » et interrogeant de manière critique les analyses produites par la première. Ainsi, les travaux les plus récents ne confortent-ils pas – ou semblent relativiser – des idées apparaissant de prime abord comme des évidences. Ce second courant « objectiviste » met en avant trois principaux arguments, pouvant être résumés comme suit.

Premièrement, « l’argument de pertinence ». L’immense majorité des analyses disponibles, toutes disciplines confondues, se concentre sur l’étude des croyances et des attitudes à court terme des « consommateurs » de mésinformation, sans l’inscrire dans une vision plus large des conséquences de cette exposition amont sur des comportements observables en aval (Murphy, 2023). Et même à ne considérer que l’effet des chambres d’échos sur les croyances, la réalité de cet effet ne serait pas définitivement établie : une étude publiée en 2023 dans Nature à partir de données fournies par Facebook, semble ainsi montrer qu’il ne suffit pas, via des algorithmes, de bombarder un internaute d’informations en opposition avec ses croyances primitives, pour que ces dernières évoluent (Nyhan, 2023).

Deuxièmement, « l’argument méthodologique ». Les résultats obtenus sur la formation des croyances seraient peu robustes, car les études empiriques se heurtent à des difficultés de définition[1], reposent sur des questionnaires déclaratifs, donc peu fiables, ou sur des expériences en laboratoire dont les protocoles sont nécessairement réducteurs et ne permettent qu’un contrôle imparfait des variables en jeu (Berriche, 2024).

Troisièmement, « l’argument volumétrique ». On constate que, rapportée à la durée totale passée à s’informer sur les médias, celle passée en ligne est assez faible, représentant seulement 4,2% aux États-Unis (Allen, 2020), et 3% en France (Cordonier et Brest, 2021). La part d’exposition à la désinformation est encore plus réduite : aux États-Unis, 10 minutes par jour et 0,15 % du temps total de la consommation médiatique en ligne ; en France, 5 minutes par jour et 0,16 % du temps total de connexion à Internet[2]. Une exposition aussi modeste justifie-t-elle que l’on s’en préoccupe à ce point ? De fait, au vu de ces chiffres, un nombre croissant d’analystes estime que les origines de la désinformation et de la polarisation du public résideraient davantage dans le contenu des informations ordinaires, ou dans le fait d’éviter complètement les informations, que dans les fausses informations manifestes ; et que la plupart des fausses informations seraient consommées et partagées par une infime minorité d’utilisateurs sur les réseaux sociaux, qui sont par ailleurs de grands lecteurs des sources fiables.

Ces trois arguments méritent discussion. S’agissant d’abord de l’argument de pertinence, notons que les objectivistes ne font, pour la plupart, que signaler la difficulté, au mieux esquisser les contours d’un futur programme de travail, sans toutefois fournir à ce stade aucun éclairage étayé et convaincant sur le plus ou moins fort degré de conversion d’une exposition à l’infox en altération des comportements : pas davantage que ceux de la première vague, les derniers travaux publiés n’apportent à cet égard des réponses solidement fondées. Remarque similaire, s’agissant de l’argument méthodologique : certes judicieux, il gagnerait en portée s’il s’accompagnait, en positif, d’un guide des bonnes pratiques en matière de collecte des données, d’outils de traitement statistique, et de conduite d’expériences. Enfin, l’argument volumétrique est en partie fallacieux car rien ne prouve que de petites causes ne puissent produire de grands effets, ni que le phénomène de désinformation, aujourd’hui encore sous-critique au sens de la physique des grands systèmes, ne s’approche d’un seuil au-delà duquel il se manifesterait de manière explosive.

La désinformation : un système global

La critique objectiviste ne doit évidemment pas conduire au négationnisme : si elles ne semblent pas avoir jusqu’ici provoqué des cataclysmes de magnitude extrême, la mésinformation et les campagnes de désinformation à travers les réseaux sociaux et les services de messagerie existent bel et bien ! À l’évidence, ces phénomènes ne peuvent – ni ne doivent – être ignorés ou négligés. Il est par ailleurs essentiel de noter, avec les objectivistes, que ces phénomènes sont partie intégrante d’un système plus complexe et plus vaste que celui des seuls échanges en ligne. En effet, la désinformation s’appuie aussi sur les médias « classiques » – dont certaines études montrent spécifiquement l’importance – ainsi que sur les acteurs politiques et économiques. Ce système doit être considéré dans sa globalité (Watts et alii, 2021)[3]. Une étude destinée à expliquer comment la rumeur d’une fraude électorale massive, qui aurait conduit à une victoire factice de Joe Biden en 2020, a pu se diffuser et s’ancrer, a mis en évidence qu’elle a d’abord été orchestrée par la galaxie Fox News et des membres du parti républicain, avant d’être relayée par les réseaux sociaux (Benkler et alii, 2020).

Des discours contrastés des alarmistes et des objectivistes, on peut en définitive tirer deux constats. D’une part, les rouages de la désinformation, ainsi surtout que leurs conséquences, sont animés par des mécanismes encore mal connus, qui relèvent à la fois de considérations politiques, économiques et psychosociales. D’autre part, au-delà de la seule confiance dans les réseaux sociaux, ce qui est ébranlé par les comportements de manipulation informationnelle, en ligne comme hors ligne, c’est la confiance dans les institutions démocratiques. Cette confiance se rapporte aussi bien aux réseaux sociaux qu’aux journalistes et aux personnels politiques : « La vérité est devenue une question politique » (Origgi, 2024). La désinformation et les « vérités alternatives » sapent la confiance et polarisent les débats. Dans ce contexte global, les technologies numériques représentent un des facteurs à prendre en considération, mais pas le seul, pour proposer des solutions à la désinformation et à la perte de confiance dans les démocraties.

Les progrès de l’IA changent-ils la donne ?

L’IA générative, si facile à utiliser avec des résultats aussi impressionnants au regard d’un coût modéré, va-t-elle amplifier la désinformation, va-t-elle en modifier sensiblement les modalités ? Des deep fakes récents, tels la tenue Balenciaga du Pape ou les montages pornographiques de Taylor Swift, pourtant rapidement identifiés, ont fait le tour du monde. Annoncent-ils un nouvel embrasement, une démultiplication de fake news de plus en plus ciblées et aux conséquences délétères ? S’il est encore trop tôt pour répondre, on peut tout au moins préciser les tenants de la question.

En premier lieu, les outils de l’IA générative perfectionnent indubitablement la « qualité » de « l’offre » de désinformation, en permettant la production de contenus artificiels de plus en plus réalistes, donc trompeurs. Selon que l’on se range du côté des alarmistes ou des objectivistes, on estimera que cette amélioration de l’offre, cette sorte de « mésintelligence artificielle** », est susceptible de déclencher en retour une avalanche de la « demande » de désinformation, à la manière dont un gaz se détend brusquement lorsqu’on cesse de le comprimer, ou au contraire que cette demande a déjà atteint un plafond de saturation dans l’état actuel de l’art de la désinformation et qu’elle ne s’emballera donc pas. Imaginer un entre-deux paraît raisonnable.

En second lieu, des outils d’IA autres que l’IA générative augmentent la capacité de dissémination des contenus artificiels. Il est notamment désormais possible de créer de toutes pièces un réseau d’agents conversationnels non humains (chatbots), qui échangent entre eux en n’émettant que des contenus factices engendrés par l’IA générative, ciblés de manière à attirer l’attention de visiteurs humains en vue de leur lessiver le cerveau. Cette nouvelle faculté algorithmique est en particulier propice à l’essor de l’astroturfing, littéralement « gazonnage artificiel », consistant à faire passer pour un mouvement d’opinion spontané ce qui n’est, en réalité masquée, qu’une désinformation organisée.

S’agissant du premier aspect, à savoir le nouveau visage de l’offre de désinformation, l’Observatoire européen des médias numériques (EDMO)[4] a évalué de manière systématique les risques à anticiper pour les élections de 2024, en fonction du support : texte, voix, image et vidéo. Selon l’Observatoire, les faux enregistrements sonores créés par l’IA sont les plus problématiques, car à la fois les plus difficiles à reconnaître et les plus susceptibles de piéger les internautes (Canetta, 2024). Le risque apparaît moindre pour les textes, bien que les outils de détection soient assez peu performants sur des écrits très courts, comme les messages échangés sur la plateforme X. Les images et vidéos artificielles, de qualité encore assez imparfaite, demeurent humainement identifiables, à l’exception de vidéos « décontextualisées », marginalement modifiées au niveau de l’image et du son (Weikmann, 2023).

S’agissant du second aspect, à savoir le perfectionnement des modalités de circulation de l’infox, les réseaux sociaux pourraient de ce fait voir leur crédibilité contestée encore davantage. En effet, leurs algorithmes de hiérarchisation et priorisation des contenus jouent un rôle significatif et caché dans les modalités de désinformation, si bien que l’opacité supplémentaire amenée par les outils d’IA, alliée à la difficulté à discerner qui a vraiment produit un contenu, pourrait augmenter la méfiance à leur égard. La publication en ligne ‘404 Media’ fait une description de Facebook laissant entrevoir les risques encourus : « Facebook est l’internet des zombies, où un mélange de robots, d’humains et de comptes qui ont été humains mais ne le sont plus, interagissent pour former un site web désastreux où il n’y a que très peu de liens sociaux »[5]. Moins extrême, The Economist a récemment prédit la fin des réseaux sociaux sous leur forme historique, constatant la disparition des informations dans les fils d’actualité, le redéploiement vers des réseaux fermés, ainsi que la transformation des utilisateurs participatifs en consommateurs de flux vidéo impersonnels.[6]

Restant fondamentalement basée, d’une part sur la falsification de contenus, d’autre part sur l’utilisation de faux comptes, l’économie de la désinformation sur les réseaux sociaux et les systèmes de messagerie n’est certes pas ébranlée par l’IA au niveau de ses soubassements. En revanche, ce que renforce fortement l’IA, c’est la crédibilité du faux, ainsi que l’efficacité et le ciblage des campagnes. Il serait naïf de penser que, puisque le principe moteur de la désinformation reste invariant, le changement d’ordre de grandeur de certains paramètres n’aura pas d’effets notables : filant une métaphore physique, la loi de la gravitation universelle s’applique pareillement sur la Terre et sur la Lune… et pourtant, l’intensité de la pesanteur n’y étant pas du tout la même, les conditions de locomotion sont très différentes sur chacun des deux astres !

Dans la seconde partie de cet article, nous présenterons les instruments de lutte contre la désinformation, de natures technologique et règlementaire.

À suivre…

Mots-clés : Malinformation – Mésinformation – Désinformation – Fake news – Deep fakes – Intelligence artificielle – Élections – Croyances – Comportements.

* Cet article en deux parties est tiré d’une conférence donnée par l’auteur lors d’une soirée-débat sur le thème « IA générative et mésinformation : un cataclysme… ou pas ? », organisée le 13 juin 2024 par l’association ENSAE Alumni, dans le cadre de son cycle Data &IA. L’article s’inspire par ailleurs des travaux actuellement menés par le groupe de travail « Mésinformation et IA générative », piloté par l’auteur au sein de l’Académie des technologies ; que soient ainsi remerciés les membres de ce groupe, en particulier Chantal Jouanno, Joëlle Toledano et Winston Maxwell, dont les apports ont nourri la conférence comme l’article. Enfin, ce texte complète et enrichit deux articles précédemment parus dans Variances : le premier, datant de juin 2023, porte sur les récents développements de l’IA : « Que faut-il connaître, espérer et craindre de l’intelligence artificielle générative ? », partie 1 « Qui est-elle et que fait-elle ? », partie 2 « Quels risques, quelles régulations » (juin 2023) ; et le second, datant de mai 2020, aborde la crise de la cognition : « Connaissance à l’ère numérique : la possibilité du vrai ? » .

** selon la trouvaille d’une amie qui se reconnaîtra.

Références

Aïmeur, Esma, Sabrine Amri, and Gilles Brassard. “Fake News, Disinformation and Misinformation in Social Media: a Review”, Social Network Analysis and Mining 13.1: 30 (2023).

Allen, Jennifer, et alii, “Evaluating the Fake News Problem at the Scale of the Information Ecosystem”, Science advances 6.14: eaay3539 (2020).

Altay, Sacha, Manon Berriche et Alberto Acerbi. “Misinformation on Misinformation: Conceptual and Methodological Challenges”, Social media+ society 9.1: 20563051221150412 (2023).

Benkler, Yochai, et alii, “Mail-in Voter Fraud: Anatomy of a Disinformation Campaign”, Berkman Center Research Publication 2020-6 (2020).

Berriche, Manon et Jean-Philippe Cointet, intervention à l’Académie des technologies, Des fake news aux troubles de l’information : résultats empiriques et enjeux méthodologiques (2024).

Bronner, Gérald, Les lumières à l’ère numérique, Presses Universitaires de France (2022).

Canetta, Tommaso, Prebunking AI-generated disinformation ahead of EU elections, EDMO (2024).

Cordonier, L. et A. Brest, Comment les Français s’informent-ils sur Internet ? Analyse des comportements d’information et de désinformation en ligne, Étude de la Fondation Descartes (2021).

Murphy, Gillian, et alii, “What do we Study when we Study Misinformation? A scoping review of experimental research (2016-2022)”, Harvard Kennedy School Misinformation Review (2023).

Nyhan, B., Settle, J., Thorson, E. et alii. “Like-minded Sources on Facebook are Prevalent but not Polarizing”, Nature 620, 137–144 (2023).

Origgi, Gloria, La vérité est une question politique, Albin Michel, 2024.

Watts, Duncan J., David M. Rothschild, and Markus Mobius. “Measuring the News and its Impact on Democracy”, Proceedings of the National Academy of Sciences 118(15) e1912443118 (2021).

Weikmann, Teresa, Sophie Lechler, S. (2023). “Cutting through the Hype: Understanding the Implications of Deepfakes for the Fact-Checking Actor-Network”, Digital Journalism, 1–18 (2023).

[1] Les fake news sont le plus souvent définies par défaut, comme les contenus signalés problématiques par les fact checkers.

[2] Il s’agit de moyennes, cachant une grande disparité : à un extrême, les plus grands consommateurs d’information lisent toutes sortes de contenus, en particulier de façon importante les sources les plus fiables ; tandis qu’à l’autre extrême, un nombre significatif de nos concitoyens ne s’informent pas du tout, quel que soit le support. Dans le cadre de l’étude de Cordonier et Brest, 5% des participants se sont informés en ligne pendant plus de dix heures au total sur le mois de l’expérience, alors qu’une minorité sensible (17%) ne s’est pas du tout intéressée à l’information accessible sur les médias en ligne. Par ailleurs, 39 % des participants ont consulté des sources d’information jugées non fiables et ils y ont passé en moyenne 11 % de leur temps quotidien d’information sur Internet, soit 0,4 % de leur temps total de connexion. Sur l’ensemble des participants, le temps passé sur des sources d’information jugées non fiables représente 5 % du temps total d’information en ligne, soit 0,16 % du temps total de connexion à Internet.

[3] “Although neither prevalence nor consumption is a direct measure of influence, this work suggests that proper understanding of misinformation and its effects requires a much broader view of the problem, encompassing biased and misleading – but not necessarily factually incorrect – information that is routinely produced or amplified by mainstream new organizations.”

[4] EDMO (European Digital Media Observatory) est un collectif européen, dont la déclinaison française est DE FACTO (https://defacto-observatoire.fr/Main/#). Ce collectif soutient des réseaux indépendants travaillant sur la désinformation. L’ensemble des États membres de l’Union européenne sont désormais rattachés à un hub et bénéficient d’un cofinancement par la Commission européenne, dans le cadre du programme Connecting Europe Facility.

[5] https://www.404media.co/404-media-podcast-37-facebook-zombie-internet/

[6] The Economist, February 3rd 2024, “The end of the social network » et « Not posting, but watching”.

- Le beau, le vrai et le bon - 19 décembre 2024

- Faire face à l’invasion du faux !* – Partie 2. Les remèdes technologiques et juridiques - 19 septembre 2024

- Faire face à l’invasion du faux !* – Partie 1. Les pathologies de l’information et leurs impacts - 12 septembre 2024

Commentaires récents