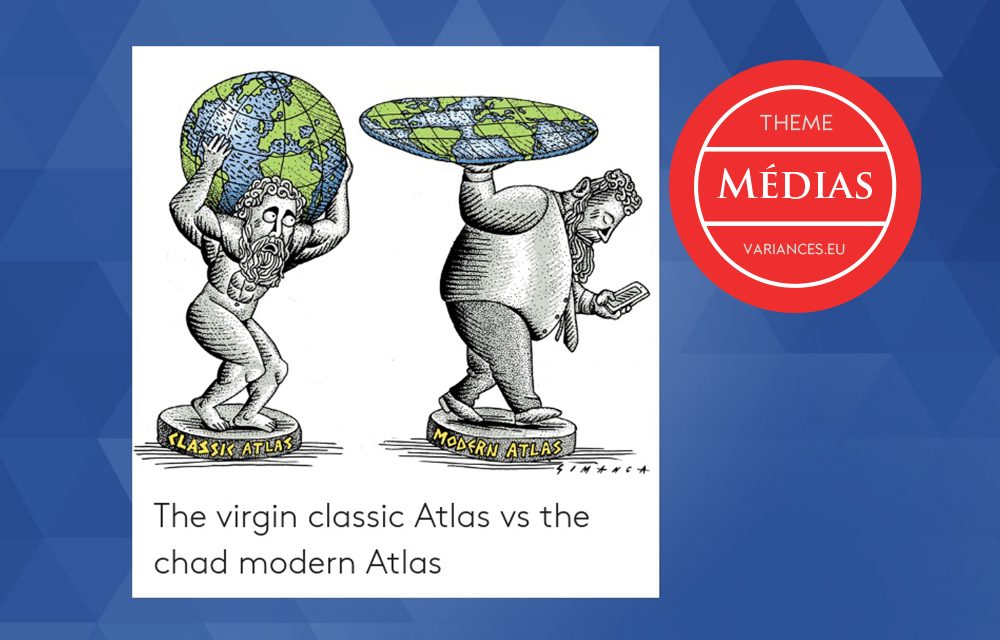

Selon le titre percutant du livre de David Weinberger, Everyday Chaos [1], Internet a semé le chaos dans nos vies, en bouleversant la manière dont nous interagissons et communiquons, celle dont nous accédons à l’information et à la connaissance. L’auteur et conférencier, aux airs tantôt d’amuseur tantôt de prophète, aux accents tantôt plaisants tantôt inquiétants, nous donne à réfléchir sur la manière nouvelle dont nous exerçons nos fonctions cognitives à l’ère numérique. Il se joint ainsi à d’autres lanceurs d’alertes et repentis de la Silicon Valley, pour nous inviter à mieux penser la mutation en cours de l’homo sapiens en homo digitalis. Cette évolution n’est pas sans poser question, pour peu que l’on observe l’Atlas moderne illustrant cet article qui, lourdement frappé « d’infobésité » et de « nomophobie » (l’incapacité à se séparer de son smartphone), porte à bout de bras un monde qu’il voudrait nous faire croire plat !

Du rêve à la désillusion

Dans les années 90, John Perry Barlow, par sa Déclaration d’indépendance du cyberespace [2], se posait en père de l’internet libre. Il portait haut et fort l’utopie libertaire d’un espace en ligne placé sous le signe du savoir, du partage, du dialogue, de la communauté d’intérêts. Pour lui, la connexion universelle apparaissait comme la promesse d’une intelligence collective supérieure à la somme des intelligences individuelles, une sorte de « sagesse des foules », selon l’expression ensuite popularisée par le journaliste américain James Surowiecki [3].

Afin d’illustrer la « force de la multitude », Surowiecki relate le constat, dressé hors de l’univers numérique et dès 1906, par l’anthropologue et mathématicien britannique Francis Galton. Celui-ci, à l’occasion d’un concours organisé lors d’une foire au bétail, observa que la moyenne statistique des évaluations du poids d’un bœuf, indépendamment émises par quelque huit cents experts, approchait à un millième près la valeur exacte ! Bien que chaque expert fût individuellement dans l’erreur, l’assemblée disait le vrai.

Sous une forme empreinte de spiritualité, on trouve encore la trace de la sagesse des foules dans la cosmologie de Teilhard de Chardin [4], père jésuite et paléontologue, qui imaginait la fusion des intelligences individuelles au sein d’une « noosphère », pénultième étape de l’évolution terrestre, succédant à la géosphère puis la biosphère et précédant l’ultime aboutissement de la « christosphère », point oméga de la communion avec l’esprit divin.

Mise en regard de la perspective vertigineuse d’une connaissance universelle permise par l’interconnexion, la réalité quotidiennement vécue en ligne a de quoi sérieusement décevoir. Caricaturant à peine, le faux y apparaît comme la règle et le vrai, comme l’exception. Les faits sont souvent reconstruits pour soutenir les argumentaires, et non pas les argumentaires fondés sur les faits. Chacun profère à foison des opinions, sincères ou non, en ignorant la réalité, voire en la contrefaisant ou en l’inventant, afin de la rendre plus spectaculaire et donc plus attractive : if it bleeds it leads !

Fort heureusement, certains n’ont pas renoncé à poster des faits vérifiés, à l’instar des contributeurs de l’encyclopédie Wikipedia. Ils ne doivent cependant pas nourrir d’illusions excessives quant à leur capacité à faire prévaloir le vrai et ils ne sont d’ailleurs guère incités à persévérer dans cette voie, sans gratification autre que symbolique de leur comportement vertueux. Sur internet, l’opinion est gratuite et libre, les statuts de l’expert et du charlatan sont mis sur un pied d’égalité et, même démasqué, le faussaire demeure influent.

Une cruelle déception, certainement, mais non pas une surprise, car la manipulation de l’information n’a rien d’un phénomène émergent. En 1938, sur la radio CBS, l’acteur Orson Welles, alors âgé de 23 ans, fait la lecture de passages suggestifs de l’ouvrage de Herbert George Wells, « La guerre des mondes », en lieu et place des habituels flashs d’information. Malgré une discrète mention liminaire précisant la source du prétendu reportage, le canular prend et il déclenche un vent de panique au sein d’une bonne partie de la population américaine, persuadée qu’une invasion extraterrestre est en marche ! Rien de radicalement différent aux temps numériques, si ce n’est un puissant effet de viralité, accélérant grandement la propagation des fausses nouvelles, « l’infox », et amplifiant considérablement la gravité des conséquences possibles : falsification des résultats d’une élection, menace portée contre les intérêts fondamentaux d’une nation.

Le virus infox

Pourquoi l’utopie d’un internet communautaire et vertueux se trouve-t-elle pareillement dévoyée ? Parce qu’une logique commerciale a supplanté la logique communautaire des débuts du web en s’appuyant sur les ressorts de l’économie de l’attention, nous explique Bruno Patino dans un livre à la fois sombre et éclairant, « La civilisation du poisson rouge » [5]. L’objectif des géants du net est de capter l’audience, afin de drainer les revenus publicitaires et d’accroître la consommation en ligne. À cet effet, leur stratégie consiste à plonger le poisson que nous sommes dans le bocal numérique et à l’y maintenir le plus longtemps possible, le laissant complaisamment se nourrir d’un appétissant granulé… composé de messages à faible teneur (bullshit), faciles à écrire, possiblement faux et nocifs. C’est dans cet écosystème vicié par la quête du gain, que naît et se répand l’infox sur nos écrans.

Soit ! Mais pourquoi ce virus contre-informationnel prospère-t-il dans la durée ? Pourquoi des anticorps ne se forment-ils pas ? Pourquoi le système de circulation des informations n’engendre-t-il pas spontanément les mécanismes de son autorégulation ?

À travers une même métaphore économique, celle du « libre-échange des idées », John Milton [6] au milieu du 17ème siècle et John Stuart Mill [7] au milieu du 19ème, entendant dénoncer la censure, prônent les vertus des libertés d’expression et de communication : à la manière dont le libre-échange conduit naturellement à l’élimination des biens de piètre qualité, le libre-échange des idées devrait logiquement, selon eux, faire triompher les messages vrais des messages faux. Certes, mais à la condition expresse que vérité et tromperie luttent à armes égales. Or, en ligne, le combat n’est ni équitable ni loyal : sur un sujet donné, le message vrai est unique et il est communiqué une seule fois, alors que les messages faux sont multiples, répétés et clonés à l’envi, quasiment sans coûts, en autant d’exemplaires qu’il est nécessaire pour les faire briller, les rendre crédibles et populaires.

Comme rempart contre « l’infox », l’ouverture présumée d’internet, à la manière de la perfection réputée du marché, n’est hélas qu’un leurre, car les individus recherchent en ligne des contenus qui confortent leur propre opinion, déjà formée, selon l’image d’une chambre d’échos. Un tel comportement ne fait d’ailleurs que prolonger un déterminant majeur des échanges naturels en face à face : les interlocuteurs y évitent à dessein les thèmes de potentiel désaccord, privilégient les terrains d’entente assurés, se confortent mutuellement dans des oppositions ou des insatisfactions communes face au « reste du monde », au risque de rendre la conversation factice. Sur internet, les pseudo-conversations dirigées contre des tiers sont invasives et dégénèrent fréquemment en violence, sous l’ombrelle de l’anonymat. La « sérendipité », ou cheminement improvisé de site en site, ne suffit pas à changer la donne car, confronté à une multitude de sources d’information alternatives, l’internaute se tourne invariablement vers les messages avec lesquels il se sent le plus en accord.

Au phénomène de renforcement des opinions par l’effet d’écho, s’ajoute celui de leur divergence par un effet papillon, au sens de la théorie des catastrophes. Ainsi, des études expérimentales, menées à l’université auprès de groupes d’étudiants, révèlent que, sur les réseaux sociaux, des profils quasi-identiques au moment de leur création se différencient très fortement après seulement quelques semaines, en termes de contenus proposés, consultés et soumis. De l’exacerbation de petits écarts initiaux, émergent rapidement polarisation et radicalisation.

Afin de modérer l’ampleur de ces phénomènes, les entreprises gestionnaires de réseaux sociaux ont instauré des « règles de langage » (rules of speech). On peut cependant douter de l’efficacité d’un dispositif s’appliquant indistinctement à une multitude de discours formant un corpus très hétérogène. Est-il pertinent de jouer une même partition correctrice sur des registres aussi différents que les messages d’information, les fils conversationnels, ou encore les contenus sponsorisés ? Sur les réseaux en ligne, le hiatus entre le simplisme d’une gouvernance unifiée et la variété des types de contributions est problématique.

Dans la lutte contre la dissémination de l’infox, les réseaux sociaux ne sont pas pour autant inactifs. Ils confient en partie à des « agents intelligents », c’est-à-dire à des robots, le soin de reconnaître les comptes dépourvus de titulaires servant de relais aux hackers pour propager leurs messages nuisibles. On peut d’un côté s’en réjouir mais, de l’autre, s’en inquiéter ! Si, demain, le faux devient encore plus envahissant qu’aujourd’hui, les robots se multiplieront, qu’ils soient pollueurs ou nettoyeurs de l’espace numérique. Les nettoyeurs ne risquent-ils pas alors de décréter déviants, puis de supprimer, des comptes « normaux », administrés par de loyaux contributeurs humains, néanmoins devenus minoritaires et, de ce fait, suspects ? Il en résulterait, par effet domino, un effondrement total du système de partage en ligne !

La dictature des algorithmes

Les plateformes et les réseaux sociaux structurent le marché de l’information à travers leur pouvoir régalien d’ordonnancement des contenus. Bien que ces acteurs affirment ne pas être des éditeurs, ils agissent pourtant comme des prescripteurs de vérité, lorsqu’ils mettent en avant certains contenus, accélérant ainsi leur diffusion. De manière plus ou moins arbitraire et le plus souvent non transparente, ils attribuent aux contenus des « rangs ordinaux », qui déterminent leur visibilité. Un statut sui generis, à mi-chemin entre leur actuel statut d’hébergeur et celui d’éditeur, devrait être attribué à ces entreprises numériques : un statut qui les rendent davantage comptables des effets sociétaux qu’elles induisent via leurs algorithmes, que de la matière même qu’elles véhiculent.

Dès lors, la question la plus cruciale, en matière de lutte contre les messages indésirables, qu’il s’agisse d’infox comme de contenus haineux ou discriminatoires, n’est pas tant le « quoi ? » ni le « qui ? », mais le « comment ? » : ce qui est partagé et qui le partage importent moins, en définitive, que la manière dont ces contenus sont poussés par les algorithmes d’ordonnancement.

Or, comme le montrent notamment le psychosociologue Gérald Bronner [8] et la numéricienne Aurélie Jean [9], ces algorithmes présentent des biais systémiques, qui s’ajoutent à nos biais cognitifs naturels. Fondés sur l’analyse statistique des parcours effectués sur le web, ils se montrent très sensibles à l’hyperactivité de certaines minorités. Ainsi, la communauté « anti-vaccins », très active en France (du moins avant la crise sanitaire du covid-19), a acquis une résonance en ligne excédant largement la part que son degré de radicalité aurait dû lui réserver. De même, dans le domaine politique, des sondages exclusivement basés sur des échantillons d’internautes auraient donné François Asselineau large vainqueur de l’élection présidentielle de 2017, en raison de la suractivité de ses militants.

À défaut d’une intelligibilité des critères sous-jacents à leur élaboration, les résultats fournis par les algorithmes peuvent prêter à des interprétations erronées, du type : « Amazon prescrit des livres conspirationnistes ! ». Bien qu’il soit malaisé de le prouver avec certitude, un faisceau d’indices conduit à penser que le biais provient ici de la présence et de la surpondération de l’indicateur quantitatif « nombre de précommandes enregistrées sur amazon.com », parmi les paramètres directeurs d’un célèbre moteur de recherche. Or les amateurs de complot et de sensationnel commandent massivement sur ce site leurs ouvrages de prédilection, faisant mécaniquement monter Amazon au premier rang des réponses à des requêtes liées aux thèses conspirationnistes. À défaut de prescrire l’infox, Amazon bénéficie fort opportunément d’un effet d’avalanche commerciale, enclenché par un algorithme biaisé qui rabat vers son site une catégorie particulière d’internautes.

Moralité : afin de devenir plus pertinents, plus neutres, plus loyaux, plus éthiques, les algorithmes doivent varier davantage leurs données d’entrée et leurs critères de sélection. Mais comment parvenir à ce résultat, sachant qu’une transparence totale n’est pas exigible, afin de préserver l’incitation à l’innovation dans les domaines stratégiques du big data et de l’intelligence artificielle.

Quelle régulation ?

Si une intervention apparaît à l’évidence nécessaire, elle ne doit pas opérer directement, via une censure a priori des contenus indésirables, mais indirectement, via une régulation des plateformes numériques portant ces contenus. En France, la loi du 22 décembre 2018 sur la lutte contre la manipulation de l’information dispose que les compétences du Conseil supérieur de l’audiovisuel (CSA) sont désormais étendues au champ numérique et elle dote cet organisme de régulation d’un pouvoir nouveau de supervision des instruments que les plateformes mettent elles-mêmes en œuvre afin d’enrayer la prolifération de l’infox.

Se conformant à la loi, le CSA a publié en mai 2019 une « recommandation » [10] qui s’applique de manière contraignante aux plateformes dépassant cinq millions de visiteurs uniques mensuels, tenues à cet effet de désigner chacune un interlocuteur référent pour la France. Le Conseil s’est concomitamment doté d’une équipe-projet et s’est entouré d’un comité d’experts, consacrés à la lutte contre l’infox. Six principales exigences charpentent la recommandation, sur chacune desquelles les opérateurs de plateformes doivent rapporter annuellement auprès de l’autorité de régulation, sur la base d’un questionnaire détaillé [11].

- Mettre à la disposition des internautes une procédure de signalement des contenus suspects qui soit aisément accessible, ergonomique et si possible harmonisée entre plateformes.

- Rendre transparents et explicables les algorithmes utilisés pour prescrire les contenus présentés et les ordonnancer ; indiquer les critères sous-jacents aux choix effectués ; informer d’éventuelles modifications de ces critères ; préciser les degrés de liberté laissés à l’internaute pour les ajuster par lui-même.

- Promouvoir et signaler, par des marqueurs clairement apparents, les contenus ayant fait l’objet d’un fact checking, typiquement ceux produits par des organes de presse ou des entreprises de médias ; faire en sorte que ces contenus réputés fiables soient privilégiés par les algorithmes.

- Détecter les comptes relayant massivement de fausses informations ; dans le plus grand respect possible de la liberté d’expression, prendre des mesures appropriées et proportionnées, afin de réduire l’activité de ces comptes : avertissement, isolement, limitation de droits, ou retrait ; informer les utilisateurs sur les motifs d’intervention de la plateforme.

- Distinguer explicitement les contenus sponsorisés des autres contenus, avertir les utilisateurs de leur nature, de leur origine, des raisons de leur sélection et des éventuels signalements dont ils auraient pu faire l’objet.

- Développer et encourager les initiatives d’éducation à la lutte contre l’infox ; aider les utilisateurs à repérer par eux-mêmes les sources d’information les plus sûres, leur proposer des tutoriels utiles à la vérification des faits ; nouer des partenariats avec les services d’éducation aux médias ; soutenir les initiatives émanant de journalistes ou d’universitaires, visant à une meilleure compréhension et à une meilleure prise de conscience des rouages de la manipulation de l’information.

La dernière de ces mesures, l’incitation et l’éducation à l’exercice de l’esprit critique, n’est pas la moindre. Elle est tout à la fois la moins coercitive, la plus préservatrice de la liberté d’expression et, vraisemblablement, la plus propice à un retour vers la promesse originelle d’une économie de la connaissance.

Pour endiguer la pandémie du faux, le geste barrière le plus efficace réside dans la « distanciation cognitive », c’est-à-dire la pratique du doute systématique. Selon les termes du précieux précepte du mathématicien et philosophe Bertrand Russell : « L’ennui, en ce monde, c’est que les imbéciles sont sûrs d’eux et les gens sensés, pleins de doutes. Ne soyez jamais absolument certains de quoi que ce soit ! ». Méditons, dans la même veine, cette édifiante formule de l’astrophysicien britannique Stephen Hawking : « Le plus grand ennemi du savoir n’est pas l’ignorance, mais l’illusion du savoir ! ».

En guise de chute, mais peut-être aussi d’élévation, pensons enfin à l’allégorie de la caverne de Platon. Le monde manifeste n’est qu’un faux-semblant du monde vrai. Afin d’accéder à la lumière authentique de la vérité, le sage doit prendre un recul salutaire, passer derrière le feu et le voile d’internet, qui ne cessent de projeter sur nos écrans des ombres fallacieuses !

Mots clés : transition numérique – infox – algorithmes – régulation – esprit critique

Références

[1] David Weinberger, Everyday Chaos: Technology, Complexity and How We’re Thriving in a new World of Possibility, Harvard Business Review Press, 2019.

[2] John Perry Barlow, Déclaration d’indépendance du cyberespace, Forum de Davos, 1996.

[3] James Surowiecki, The Wisdom of Crowds : Why the Many Are Smarter Than the Few and How Collective Wisdom Shapes Business, Economies, Societies and Nations, Little Brown, 2004.

[4] Pierre Teilhard de Chardin, Le phénomène humain, Seuil, 1955.

[5] Bruno Patino, La civilisation du poisson rouge : petit traité sur le marché de l’attention, Grasset, 2019.

[6] John Milton, Areopagitica, 1644.

[7] John Stuart Mill, De la liberté, 1859.

[8] Gérald Bronner, L’empire des croyances, PUF, 2003.

[9] Aurélie Jean, De l’autre côté de la machine : voyage d’une scientifique au pays des algorithmes, L’observatoire, 2019.

[10] CSA, Recommandation du CSA sur la lutte contre la manipulation de l’information, 15 mai 2019. https://www.csa.fr/content/download/254193/732998/version/2/file/CSA%20-%20Reco%202019-03.pdf

[11] CSA, Questionnaire aux opérateurs de plateformes en ligne soumis au titre III de la loi du 22 décembre 2018 relative à la lutte contre la manipulation de l’information, 27 février 2020.

- Le beau, le vrai et le bon - 19 décembre 2024

- Faire face à l’invasion du faux !* – Partie 2. Les remèdes technologiques et juridiques - 19 septembre 2024

- Faire face à l’invasion du faux !* – Partie 1. Les pathologies de l’information et leurs impacts - 12 septembre 2024

Je prefere me former ma propre opinon et ne pas laisser aux Etats et aux regulateurs du genre de l auteur de l article le soin de me dire quoi penser et quelle verite est bonne a lire. Lutter a armes egales, cela ne veut pas dire donner aux puissants Etats et a leurs aparatchiks dans votre genre le monopole de la verite, bien au contraire. Vous et vos complices mentez sans doute plus que la moyenne, pour notre bien bien sur.

Si vous relisez l’article, vous constaterez que nous sommes en plein accord : c’est bien à chacun de penser par lui même en exerçant son sens critique face au flot de données plus ou moins fiables qu’il reçoit de toute part !

La ‘dictature’ des algorithmes … pff

ce sont des personnes qui implémentent ces méthodes des résolutions de problèmes, à l’aide d’ordinateurs, ces automates programmables ….

et personne n’est obligé d’utilisé quelque service que ce soit sur internet ; ça aide aussi d’accepter les conséquences de ses choix parfois …

Sur votre premier point, je suis entièrement d’accord : ce sont bien des humains qui programment les machines et si les logiciels ne sont pas « loyaux », soit ils reproduisent des biais humains non intentionnels, soit ils sont sciemment orientés pour mieux satisfaire les objectifs de certains acteurs.

Sur le second point, personnellement je ne sais pas comment m’affranchir des algorithmes sur internet, à moins bien-sûr de me déconnecter !