Dans cet article, j’aborde quelques problèmes des sondages d’opinions rencontrés tant dans les pratiques que dans les conceptions, en me concentrant sur les sondages d’intentions de vote étant donné le rôle important qu’ils tiennent dans le jeu électoral.

La « méthode » des quotas et l’aléatoire

Chacun a pu lire dans la presse la mention « sondage représentatif selon la méthode des quotas » qui accompagne tout sondage publié. L’usage de quotas a été empiriquement introduit par le Norvégien Anders N. Kiaer[i] à la fin du dix-neuvième siècle dans ce qu’il a appelé « la méthode représentative », laquelle proposait également un volet aléatoire. La communauté scientifique est restée partagée entre la méthode raisonnée ou judicieuse, reposant essentiellement sur les quotas, et la méthode aléatoire. En 1934, Jerzy Neyman[ii] a théorisé la méthode représentative qui correspondait alors à un plan stratifié où l’on échantillonne aléatoirement indépendamment dans des strates de la population, avec des effectifs proportionnels à ceux des strates, typiquement des strates géographiques, en montrant le gain en précision que l’on pouvait en tirer. Nous, statisticiens, avons gardé le terme représentatif uniquement en référence à ce plan de sondage alors que les sociologues, acteurs majeurs des sondages d’opinion, ont occulté toute référence à l’aléatoire.

Ainsi, aujourd’hui encore, les traités de sciences sociales mentionnent qu’il existe deux méthodes de sondage : la méthode aléatoire et la méthode des quotas pour laquelle on utilise encore le concept de méthode raisonnée. Cette vision dichotomique est d’ailleurs une spécificité française. Elle joue sur l’ambiguïté du terme « représentatif » qui porte à croire que la réalisation de quotas est une condition suffisante pour faire un « bon » échantillon. Chez les sociologues, les politologues, les journalistes, sans parler du grand public, quotas riment avec représentativité et donc bon échantillon, ce qui ne peut évidemment que satisfaire les sondeurs. Peu importe que les quotas sur quelques variables socio-économiques n’empêchent pas des biais sur d’autres variables et notamment les variables à estimer, que la « méthode » ne précise pas où ni comment aller rechercher les individus. Il est difficile de faire admettre que la recherche d’aléatoire pour la sélection des individus, en amont des contraintes de quotas, reste une priorité. Il serait sain de substituer aux termes « méthode des quotas » les termes de contraintes de quotas.

Pour le profane, la représentativité est un concept intuitif s’accompagnant de l’idée séduisante d’un « modèle réduit » de la population. Il entend que l’échantillon est représentatif en soi, à partir d’un cadrage sur quatre ou cinq variables socio-économiques standard (alors que la théorie voudrait que l’on sélectionne des variables de quotas qui soient les plus corrélées possible à l’objet de l’étude). Pour un statisticien, la notion de représentativité n’a pas de définition au-delà du sens conventionnel utilisé par Neyman. Un bon échantillon en statistique est un échantillon obtenu par un plan aléatoire, ou proche de l’aléatoire en pratique. Pour une variable à estimer donnée, le plan optimal est celui qui estime avec une variance minimale. Au sens commun, l’idée de sélectionner au hasard est plutôt connotée négativement, car le hasard est souvent lié à l’inconnu, au chaos, au manque de maîtrise. Démontrer à un non-spécialiste que le hasard fait bien les choses, qu’une estimation n’est jamais loin de la vraie valeur inconnue – ceci d’autant plus que la taille de l’échantillon augmente – est assez aisé si ce dernier n’a pas de blocage vis-à-vis des aspects techniques. Puis on en arrive au fait essentiel, à savoir qu’un échantillon aléatoire permet d’obtenir des estimations sans biais quelles que soient les variables à estimer. Une définition de la représentativité pourrait se rapporter simplement à cette capacité de produire des estimations sans biais.

L’irruption des access panels

Jusqu’à 2005 environ, les sociétés de sondages traditionnelles maintenaient l’effort de l’aléatoire hérité des sondages en face à face ou par téléphone tout en utilisant des contraintes de quotas, donc une démarche qui au demeurant aurait dû avoir raison de l’opposition entre aléatoire et quotas. Cependant il devenait de plus en plus difficile de procéder par ces modes traditionnels en raison de l’effondrement des taux de participation ou d’acceptation. C’est pourquoi se sont développés les access panels de première génération alimentés par le vivier des personnes déjà interrogées par téléphone ou en face à face et par l’achat d’adresses Internet de sources diverses. Ces panels faisaient l’objet d’un suivi et d’une gestion stricts. Avec le développement des équipements numériques et l’accroissement de la concurrence, due à l’émergence de nouveaux prestataires opérant à bas coûts et dans de brefs délais grâce au mode Internet, on a fait fi de l’effort d’aléatoire et du suivi individuel des panélistes, tirant ainsi vers le bas la qualité des échantillons.

Les access panels d’aujourd’hui sont constitués par autorecrutement de personnes qui s’inscrivent via des sites Internet promettant rémunération, ce qui constitue déjà un premier biais de sélection. Pour chaque sondage, des questionnaires sont envoyés à un lot de panélistes en fonction des quotas socio-économiques usuels ; répond alors qui veut, ce qui ne facilite pas la réalisation des quotas. Ce mode de double auto-sélection des répondants, à la fois en amont – devenir membre du panel – et en aval – répondre à l’enquête -, est évidemment un déni des principes fondamentaux de l’échantillonnage. Luc Bronner, grand reporter au Monde, s’est mis dans la peau d’un panéliste sur différentes plateformes et a démontré dans un dossier de quatre pages[iii] tous les travers de ces access panels dont la gestion est quasiment inexistante. Ce processus de fonctionnement minimaliste a permis une prolifération exponentielle des sondages pré-électoraux[iv].

Les principaux biais des access panels

Les échantillons issus de ce type de panels recèlent des biais importants. Le plus évident d’entre eux tient au fait qu’il faut avoir un bon niveau de pratique familière d’Internet pour participer activement au panel. Sur la base de l’étude[v] parue dans INSEE Première en octobre 2019 qui prend en compte une hiérarchie de compétences on peut estimer, avec un coefficient approximatif de réactualisation, que sont exclus d’emblée de l’ordre de quarante pour cent de la population. De plus étant donné que sont retenus les plus rapides à répondre (moyennant un respect de quotas), que les délais de réponse sont courts (entre un et trois jours de façon générale), qu’il n’y a pas ou peu de relances, on peut estimer que les usagers très assidus d’Internet sont surreprésentés. Sur le plan politique, on a pu observer dans les sondages récents une présence plus importante de sympathisants du Rassemblement National (RN) qui peut s’expliquer, entre autres, par le fait que les plus gros utilisateurs d’Internet sont plus adeptes des réseaux sociaux et plus exposés aux thèses antisystème. Ainsi pour les neuf sondages pour lesquels on disposait des données brutes (non retraitées, voir plus bas) aux régionales 2021, on a observé une moyenne de 2 points au-dessus du score réel. Il faut ajouter également qu’un des avantages des modes auto-administrés, donc d’Internet, est la moindre hésitation à déclarer des opinions extrêmes. Ainsi l’inextricable phénomène de forte sous-estimation du FN qu’on a connu par le passé, responsable d’échecs comme celui, emblématique, du premier tour de la présidentielle de 2002, est en voie de disparition.

Dans un ouvrage récent[vi] je montre encore que les panélistes auto-sélectionnés ont un intérêt prononcé pour la politique, ce qui n’est pas surprenant car ils répondent préférablement aux enquêtes qui font partie de leurs centres d’intérêt ; en outre, certains gestionnaires de panels ne se cachent pas de filtrer ainsi les destinataires des questionnaires pour améliorer les taux et délais de retour. A l’inverse, ceux qui n’ont pas d’appétence politique ne choisiront pas les questionnaires des campagnes électorales, souvent lourds et impliquants. Ainsi, lorsque l’on interroge sur l’intention d’aller voter, on obtient des taux de réponses affirmatives de 90 à 95 % (voir par exemple le sondage IFOP du 8-02-2022[vii]). De ce fait, on ne peut espérer, par exemple, avoir une estimation pertinente de l’abstention à partir d’un access panel. En outre, le fait que les taux de non-réponse aux questions politiques est faible et que le pourcentage d’inscrits sur les listes électorales chez les panélistes est bien supérieur à la réalité, vient conforter encore l’idée d’un biais d’intérêt marqué pour la chose politique. En conclusion, on peut s’attendre à des écarts systématiques d’estimation qui seront difficiles à anticiper dans la mesure où chaque élection est une nouvelle redistribution des forces politiques.

La question des marges d’erreur

Dans le débat public il est beaucoup plus question des « marges d’erreur » – à vrai dire les intervalles de confiance – que des biais. La loi[viii] 2016-508 d’avril 2016 modifiant et complétant une première loi 77-808 datant de juillet 1977 stipule les informations qui doivent être publiées et communiquées à la Commission des Sondages (CdS) par une « notice » pour chaque sondage électoral, parmi lesquelles figurent les « marges d’erreur des résultats publiés ou diffusés, le cas échéant par référence à la méthode aléatoire ». Cette obligation, comme d’autres, est respectée dans la forme mais non dans l’esprit initial du législateur. En effet les sondeurs se contentent d’indiquer un tableau standard des marges d’erreur sans s’y référer contextuellement dans les tableaux de résultats. Pour encore illustrer la difficulté d’inscrire des obligations à caractère technique dans la loi, citons à l’article 1 le paragraphe relatif à la sélection de l’échantillon : « Les personnes interrogées sont choisies par l’organisme réalisant le sondage de manière à obtenir un échantillon représentatif de la population concernée ». Bien évidemment, avec la méthode des quotas, tous les échantillons, sans distinction, seront donc considérés représentatifs. Le positionnement de la marge d’erreur est équivoque dans la narration des sondeurs. D’une part avec le courant sociologique traditionnel, ils déclarent péremptoirement que « l’on admet généralement » que les marges d’erreur sont du même ordre dans la méthode des quotas et dans la méthode aléatoire, d’où la référence faite à celle-ci dans la loi de 2016 ; d’autre part, alors que pointe actuellement l’exigence d’une marge d’erreur sur tout résultat publié, les sondeurs peuvent aussi bien déclarer qu’avec les quotas on ne peut pas calculer de marge d’erreur.

En vérité on peut établir la variance de l’estimateur d’un pourcentage d’une modalité de réponse, dont dérive la marge d’erreur, en contexte aléatoire avec contraintes de quotas, comme l’a démontré Jean-Claude Deville[ix]. Pour le plan aléatoire simple en amont (soit à probabilités égales), elle correspond à la variance résiduelle d’un modèle d’analyse de variance additif visant à expliquer la réponse avec codage 1 pour oui et 0 pour non en fonction des critères de quotas. Donc, globalement, plus les critères de quotas sont prédictifs des choix de réponse, plus on va gagner en précision, ce qui est assez intuitif. En pratique, les gains de précision (écart-type) dus à l’utilisation des quotas socio-économiques usuels sont minimes, au grand maximum 10 %, car on est en présence de variables catégorielles, donc relativement pauvres en information par rapport à des variables quantitatives et, de plus, ces critères (classe d’âge, genre, catégorie socio-professionnelle, zone géographique de résidence) sont peu prédictifs des comportements électoraux au sens statistique.

Evidemment ces calculs ne s’appliquent pas aux access panels trop éloignés du cadre aléatoire. Cependant on peut imaginer qu’il reste une part d’aléa dans la sélection des personnes contactées au sein du panel, ne serait-ce par exemple qu’en partant d’un endroit au hasard dans la liste pour ne pas solliciter systématiquement les mêmes personnes. Toutefois on ne maitrise pas le collectif des répondants dont on peut penser qu’il contient selon les thématiques souvent les mêmes personnes. Cela signifierait une variabilité moindre par rapport au schéma aléatoire mais compensée par des écarts systématiques. On ne voit pas comment les échantillons réels pourraient faire mieux en termes de proximité avec les valeurs de la population qu’un échantillon aléatoire avec contraintes de quotas dépourvu de biais (ou presque). C’est pourquoi il me semble que la référence aux marges de l’aléatoire est utile, même si elle donne une vision optimiste de l’incertitude en ignorant les biais qui sont les principaux responsables des erreurs d’estimation.

Le retraitement des valeurs brutes

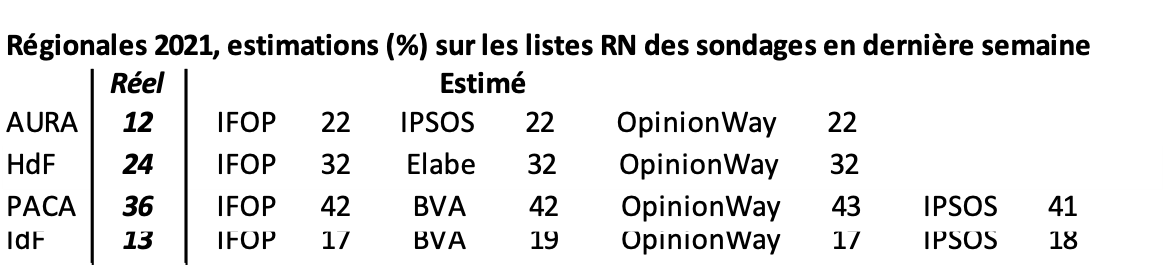

A ces incertitudes sur les résultats il faut ajouter le retraitement des valeurs brutes issues de la collecte d’une part par les redressements et d’autre part par des modifications manuelles. Les redressements sur les résultats d’élections antérieures posent divers problèmes[x] dont particulièrement le fait que les souvenirs des répondants sont étonnamment peu fiables, pour des raisons d’oubli ou d’erreur involontaire, et parfois même par dissimulation ; en outre, chaque contexte électoral est différent. On peut montrer que cela occasionne une instabilité des résultats et donc une incertitude accrue (voir op. cit., référence 6, chapitre 6). Par ailleurs des corrections manuelles jugées nécessaires par l’appréciation des prestataires ou par grégarisme sont pratiquées. En effet on constate systématiquement que plus on approche de la date de l’élection, plus les résultats des différents sondeurs convergent de façon totalement improbable pour des échantillons indépendants traités avec des choix de redressements différents. En fait aucun sondeur ne veut courir le risque de rester à l’écart du courant général. Ce phénomène de type « rapprochement vers la moyenne » contribue à une réduction de la variance mais n’offre pas de garantie d’amélioration en ce qui concerne les biais. Ces « corrections d’experts » sont tolérées par la CdS à condition qu’elles soient justifiées et exceptionnelles. Elles pourraient l’être aussi par les destinataires de l’enquête si elles étaient explicitées et non pas dissimulées dans un secret de fabrication. Le tableau suivant concernant les estimations du premier tour des élections régionales de 2021 sur la dernière semaine de campagne illustre le double phénomène de convergence et de dérapage avec des biais élevés.

En conclusion les sondages électoraux commerciaux s’écartent des principes de l’échantillonnage scientifique. Ils relèvent d’une démarche empirique qui génère des biais. Il n’empêche que celle-ci peut éventuellement parvenir près de la cible comme ce fut le cas au premier tour en 2017, sans doute grâce à une appréciation collective correcte par les sondeurs de l’état des choses vers la fin de la campagne et à une part de chance. Par contraste les résultats aux régionales 2021 ont été désastreux.

Mots-clés : sondages électoraux – élections – représentativité – biais – access panel – marges d’erreur

[i] Communication au Congrès de Berne de l’Institut International de Statistique, 1895

[ii] Neyman, J., On the two different aspects of the representative method : the method of stratified sampling and the method of purposive selection, Journal of the Royal Stat. Soc., 97, 558-625, 1934

[iii] Enquête sur la fabrique opaque des sondages, Le Monde du 5 novembre 2021

[iv] 10 leçons sur les sondages politiques, Alexandre Dézé, éditions DeBoeck supérieur, janvier 2022

[v] Une personne sur six n’utilise pas Internet, plus d’un usager sur trois manque de compétences numériques de base, Stéphane Legleye, Annaïck Rolland, INSEE première, N°1780, 30/10/2019

[vi] La singulière fabrique des sondages d’opinion, Michel Lejeune, éditions L’Harmattan, juin 2021

[vii] Consulter ce sondage sur : http://www.commission-des-sondages.fr/notices/files/notices/2022/fevrier/9344-rdp-ifop-pm-8-fevrier-publi.pdf, page 6

[viii] Voir https://www.commission-des-sondages.fr/lois/lois.htm pour la partie de la loi relative à la publication et à la diffusion des sondages.

[ix] Jean-Claude Deville, Une théorie des enquêtes par quotas, Techniques d’enquête, Vol 17, 2, 1991, pages 177-195.

[x] Pour les aspects essentiels voir ma tribune sur lemonde.fr : https://www.lemonde.fr/idees/article/2021/12/14/il-faut-ramener-l-activite-sondagiere-dans-le-champ-scientifique_6106044_3232.html

Très bien tout ça mais les « instituts » de sondage sont experts en « redressement ». C’est là qu’est leur science.

S’il y a « redressement », il y a manipulation !