Si les ordinateurs quantiques voient le jour, ils promettent de casser nos clés de sécurité RSA utilisées dans nos échanges sur internet, d’optimiser des systèmes jusqu’alors hors d’atteinte, de trouver de nouveaux matériaux, pourquoi pas de mettre au point de nouvelles batteries et de nouvelles molécules pour la santé, le tout de manière bien plus sobre que ce que l’on fait actuellement sur nos supercalculateurs.

Dans l’imaginaire la réalisation concrète est encore trop lointaine. Pour certains même, l’ordinateur quantique utile serait un objet de science-fiction équivalent à demander au chat de Schrödinger de nous faire des calculs.

L’actualité, certes bruitée par des investissements importants, montre pourtant qu’il se passe quelque chose et que dans trois à sept ans on aura vraisemblablement des machines utiles. Trois à sept ans, ce n’est pas beaucoup plus que ce qu’il faut pour migrer une base de données dans l’industrie. Alors pour des Etats ou pour les entreprises, l’informatique quantique est peut-être en train de devenir un sujet de court terme.

Une brève introduction

On connaît l’histoire de ce savant chinois qui en salaire du service rendu à son empereur demanda deux grains de riz sur la première case, quatre sur la deuxième, pour arriver à 2^64 sur la dernière case de l’échiquier ; salaire d’apparence bien modeste pour le riche souverain, mais qui finit par l’inquiéter car dépassant de loin la production mondiale annuelle (actuelle) de riz.

Une paire d’électrons à deux états quantiques possède quatre états de base. Si nous ajoutons un autre électron à deux états à ce système, nous obtenons un système non pas à six mais à 2 × 4 = 8 états de base. Un système composé de 64 atomes à deux états, aura 2^64 ∼ 10^19 états de base.

Un système à 64 atomes ce n’est pas grand-chose mais pour calculer la dynamique de ce système minuscule, il faudrait intégrer les équations de mouvement de 10^19 amplitudes. C’est une très mauvaise nouvelle pour la physique. Mais une bonne nouvelle peut-être pour les mathématiques et un défi magnifique.

Si l’on vous demande de prévoir l’écoulement d’un fluide dans un tuyau alambiqué, les plus courageux s’arracheront les cheveux sur les équations de Navier-Stokes. Les plus pragmatiques, s’ils disposent du tuyau, y verseront de l’eau.

C’est peu ou prou ce qu’a proposé Richard Feynman dont on peut mesurer l’influence en imaginant qu’une petite phrase[1] prononcée en conclusion d’une présentation en 1982 a suffi à lancer l’informatique quantique. Il propose ainsi de ne plus s’appuyer sur autre chose que la nature quantique pour simuler la nature quantique. Simuler numériquement une particule est infiniment complexe mais si on dispose de particules sur lesquelles on peut opérer des opérations et des mesures on pourrait peut-être éviter ces calculs numériques aujourd’hui hors de portée.

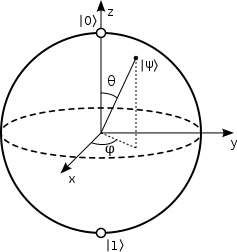

En informatique dite classique, on code l’information sur des bits qui peuvent prendre la valeur 0 ou 1. L’équivalent quantique des bits, les qubits, peuvent prendre les valeurs sur la surface de la sphère de Bloch illustrée en figure 1 et définies par les vecteurs |0⟩ = (1,0) et |1⟩ = (0,1). On parle de superposition d’états car les points de la sphère peuvent être α|0⟩ + β|1⟩ (|α|2 + |β|2=1). S’ajoutent à cela des phénomènes comme l’intrication quantique qui permet de lier des qubits, l’évolution adiabatique qui permet d’obtenir des minima non pas algorithmiquement mais physiquement et les interférences pour obtenir une machine aux caractéristiques bien désirables.

Un calculateur quantique à N qubits parvient à effectuer des traitements sur un espace de dimension 2N, exponentiellement plus que N bits classiques. Au-delà d’une cinquantaine de qubits on ne dispose pas de la capacité de calcul nécessaire à émuler en toute généralité le comportement d’une machine quantique.

Figure 1. Sphère de Bloch

Où en sont les machines ?

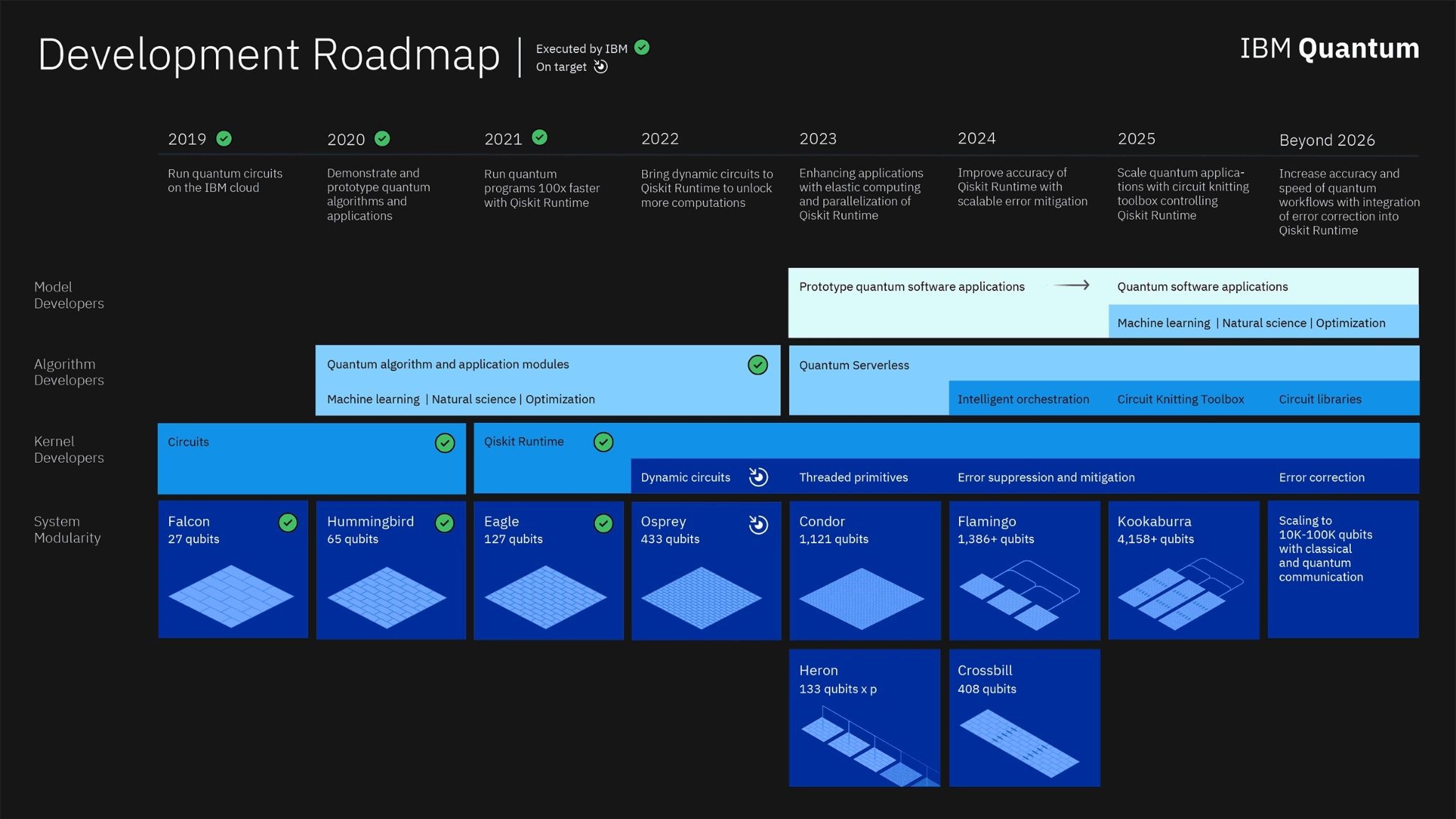

En 2017, on avait sous la main des machines de 2 à 5 qubits ; en 2020, 20 qubits ; en 2022, 127 qubits. La feuille de route d’IBM qui a le mérite d’être publiée vise plus de 4000 en 2025.

Le seul nombre de qubits ne fait pas tout car l’enjeu est de parvenir à augmenter le nombre de qubits tout en assurant un temps de décohérence (c’est-à-dire un temps pendant lequel on arrive à stabiliser un circuit quantique) suffisamment long. La fiabilité et la précision des portes sont aussi un enjeu. Les codes correcteurs d’erreurs sont ainsi un domaine de recherche fécond et sont dans certains cas eux-mêmes consommateurs de qubits.

Malgré ces écueils, bien réels, on a des raisons d’y croire et l’une des raisons d’être optimiste est qu’on a une grande diversité de technologies.

On peut par exemple coder l’information sur des photons (composants de la lumière) comme le font, via une technologie unique, les Saclaysiens de Quandela, émanation du C2N (CNRS) ou encore comme l’américain PsiQuantum et le canadien Xanadu.

On peut aussi refroidir et isoler les atomes par laser comme le fait le toujours Saclaysien Pasqal, émanation cette fois de l’institut d’optique (Alain Aspect, Philippe Grangier).

Les supraconducteurs sont largement à l’étude par Ies américains de chez IBM, Rigetti et Google mais aussi par le parisien Alice&Bob et ses qubits chats, dont les fondateurs, ex ENS ont vu leur technologie reprise par le petit poucet Amazon.

C12, ex ENS promeuvent les nanotubes de carbone quand le LETI du CEA investit les très mûrs semi-conducteurs. Autour de ces fabricants gravitent des fournisseurs de technologies habilitantes type cryostat et autres connecteurs.

Figure 2 : feuille de route d’IBM ([8])

Un développeur ne code pas de la même manière sur une architecture x86, ARM ou un GPU. On ne code pas non plus de la même manière une machine basée sur les supraconducteurs et une machine basée sur les atomes neutres. Ce n’est pas le moment de parier sur le ou les vainqueurs mais il n’y aura surement pas que des perdants.

On peut expliquer la présence remarquable d’un certain nombre de startups françaises dans la liste ci-dessus par le plan quantique national, les plans européens, le tissu du plateau de Saclay et l’arrivée de fonds parmi lesquels on ne peut que citer Quantonation, porté notamment par un ancien thésard d’Alain Aspect revenu des Etats-Unis avec le sentiment que quelque chose était possible.

De même qu’on n’a pas attendu les GPU pour développer les réseaux de neurones, les mathématiciens n’attendent pas les machines pour développer les algorithmes et depuis l’idée lancée par Feynman, et après une phase d’axiomatisation menée notamment par David Deutsch, un certain nombre de levées de verrous reléguant nos architectures informatiques actuelles à la préhistoire ont été démontrées :

1994 : S’appuyant sur un papier passé inaperçu de Daniel Simon, Peter Shor lance la première bombe quantique : un algorithme de factorisation d’entiers sur le papier exponentiellement plus rapide que le meilleur algorithme classique connu[2]. La difficulté à factoriser les nombres est à la base de nos cryptographies actuelles. La communauté cryptographique s’est depuis affairée à la cryptographie dite post-quantique.

1996 : Grover lance une deuxième bombe quantique. La recherche dans un dictionnaire est bien plus rapide quantiquement que classiquement.

2008 : L’algorithme Harrow-Hassidim-Lloyd (HHL) résout un système AX = B exponentiellement plus rapidement. La résolution de ces systèmes linéaires pour A grand est à la base d’un certain nombres d’algorithmes de l’industrie, d’une part car largement utilisée pour résoudre des équations aux dérivées partielles et d’autre part car la routine est au cœur de plusieurs algorithmes statistiques.

Et après ? A-t-on réussi à faire tomber les problèmes que l’algorithmique actuelle ne parvient pas à traiter (par exemple cette classe de problèmes dits NP-complets)? Eh bien non, il a fallu revenir sur terre. Contrairement à ce que la série de bombes quantiques a pu laisser espérer, il est peu probable que l’on parvienne à traiter quantiquement des problèmes arbitrairement difficiles. Le terme suprématie quantique lancé par Preskill et devant intervenir à ce moment précis où on arriverait à faire un calcul en quelques secondes sur une machine quantique contre des milliers d’années sur un supercalculateur classique est petit à petit abandonné d’une part car assez malheureux politiquement quand on est Américain et d’autre part grâce à un retour à la modestie scientifique (cf. débat IBM / Google [1]).

Ce que recherche la communauté et ce qui ferait du bien à ses finances c’est un avantage. Pour l’instant, les avantages quantiques obtenus sont de deux sortes : il y a les théoriques mentionnés ci-dessus. Ce sont les algorithmes obtenant des avantages en temps de calcul et démontrés mathématiquement. L’avantage est obtenu sur des machines dotées de millions de qubits et sans bruits. Ils s’appuient pour la plupart sur l’estimation efficace de la période d’une fonction périodique (HHL, Shor).

La seconde sorte d’avantage, tout aussi calculatoire, est démontrée empiriquement sur de vraies machines et s’applique à échantillonner des variables aléatoires aux lois compliquées (cf. [2]).

Un troisième type d’avantage est l’avantage écologique : en quantique on ne perd pas d’information et de fait, on ne dissipe pas autant de chaleur. On espère que ces machines seront donc bien moins énergivores. C’est le sens du manifeste soutenu par Alexia Auffèves et Olivier Ezratty (cf Quantum Manifesto [4])

Pour rechercher un avantage à court terme, on se contente aujourd’hui de machines relativement petites et bruitées. Pour les exploiter, on essaye l’hybridation classique quantique. Cette méthode permet en outre de ne pas passer trop de temps dans les circuits quantiques pour éviter de trop souffrir du bruit. QAOA, un algorithme d’optimisation combinatoire est l’un des porte-étendards de cette catégorie et sur certaines instances réduites parvient à égaler le meilleur algorithme classique connu. Un domaine comme celui de la recherche opérationnelle est fort de 60 années d’expertise et il est donc tout à fait remarquable qu’en si peu de temps l’algorithmique quantique soit à la frontière de ce que l’on sait faire classiquement.

Toujours via l’hybridation, on parvient à simuler des matériaux, certes sur de petites instances mais encore une fois aussi efficacement que l’état de l’art classique. Disposer de machines plus puissantes permettrait par exemple de simuler le vieillissement, encore mal compris de certains composants des batteries. Hybridation toujours quand il s’agit de simuler des barrages et des déformations de manière raisonnable en résolvant des équations aux dérivées partielles.

Quand aura-t-on l’avantage via ces algorithmes hybrides ? C’est dur à dire car les preuves qui feront foi seront empiriques. Nous sommes donc dans l’attente. Les plus optimistes espèrent qu’on aura l’avantage à partir de quelques centaines de qubits (2023 d’après la figure 2), les plus raisonnables attendent les quelques milliers (2025 toujours d’après la figure 2), les autres attendent le million corrigé. De manière raisonnable donc, il s’agit d’un sujet de court terme.

Notons que David Deutsch (Oxford), Peter Shor (MIT) mentionnés ci-dessus ainsi que Charles H Bennet (IBM) et son co-auteur Gilles Brassard (Montréal) (cryptographie post quantique) ont remporté en 2022 le très doté Breakthrough Prize en physique fondamentale. Ce prix reconnait ainsi un secteur qui est en train de changer le monde.

Quantique, un sujet de court terme

La cyberattaque (qui est l’une des seules que les non-initiés comprennent) qui s’appelle “Store now decrypt later” consiste :

- à stocker sur son PC des fichiers cryptés et sensibles, tels que plans d’armements ou données utilisateur ;

- attendre que les machines à 1 million de qubits arrivent

- décrypter les fichiers via l’algorithme de Shor

- faire payer une rançon.

On peut se rassurer en pensant que la machine quantique ne verra pas le jour. Si vous étiez Directeur des Systèmes d’Information, vous feriez ce pari contre les recommandations de l’ANSSI ? Une autre raison pour ne rien faire est d’imaginer que les coûts d’accès à ces machines seront tellement élevés que les hackers ne pourront y avoir accès. Aujourd’hui l’heure de calcul quantique chez un fournisseur cloud est de quelques milliers d’euros. Un hacker n’aura, lui, pas besoin d’une heure de calcul.

La question est donc d’actualité. Aux Etats-Unis, depuis 2016, un concours de cryptographie post-quantique est organisé avec des éliminés tous les ans. En juillet, quatre algorithmes ont été retenus (avec un certain nombre de laboratoires français et toujours un laboratoire européen impliqué). Psychodrames cette année, un algorithme pressenti et un autre de la liste « secondaire » se sont vus piratés par des chercheurs armés de leurs ordinateurs portables. Le sujet n’est donc pas stabilisé et plutôt que de choisir un algorithme unique, on se prépare à être capables de changer d’algorithmes rapidement via la crypto agilité. C’est d’autant plus sain que chacun des algorithmes retenus par l’organisme américain du National Institute of Standards and Technologies (NIST) présente des caractéristiques différentes en termes de taille de clé et de performances.

En janvier la Maison-Blanche a donné six mois à ses agences fédérales pour qu’elles se mettent en ordre de bataille pour la cryptographie post-quantique. L’ANSSI et ses équivalents européens ont également publié des recommandations.

Malgré les applications prometteuses, la marche quantique est haute. Les compétences requises sont à l’intersection de spécialités pointues des mathématiques, de la physique et aussi d’informatique et même si l’on code une machine quantique en python, la routine CPUtoQuantum ne verra jamais le jour. L’informaticien quantique n’existe pas encore et un des algorithmes très spécifique doivent être mis en place en fonction des cas d’utilisations : la recherche est encore nécessaire.

Étant donné les applications importantes, la question à trancher pour un décideur ou une décideuse n’est pas celle de la faisabilité de la machine ; cette question se pose d’ailleurs de moins en moins. Si l’on veut rester dans la course technologique et si l’on veut garder une certaine souveraineté, on ne peut pas se permettre de prendre le train en marche, dût ce train ne pas desservir la destination attendue. Que ça réussisse ou pas n’est pas la question, la question est : étant donné la hauteur de la marche technique et les applications, peut-on se permettre de ne pas y être si ça marche?

La réponse apportée par l’UE et les Etats membres est à la hauteur de l’enjeu : l’UE finance à hauteur de plusieurs milliards d’euros les efforts quantiques. La France avec son plan à 1,8 Md€ crée un tissu de startups assez remarquable. L’Allemagne, déjà fortement impliquée, a récemment renchéri. IBM, Google, Amazon ont investi le domaine de manière massive. Les industriels comme Atos, Thales et EDF [5, 6, 7] en France investissent le domaine et dynamisent le tissu industriel et académique en mettant à disposition leurs cas d’application certes, mais surtout des experts scientifiques capables de comparer comme il se doit le meilleur du quantique au meilleur du classique.

Mots-clés : Ordinateur Quantique – algorithmes – cryptographie post-quantique – qubit

Cet article a été initialement publié le 3 novembre 2022.

Bibliographie

[1] Débat IBM/google https://www.engineering.com/story/quantum-supremacy-isnt-a-thing-the-case-of-google-vs-ibm

[2] Madsen, L.S., Laudenbach, F., Askarani, M.F. et al. Quantum computational advantage with a programmable photonic processor. Nature 606, 75–81 (2022).

[3] Binney, J. , Skinner, D. The Physics of Quantum Mechanics

[4] Quantum Manifesto https://quantum-energy-initiative.org/manifesto/

[5] Dalyac, C., Henriet, L., Jeandel, E., Lechner, W., Perdrix, S., Porcheron, M., & Veshchezerova, M. (2021). Qualifying quantum approaches for hard industrial optimization problems. A case study in the field of smart-charging of electric vehicles. EPJ Quantum Technology, 8(1), 12.

[6] ZAIOU, Ahmed, BENNANI, Younès, HIBTI, Mohamed, et al. Quantum Approach for Vertex Separator Problem in Directed Graphs. In : IFIP International Conference on Artificial Intelligence Applications and Innovations. Springer, Cham, 2022. p. 495-506.

[7] T. Pochart, P. Jacquot and J. Mikael, « On the challenges of using D-Wave computers to sample Boltzmann Random Variables, » 2022 IEEE 19th International Conference on Software Architecture Companion (ICSA-C), 2022, pp. 137-140, doi: 10.1109/ICSA-C54293.2022.00034.

[8] https://www.ibm.com/quantum/roadmap

[1] “Nature isn’t classical, dammit, and if you want to make a simulation of nature, you’d better make it quantum mechanical, and by golly it’s a wonderful problem, because it doesn’t look so easy”

[2] Comprendre qu’à partir d’une certaine taille, on ne sait pas faire aujourd’hui

Commentaires récents