L’évaluation du niveau des élèves en mathématiques est aujourd’hui un enjeu politique crucial à l’échelle nationale et internationale. En témoigne le fait que d’une part des enquêtes à la complexité statistique croissante ont été mises en place pour fournir estimations et comparaisons de ce niveau à différentes échelles, et que d’autre part les résultats de ces enquêtes sont abondamment repris dans le débat public, voire jouent régulièrement le rôle d’appui ou de justification à l’action publique en matière d’éducation.

Afin de dépasser le simple constat de la baisse du niveau ou de la hausse des inégalités qui accompagne le plus souvent, dans les médias, l’évocation de ces grandes enquêtes, nous allons nous intéresser aux évaluations des acquis et des performances en mathématiques selon différents angles développés dans trois articles publiés dans variances.eu, aujourd’hui et au cours des prochaines semaines.

Dans ce premier article, nous proposerons une synthèse des résultats des différentes enquêtes que nous avons pu recenser, avec l’ambition d’aider le lecteur ou la lectrice à prendre du recul sur les résultats et à se repérer dans le paysage complexe des différentes évaluations disponibles. Cette tentative de synthèse ne prétend pas à l’exhaustivité tant les dispositifs d’évaluation sont aujourd’hui nombreux et tant ils ont varié dans le temps : nous avons fait le choix d’évoquer les enquêtes les plus stables et les plus présentes dans le débat public relatif à l’enseignement des mathématiques.

Dans un second article, nous présenterons quelques conclusions de notre propre travail sur l’enquête TIMSS 2019 pour tâcher de qualifier le niveau des élèves français en mathématiques au-delà du constat d’une baisse absolue dans le temps et d’un retard relatif par rapport aux autres pays.

Enfin, nous proposerons dans un troisième article de faire un pas de côté et de nous interroger sur ces enquêtes elles-mêmes, en nous intéressant aux conséquences sur le débat public et sur la gouvernance de l’éducation, à l’échelle nationale et internationale, de la multiplication de ces dispositifs d’évaluation de la performance des élèves.

Le niveau d’acquis des élèves en mathématiques : quelles enquêtes disponibles et quelles spécificités ?

Plusieurs grandes distinctions permettent de classifier les différents dispositifs d’évaluation du niveau des élèves en mathématiques.

En premier lieu, un critère d’échelle peut être utilisé pour distinguer les évaluations nationales, – qui permettent d’évaluer un pays et éventuellement d’enregistrer des tendances temporelles -, des évaluations internationales – permettant la comparaison entre plusieurs pays (avec, souvent également, une dimension temporelle) -.

Par ailleurs, les évaluations sur échantillon se distinguent des évaluations généralisées ; les premières permettent d’inférer les performances de l’ensemble d’une population cible à partir de l’évaluation d’un nombre restreint d’individus (c’est le cas des enquêtes TIMSS et PISA à l’échelle internationale, ou de l’enquête CEDRE à l’échelle nationale[1]), tandis que les secondes interrogent l’ensemble de la population cible (c’est par exemple le cas des Évaluations Repères passées en CP, en CE1, en 6ème et en seconde).

Les dispositifs varient également en fonction du type de savoirs et de savoir-faire qu’ils cherchent à évaluer : des chercheurs norvégiens[2] ont ainsi montré que les items proposés dans TIMSS mettaient davantage en œuvre une connaissance curriculaire[3] et théorique des mathématiques que les items proposés dans PISA, lesquels visent plutôt à évaluer des compétences et, en particulier, la capacité à mobiliser les mathématiques pour résoudre des situations de la vie quotidienne. Ceci est d’ailleurs lié à la définition de la culture mathématique posée par l’OCDE : “La culture mathématique [qu’évalue PISA] est l’aptitude d’un individu à formuler, employer et interpréter les mathématiques dans différents contextes. Elle inclut la faculté de raisonnement mathématique et la capacité d’utiliser des concepts, des procédures, des faits et des outils mathématiques pour décrire, expliquer et prévoir les phénomènes.”[4] Un rapport de l’IGEN datant de 2012[5] fait quant à lui remarquer que les données fournies par l’enquête CEDRE sont plus complètes et plus “en phase avec les pratiques de classes en France”.

Un autre point qui permet de différencier les enquêtes du point de vue de leur finalité (et qui influe sur la méthodologie ainsi que sur les compétences évaluées) est la distinction entre des évaluations bilans et des évaluations diagnostiques. Les premières visent à fournir une représentation du niveau atteint par les élèves à un moment donné de la scolarité, le plus souvent en fin de cycle. Elles sont la plupart du temps pensées à de plus grandes échelles, et visent à fournir des indicateurs sur le fonctionnement des systèmes éducatifs afin de permettre leur pilotage. Les secondes sont davantage conçues comme des outils pédagogiques permettant aux acteurs et actrices du monde éducatif de situer le niveau de leurs élèves sur une échelle nationale et de réagir de manière adaptée. Elles sont donc conduites le plus souvent en début ou en cours de cycle et/ou d’année scolaire et sont davantage pensées à l’échelle de l’élève ou éventuellement de la classe. Néanmoins, la distinction entre ces deux types d’enquêtes a parfois été brouillée, notamment quand des enquêtes conçues comme des évaluations diagnostiques ont en fait été utilisées pour évaluer des entités plus larges, comme l’établissement ou même le système éducatif dans son ensemble. Nous reviendrons sur ce point dans un article ultérieur.

Enfin, les enquêtes peuvent être distinguées du point de vue des données de contexte recueillies pour faire sens des performances observées. Si ces différences semblent s’être résorbées, on pouvait observer par exemple que l’enquête PISA accordait auparavant beaucoup plus d’importance au contexte scolaire en tant que tel que ce n’était le cas dans l’enquête TIMSS. En effet, le dispositif PISA prévoyait de faire passer un questionnaire au chef d’établissement, alors que TIMSS prévoyait à l’époque de n’interroger directement que les professeurs des disciplines concernées (ce n’est plus le cas aujourd’hui).

Ces éléments distinctifs sont importants pour contextualiser et interpréter les résultats issus des données disponibles sur l’évolution du niveau en mathématiques dans un pays donné. Au-delà des précautions méthodologiques qui sont toujours de rigueur, il convient d’essayer de comprendre pour chaque enquête à quelles fins explicites et implicites les données ont été produites. Plus généralement, il importe de replacer les choix méthodologiques effectués par les différentes institutions productrices de ces données dans des contextes politiques nationaux et internationaux précis. Nous donnerons dans notre troisième article des exemples de la façon dont cela peut être fait.

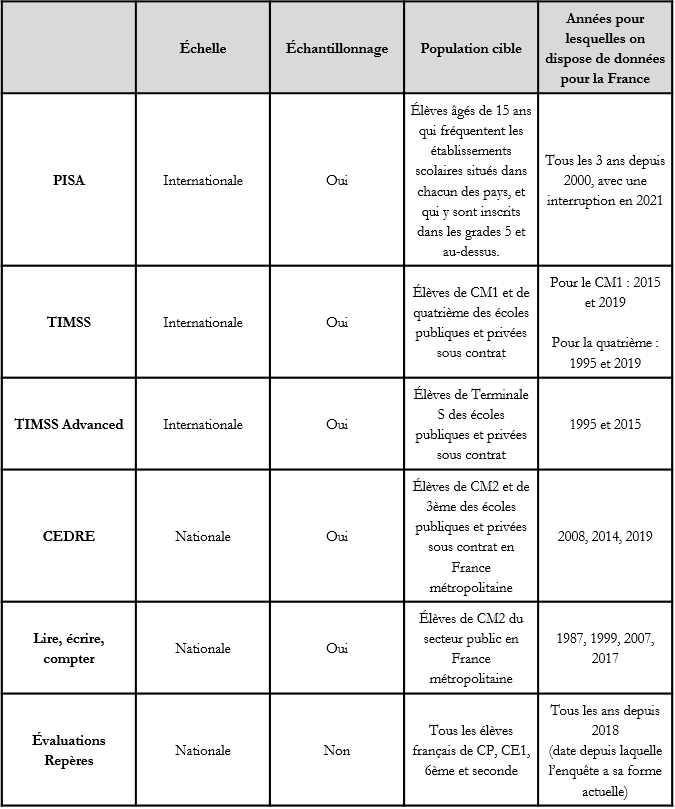

Le tableau suivant permet de récapituler et de situer les différentes enquêtes desquelles nous avons tiré nos réflexions pour ce premier travail :

Que nous permettent de conclure ces enquêtes sur l’évaluation du niveau des élèves français en mathématiques ?

L’observation des scores moyens obtenus par la France à ces différents dispositifs d’évaluation du niveau de performance des élèves en mathématiques laisse à penser qu’il y a effectivement une baisse significative du niveau des élèves français en mathématiques à des moments divers de leur scolarité. S’il est difficile de comparer des enquêtes qui, nous l’avons vu, mesurent des savoirs et des savoir-faire variés à des niveaux scolaires différents et couvrent des temporalités distinctes, force est de constater qu’en dehors des évaluations Repères qui traduisent une légère hausse du niveau des élèves sur certaines tâches depuis 2018[6], toutes les enquêtes que nous avons citées produisent des résultats allant dans le sens d’une dégradation sensible du niveau des élèves français en mathématiques.

Deux enquêtes nous semblent particulièrement éloquentes pour appréhender cette tendance sur le long terme :

- l’enquête “Lire, Écrire, Compter”, qui évalue de façon irrégulière depuis 1987 les compétences en calcul des élèves en fin de CM2,

- l’enquête PISA qui évalue tous les 3 ans depuis 2000 la capacité des élèves de 15 ans à mobiliser des savoirs mathématiques pour résoudre des situations de la vie quotidienne.

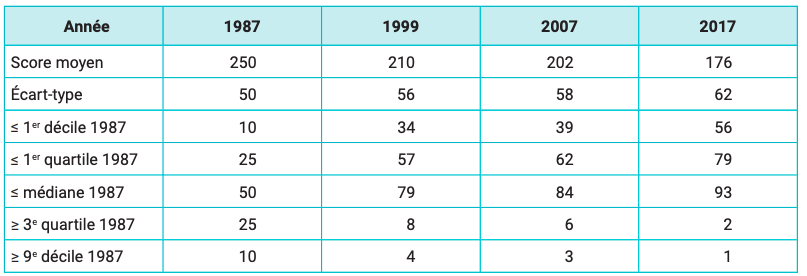

a. Les résultats de l’enquête “Lire, Écrire, Compter” sont résumés dans une Note d’Information produite par la DEPP[7] en 2019 (NI 19.08[8]). Nous en reproduisons ci-dessous un tableau qui permet de constater que la dégradation du niveau des élèves dans une compétence mathématique de base en fin de primaire est une tendance continue et de long terme. On observe néanmoins une baisse des performances légèrement moins marquée entre 1999 et 2007[9].

Si l’on s’intéresse à un socle de compétences plus large et à des échelles de temps plus fines, comme c’est le cas dans l’enquête CEDRE, on peut encore affiner et nuancer ce constat : les résultats de l’enquête suggèrent en effet qu’il n’y aurait pas eu de baisse significative du niveau moyen des élèves de fin de primaire en mathématiques entre 2008 et 2014, mais qu’en revanche une baisse serait survenue entre 2014 et 2018 (NI 20.33[10]).

Distributions et scores mesurés lors des quatre vagues de l’enquête “Lire, écrire, compter”

Source : MENJ-DEPP, enquête “Lire, écrire, compter” / Référence : Note d’Information, n°19.08, DEPP

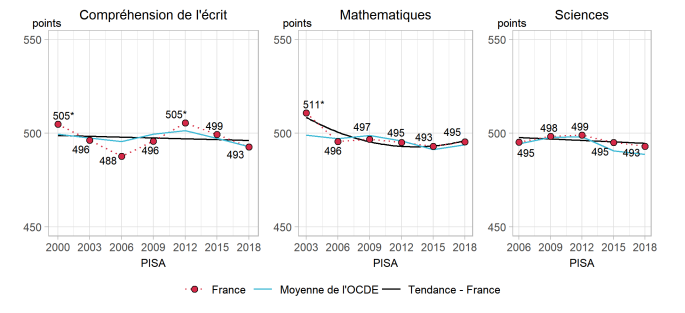

b. En ce qui concerne la fin du collège, les résultats de l’enquête PISA indiquent une baisse du niveau moyen des élèves entre 2000 et 2006, et une relative stagnation depuis (cf le graphique ci-après). Cette baisse est liée à une augmentation sensible de la part d’élèves en difficulté. On constate également que l’enquête PISA place régulièrement la France proche de la moyenne des pays de l’OCDE. On pourrait en conclure que la capacité à mobiliser des outils mathématiques dans la vie quotidienne ne soit pas la compétence qui se soit le plus dégradée en France dans la dernière décennie, ni celle qui place les élèves français dans la plus mauvaise place par rapport à leurs homologues internationaux.

Ainsi, l’enquête CEDRE en fin de collège et l’enquête TIMSS en quatrième, qui portent toutes deux sur des connaissances plus curriculaires, suggèrent pour la première une dégradation significative du niveau entre 2008 et 2014 puis entre 2014 et 2018, et pour la seconde un classement bien moins avantageux pour la France parmi les pays de l’OCDE que ne le fait PISA. En effet, parmi les pays de l’OCDE, seuls la Nouvelle-Zélande et le Chili se classent derrière la France en 2019 du point de vue du score en mathématiques obtenu en moyenne par les élèves de quatrième à l’évaluation TIMSS.

L’argument selon lequel les enquêtes internationales comme PISA ne permettraient pas d’évaluer pertinemment le niveau des élèves français en mathématiques parce que les compétences qu’elles évaluent sont trop éloignées du curriculum français, et notamment d’une certaine propension de l’enseignement mathématique français à valoriser davantage les savoirs abstraits au détriment de leur mise en œuvre concrète, semble donc être loin de décrire la réalité. On observe au contraire que les performances se dégradent davantage dans le temps et relativement aux autres pays lorsque l’on évalue les élèves français sur des items qui requièrent une connaissance abstraite des contenus mathématiques qui leur sont enseignés, ce qui confirme les résultats des chercheurs norvégiens que nous citions plus haut[11].

Tendances des performances moyennes des élèves français dans les trois domaines évalués par PISA : compréhension de l’écrit, mathématiques et sciences

Source : OECD, PISA 2018 Database, Tables I. B1.10, B1.11 et B1.12 / Référence : Notes par pays, Résultats du PISA 2018, OCDE

c. Les résultats de l’enquête TIMSS Advanced, à laquelle la France a participé en 1995 et en 2015, sont également préoccupants puisqu’ils interrogent la capacité de notre système scolaire non plus à fournir des compétences de base à l’ensemble des élèves, mais à sélectionner, orienter et former des élèves spécialisés en mathématiques, qui puissent rivaliser avec leurs homologues des autres pays. Si, en 1995, la France s’était classée première du groupe de pays participants[12] en obtenant le score de 557 à un test plus avancé en mathématiques concernant seulement les classes de Terminale S, elle se place 20 ans plus tard au milieu du groupe des pays participants (5ème sur 9 pays, notamment derrière la Russie et les Etats-Unis) avec un score de 463.

En conclusion, la synthèse des résultats obtenus par les élèves français aux principales enquêtes évaluatives du niveau en mathématiques nous permet de tirer les enseignements suivants :

- Il y a de fait une tendance de long terme qui indique une baisse du niveau moyen des élèves à différents stades de la scolarité, à la fois dans le temps et relativement aux autres pays,

- Cette baisse semble surtout concerner l’acquisition des savoirs du curriculum et moins la mise en œuvre d’outils mathématiques dans des situations concrètes, au moins depuis une dizaine d’années,

- On constate également une difficulté croissante du système scolaire français à sélectionner et former un groupe d’élèves spécialisés en mathématiques à la fin de l’enseignement secondaire.

Une autre remarque faite par plusieurs observateurs permet de mettre en perspective ces résultats : on observe que les élèves français ont une forte propension, dans ces enquêtes, à la non-réponse (laquelle est la plupart du temps comptabilisée comme une erreur) et ce notamment lorsque la question nécessite l’élaboration d’une chaîne complexe de raisonnements et non seulement la mobilisation immédiate d’un savoir explicitement désigné. Ceci doit nous inciter à prêter une attention particulière au rapport des jeunes français à l’erreur en mathématiques et à leur capacité à oser s’engager dans des raisonnements mathématiques plus ambitieux dans le contexte scolaire[13].

Mots-clefs : PISA – TIMSS – CEDRE – mathématiques – enseignement

[1] La méthodologie de cette enquête s’inspire d’ailleurs beaucoup de celle des évaluations internationales avec notamment un recours à la psychométrie et à la “Théorie de Réponse à l’Item”.

[2] Hole, Grønmo, et Onstad, « The dependence on mathematical theory in TIMSS, PISA and TIMSS Advanced test items and its relation to student achievement ».

[3] C’est-à-dire liée au programme, et plus largement aux contenus de l’enseignement.

[5] Inspection générale de l’éducation nationale, « Les évaluations nationales et internationales sur les acquis des élèves et sur d’autres dimensions des systèmes éducatifs ». Rapport n°2012-056

[6] Ces enquêtes, qui ont été abondamment reprises par le ministère de l’Education Nationale, notamment pour justifier l’idée d’un rattrapage du niveau scolaire après la pandémie, permettent uniquement la comparaison de deux années successives, et sont d’ailleurs conçues initialement davantage comme un outil pédagogique à l’usage des professeur.e.s (évaluations diagnostiques) que comme un moyen d’évaluer le niveau national.

[7] La DEPP (Direction de l’Evaluation de la Performance et de la Prospective) est le service statistique du Ministère de l’Education Nationale.

[8] DEPP, « L’évolution des performances en calcul des élèves de CM2 à trente ans d’intervalle (1987-2017) », NI 19.08.

[9] Nous précisons que la méthodologie de l’enquête garantit la comparabilité des résultats dans le temps en dépit de la modification des programmes scolaires.

[10] DEPP, « Cedre 2008-2014-2019 Mathématiques en fin d’école : des résultats en baisse », NI 20.33..

[11] Hole, Grønmo, et Onstad, « The dependence on mathematical theory in TIMSS, PISA and TIMSS Advanced test items and its relation to student achievement ».

[12] Qui étaient au nombre de 16 et parmi lesquels figurait la Russie et les Etats-Unis, mais ne figurait aucun pays asiatique.

[13] Cette remarque a d’ailleurs été portée à l’attention de la puissance publique, puisqu’elle figure dans le rapport Villani-Torossian.

- Accroissement des disparités genrées de performance en mathématiques en CM1 : une évolution aux conséquences graves - 16 décembre 2024

- Que nous apprend la publication de l’Indice de Position sociale (IPS) des collèges français sur la concentration des élèves d’origine favorisée dans le secteur privé ? - 9 février 2023

- Les Français et les mathématiques : ce que nous apprend l’enquête TIMSS 2019, au-delà des moyennes et des classements - 29 août 2022

Commentaires récents