L’utilisation de modèles d’analyse prédictive, ou predictive analytics (PA), est en pleine progression. Elle est destinée à favoriser l’augmentation des ventes et à fournir des données pour affiner les stratégies marketing. Le recours à ces modèles devient ainsi une pratique courante pour mesurer par exemple le désir ou la capacité d’achat des consommateurs, et ainsi pour calibrer les campagnes de vente et de communication.

L’organisation de la fonction PA

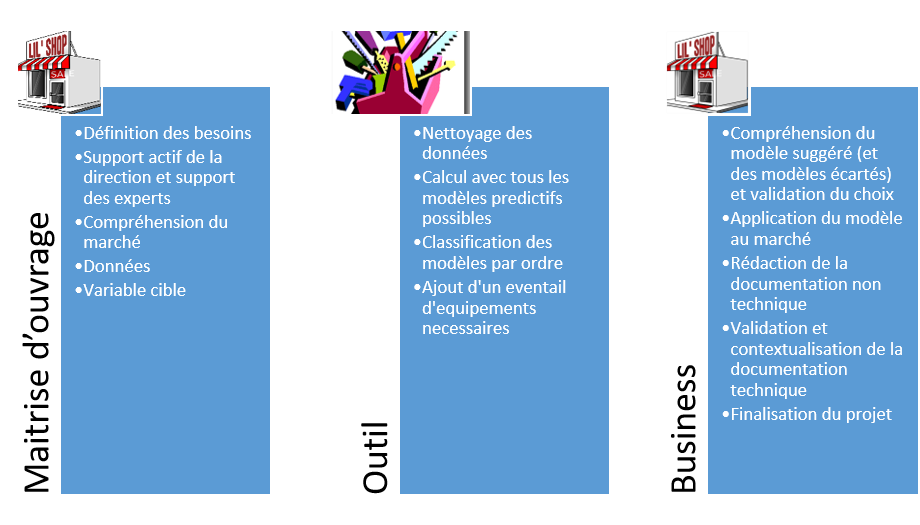

Le modèle organisationnel de la fonction PA consiste à construire une équipe PA complète. Une alternative à ce modèle est d’utiliser des outils permettant d’automatiser certaines tâches chronophages. Quelques exemples de ce type de plateforme incluent DataRobot, Alteryx, RapidMIner et WTW Emblem pour la tarification non-vie dans le domaine de l’assurance. Le but de ce type d’outil est d’alléger le besoin de ressources pointues en PA en facilitant la construction des modèles.

En ce qui concerne le développement d’un modèle prédictif, le point de départ consiste à clairement identifier les besoins du business, portés par la maitrise d’ouvrage. Cela va influencer le choix du modèle utilisé, toutes choses égales par ailleurs.

Ci-dessous une liste des étapes habituelles à suivre pour toute tâche de PA :

- Intégrer l’initiative PA dans un contexte business[1]

- Définir les besoins en données

- Nettoyer les données

- Choisir un modèle et le développer à partir des données disponibles

- Tester le modèle

- Le lancer

Les modèles de PA : quelle utilité ?

Ce type d’outil ne va pas aider à résoudre les problèmes du business[2], ou à trouver des données. Il ne va pas non plus remplacer la connaissance du terrain, le besoin d’un dictionnaire des données, ni régler le problème « à données inexactes, résultats erronés ». Sur tous ces points, c’est bien à l’utilisateur de faire son travail.

Processus de PA : Résumé des différentes étapes

Ce que fait l’outil, c’est :

- automatiser le premier nettoyage de données (valeurs manquantes, création de tranches d’âge ou autres, nuage de mots clés pour coder du texte en variable, détection des valeurs aberrantes, etc.),

- construire tous les modèles possibles et imaginables sur un échantillon de données (ACP, ARMA, modèle linéaire généralisé, forêt d’arbres décisionnelle, gradient boosted trees classifier with early stopping[3], etc ,

- tester et valider sur un second échantillon de données, et classer les modèles en fonction de leurs capacités de prédiction.

L’outil ajoute la panoplie appropriée de fonctionnalités supplémentaires : code visible, documentation technique sous MS Word, représentation graphique de la capacité prédictive de chaque variable sous chaque modèle (avec analyse de dépendance) et bien d’autres non-listés ici.

A partir de là, c’est au tour du business de reprendre la main. Le modèle doit en effet être compris pour être complètement assimilé. Par l’utilisation de la documentation générée, de scénarios individuels et autres graphiques, la face cachée doit être révélée. Ces étapes peuvent être réutilisées pour faire comprendre le modèle aux autres parties prenantes et obtenir leur consentement. Certains points doivent également être finalisés, tels que la réalisation de la documentation, avant le lancement effectif.

Quelques exemples

Prenons un exemple pour comprendre la première étape, qui relève du business.

Besoin de la Maitrise d’Ouvrage

Votre département PA est contacté par l’équipe de détection des fraudes qui explicite ses besoins :

« Nous devons isoler les transactions qui comportent un risque plus élevé de fraude significative que les autres, afin de rendre les interventions du département d’investigation plus effective ».

Support de la direction et des experts du marché

Vous devez discuter avec l’équipe de détection des fraudes et expliciter le périmètre d’étude, l’échéancier, le seuil de matérialité des résultats, l’accès à la connaissance du marché.

Connaissance Business

Vous devez comprendre le processus actuel d’identification de ces transactions, et pouvoir obtenir des retours sur des hypothèses de travail. C’est important afin d’éviter les “faux-positifs”, par exemple mettre en évidence une corrélation élevée entre le nombre annuel de décès par noyade suite à une chute dans une piscine et le nombre de films de Nicolas Cage sortis dans l’année…

Données

Vous disposez de fichiers de données en provenance de ce département, mais vous devrez peut-être disposer de davantage de données issues de sources internes ou externes (par exemple d’un courtier en données…). Assurez-vous de vous doter des compétences d’un.e juriste qui vérifiera la compatibilité, avec le règlement RGPD ou toute autre contrainte juridique, des transferts des données d’une entité juridique à une autre

Valeur cible

Ce que cela signifie est le besoin impératif de définir vos besoins. Mentionnons deux illustrations dans ce contexte :

- Dans la première, on remarque que l’on ne recherche pas à qualifier des transactions, mais des groupes de transactions qui rentreraient dans le champ d’une enquête unique.

- Dans la seconde, on construit un indicateur mettant en évidence les transactions couvertes par l’enquête, et le résultat de l’enquête (montant recouvré net du coût de l’enquête). Le fichier peut alors avoir un indicateur à trois positions : « Non-enquêté », « Recouvrement positif », « Recouvrement négatif ».

Calcul avec tous les modèles prédictifs possibles, classification des modèles, éléments complémentaires

Le travail de modélisation peut maintenant commencer.

Les données doivent être séparées en plusieurs sous-fichiers : un pour le calibrage, un pour le test, un pour comparer les modèles. En fait, comme une série de tests sont effectués, il faut appliquer une segmentation plus fine et vérifier que les données utilisées d’un côté ne le soient pas de l’autre.

Vient ensuite l’étape consistant à rechercher les variables corrélées, à faire une ACP et à tester des modèles linéaires, voire des modèles un peu complexes.

On doit ensuite choisir le modèle qui fonctionne le mieux, après avoir explicité les critères de classement.

Reste enfin à documenter le modèle choisi et écrire les équations qui sous-tendent la théorie sous-jacente à ce modèle.

Toutes ces étapes peuvent être effectuées par les plateformes de PA.

Retour vers le business

Mais le modèle doit être compris par la maitrise d’ouvrage. Il faut s’approprier ce que l’outil a proposé. A-t-il mis en évidence une corrélation à la Nicolas Cage? Ou bien est-ce une illustration de la parabole des aveugles et de l’éléphant (Anekantavada)[4], dans laquelle chacun devine le tout en touchant une partie (si l’on touche la jambe, l’éléphant ressemble à un arbre; si l’on touche l’oreille, l’éléphant ressemble à un éventail; si l’on touche la trompe, l’éléphant ressemble à un serpent…)?

Est-ce que le modèle sur-représente les aspects riches en données, mais oublie les aspects fondamentaux incorrectement couverts par le fichier? Est-ce que le phénomène est suffisamment stable pour que les résultats soient exploitables (par exemple, tous ceux qui achètent une veste jaune possèdent une voiture et sont averses au risque)?

L’équipe de détection des fraudes doit alors effectuer le lancement du modèle sur les données réelles. Est-ce que les données sont toujours disponibles? Le modèle ne sera-t-il jamais utilisé hors de son contexte? La documentation sera-t-elle mise à jour? Les parties prenantes comprennent-elles suffisamment le modèle pour continuer à l’utiliser? Ce travail substantiel est critique pour un bon déploiement de l‘outil.

Conclusion

Non, ce type de plateforme ne constitue pas la solution miracle à tous vos problèmes, mais il peut réduire vos coûts et atténuer les craintes que peut susciter la création d’une équipe de PA en termes de montant d’investissement à consentir.

Disclaimer

J’exerce la profession d’actuaire et travaille pour la Society of Actuaries. Je ne fais pas moi-même de PA. Mon objectif ici est simplement de présenter quelques idées basées sur les articles que j’ai lus et les présentations auxquelles j’ai assisté.

Mots clés : analyse prédictive, stratégie marketing, données, modèle de prévision, maîtrise d’ouvrage

[1] Le modèle PA est là pour répondre à une question du business (par exemple, optimisation de la sélection des prospects à démarcher, détection de fraude, minimisation du taux de départ des clients réguliers) dans un contexte business (allocation budgétaire au projet, échéancier…)

[2] https://scikit-learn.org/stable/auto_examples/ensemble/plot_gradient_boosting_early_stopping.html pour plus d’information

[3] J’ai suivi une présentation donnée par un vendeur de ce type de plateforme. L’exemple phare utilise dans la présentation en directe est la performance de prêts à la consommation. Le choix de la variable cible était un indicateur Oui/Non représentant le remboursement du prêt à échéance, et non une mesure de profitabilité. L’intervenant admis, après réflexion et hors micro, que cela n’inclut pas les prêts à taux hauts générant un profit malgré un non-remboursement en fin de contrat et inclus les prêts à taux faibles tarifes en dessous des frais fixes. Mais c’est plus facile à expliquer.

[4] https://fr.wikipedia.org/wiki/Anekantavada

- Les modèles d’analyse prédictive en plein essor - 18 mars 2019

Commentaires récents