Internet est semblable à l’univers en expansion : depuis son big bang, il y a environ soixante ans, au tournant des années 1960, il n’a cessé de s’étendre à grande vitesse, en changeant sans cesse de visage. Il est comme un « éther », un espace-temps, une matrice nourricière, siège de la transition numérique. Permanent tourbillon d’imprévisibilité, cette dernière est entraînée sans relâche par le moteur de l’incertitude créatrice ; et les surprises qu’elle nous réserve induisent une autre transition, parallèle, qui transforme la manière dont nous comprenons l’univers numérique, dont nous l’analysons en vue d’influer sur sa trajectoire.

Entre l’humain et la technologie se noue ainsi une étroite relation de réflexivité : nous forgeons des outils numériques qui, à leur tour, conditionnent la manière dont nous communiquons, dont nous vivons, la manière dont nous pensons et – « donc » cartésien –, celle dont, en définitive, nous sommes !

Contrairement à ceux issus des précédentes révolutions industrielles, les objets matériels ou immatériels peuplant l’univers numérique, parce qu’ils affectent nos fonctions cognitives, forment une totalité « ambiante ». Ils constituent un référentiel global au sens philosophique du terme, vis-à-vis duquel nous sommes à la fois en position d’extériorité et d’intériorité : d’extériorité, puisque ces instruments sont autant d’artefacts, conçus par nos intelligences afin d’augmenter nos facultés ; et d’intériorité, puisque le grand ensemble de tous ces artefacts, excédant largement la somme de ses parties, engendre la « noosphère » imaginée par Teilhard de Chardin[1], une sphère des esprits que nous habitons et dans laquelle nous nous mouvons.

À la façon d’une araignée, nous vivons au sein même de la toile que nous tissons. Et ce n’est certes pas fortuitement que nous désignons couramment cette toile par l’expression générique « Le numérique », où l’article défini ne figure pas ici pour invoquer quelque dieu païen, mais plutôt pour signifier un milieu, un écosystème en évolution, de la même façon dont nous parlons de « la terre », de « l’air » ou de « l’eau ».

1. L’expansion de l’univers numérique : du big bang aux galaxies GAFAM

L’expansion d’internet est proprement vertigineuse ! Né quant à moi une dizaine d’années avant le big bang, j’ai eu la chance de n’avoir manqué aucun épisode de la saga. Les plus jeunes, les digital natives, pourront, à la lecture de ces lignes, situer le moment de leur « naissance numérique », quelque part dans le déroulé d’une saisissante fresque chronologique où le fil du temps semble s’accélérer, tant la densité des évènements s’y accroît d’année en année. Attention, accrochez vos ceintures !

1958 : aux laboratoires Bell, est mis au point le premier modem permettant la transmission de données binaires.

1961 : l’informaticien américain Paul Baran invente la commutation de paquets de données, prérequis incontournable d’un réseau interconnectant des ordinateurs.

1971 : vingt-trois ordinateurs sont connectés au réseau Arpanet, l’ancêtre militaire de l’internet civil.

1973 : la Grande Bretagne et la Norvège rejoignent l’Arpanet, avec chacune… un seul et unique ordinateur !

1975 : Bill Gates crée Microsoft.

1976 : Steve Jobs crée Apple.

1983 : le protocole de transfert de données et d’adressage TCP/IP est adopté ; il fut inventé dix ans auparavant par Vincent Cerf… et par le français Louis Pouzin, tous deux futurs lauréats en 2013 de la première édition du prix Queen Elizabeth Prize for engineering, en compagnie de trois autres pionniers d’internet, Robert Kahn, Tim Berners-Lee et Marc Andreessen.

1985 : la première version de Microsoft Windows est lancée.

1989 : cent mille ordinateurs sont maintenant connectés à l’Arpanet, contre dix mille en 1987 et seulement mille en 1984.

1990 : l’Arpanet s’efface, marquant l’éclosion d’internet et du world wide web.

1992 : un million d’ordinateurs sont désormais connectés à internet ; la même année, Microsoft lance la suite logicielle Office.

1993 : on assiste aux débuts de la téléphonie mobile grand public en Europe, avec l’arrivée des appareils de la génération GSM.

1994 : Jeff Bezos crée Amazon ; le premier smartphone, l’IBM Simon, est commercialisé.

I995 : Pierre Omidyar crée eBay.

1996 : John Perry Barlow proclame à Davos sa retentissante déclaration d’indépendance du Cyber-espace, une utopie inspirée et libertaire, annonçant l’avènement d’un espace de libre expression intégrale, de communication sans contrainte ni contrôle politique[2].

1998 : le marché des télécommunications s’ouvre à la concurrence dans les États européens ; Larry Page et Sergey Brin créent Google… dans un garage de Menlo Park, selon la légende urbaine ; la même année, Apple dévoile l’iMac.

1999 : l’ADSL[3] démarre en France, permettant la transmission de données numériques sur la paire téléphonique en cuivre.

2000 : la bulle spéculative d’internet atteint son pic, bientôt suivi de son éclatement, après un quintuplement de l’indice NASDAQ des valeurs technologiques, de 1000 à 5000, au cours des cinq années précédentes.

2001 : Jimmy Wales et Larry Sanger créent Wikipedia.

2002 : le marché des smartphones prend son essor ; l’ADSL se généralise en France, grâce à l’ouverture de la boucle locale d’Orange aux opérateurs de réseaux concurrents.

2004 : Mark Zuckerberg crée Facebook ; les GAFAM, ces véritables galaxies de l’univers numérique, sont dès lors au complet !

2006 : Jack Dorsey et alii créent Twitter.

2008 : la fibre optique, déjà très présente dans le cœur des réseaux, fait sa première entrée chez les foyers français.

2010 : Instagram voit le jour ; il sera racheté par Facebook deux ans plus tard. 2012 : au premier trimestre, la fibre optique ne compte encore que 270 000 abonnés en France ; une « mission très haut débit », future agence du numérique, est mise en place et le plan « France très haut débit » prévoit de servir un débit supérieur à 30 Mbit/s sur l’ensemble du territoire national à l’horizon 2022.

2013 : la 4G, quatrième génération de téléphonie mobile, débute son déploiement ; le débit disponible en mobilité rattrape ainsi peu à peu celui délivré par les accès fixes via les box.

2014 : le milliard de sites web est dépassé ; leur nombre s’élève aujourd’hui à plus de quatre milliards.

2019 : la barre des six millions de foyers français raccordés à la fibre optique devrait être franchie ; les enchères pour les fréquences de la génération mobile 5G devraient être lancées.

2. D’utopies en dystopies, d’audace en précaution

De ce grand livre de la genèse d’internet, que ressort-il essentiellement ?

D’une part, après des débuts par trop enchanteurs, une pernicieuse illusion s’est dissipée : celle d’une économie virtuelle où la valeur se créerait d’un coup de baguette, à la seule promesse de gains annoncés, à la seule entrevue de plans d’affaires potentiels. Autrement dit, pas de magie, pas de hotte d’un chimérique père Noël numérique, pas de corne d’abondance de l’immatériel ! Voilà une première utopie à terre : le virtuel est bien réel !

D’autre part, deux modes de fonctionnement coexistent sur le web et souvent s’y affrontent : d’un côté une logique communautaire, telle qu’incarnée par le site Wikipedia ; de l’autre, une logique commerciale, telle qu’incarnée par l’entreprise Amazon. Cette dualité se retrouve notamment dans l’opposition entre le modèle du logiciel propriétaire, défendu par Bill Gates, et le modèle open source du logiciel libre, prôné par Richard Stallman, le fondateur en 1983 du projet GNU[4]. Avant que leurs voies ne se séparent, ils ont étudié ensemble sur les bancs de Harvard et du MIT, au milieu des années 70. Dans le domaine de la propriété intellectuelle, une opposition similaire différencie les licences protégées par le copyright des licences ouvertes selon le principe du copyleft.

Publié en 2007, l’ouvrage « Internet economics, Digital economics »[5] reflète assez fidèlement l’attention que portaient alors les chercheurs universitaires à chacun des deux grands registres, économique et collaboratif, des activités à l’œuvre sur internet. Au sommaire, figurent en effet des chapitres traitant aussi bien :

- de la « nouvelle » économie, des nouveaux modèles d’affaire, du e-commerce, de la banque et de la finance en ligne ;

- des biens informationnels, des communautés en ligne, du peer to peer, de la société de la connaissance, du logiciel libre, de la fracture numérique.

Aujourd’hui, soit une douzaine d’années plus tard, en dépit des multiples innovations survenues en matière de technologies et de services ou – plus exactement –, en raison même de ces innovations, l’engouement initial a fait place à un certain scepticisme, à la crainte de lendemains qui déchantent ou, tout du moins, désenchantent…

Plusieurs contributeurs importants d’internet, désignés comme les « repentis » de la Silicon Valley, tels Tim Berners-Lee ou Tristan Harris, lancent des alertes pour dénoncer les dérives et les méfaits issus de « l’économie de l’attention »[6] à l’ère du big data. Ils dénoncent notamment :

- des menaces pesant sur la vie privée et une insuffisante protection des données personnelles ;

- des impacts environnementaux négatifs, dus à la forte consommation énergétique des serveurs et des fermes de données, ainsi qu’à la pollution que pourraient engendrer les déchets de matériels non recyclés…

- des dépendances à la technologie, individuelles et collective, notamment l’addiction au smartphone, entraînant des troubles psychiques… pouvant aller de la simple « nomophobie »[7] jusqu’à la dépression ou au burn out;

- la puissance inquiétante des algorithmes de « captologie », qui visent à capter notre attention, à nous maintenir le plus longtemps possible en ligne afin de nous y pousser à consommer ;

- le règne de « l’Empire du faux », selon la percutante expression de Bruno Patino[8], autrement dit la dissémination des infox (fake news) et la prolifération des contenus de faible intérêt (garbage).

En bref, à en croire les « repentis », nous vivons dans une société numérique de « l’individualisme connecté », mue par la recherche de l’intérêt personnel et du profit, remplie de leurres et de chausse-trappes… alors que nous espérions, selon l’esprit insufflé par les pionniers d’internet, une société numérique de la « connexion solidaire », placée sous le signe du partage et du savoir universels !

Ces alarmes ont-elles valeur de fatalité ? De quoi l’avenir sera-t-il fait ? À défaut de pouvoir le prédire, car notre futur numérique dépendra en très grande partie de ce que nous-mêmes en ferons, nous en connaissons déjà les principaux déterminants :

- un accroissement soutenu de la prégnance ambiante des technologies numériques ;

- des algorithmes enrichis par les considérables progrès accomplis par l’intelligence artificielle en termes d’apprentissage (deep learning) ; des moteurs de recherche reposant sur la triple indexation de textes, d’images et de sons, de ce fait quasi-omnipotents et pouvant donc légitimement faire craindre un phénomène « d’observation » tentaculaire à la Big Brother, ;

- la généralisation de « l’internet des choses » avec, notamment, l’apparition puis la généralisation de puces communicantes intégrées aux objets familiers jusqu’aux plus intimes (comme les vêtements), de dispositifs électroniques de contrôle corporel et de surveillance médicale, de véhicules partiellement ou entièrement autonomes, de robots de compagnie doués de la parole, de la reconnaissance des émotions et d’une certaine capacité d’empathie, etc ;

- et, surtout, la convergence technologique et servicielle dite NBIC[9] qui, bien au-delà du simple internet des choses, donnera lieu à une étroite imbrication entre les mondes respectifs du vivant et de l’inanimé : d’ores et déjà, le séquençage de l’ADN est presque à la portée du grand public… demain, l’impression 3D de tissus vivants, voire d’organes complets, deviendra possible.

D’où de nouvelles utopies, telles que « l’homme réparable », l’allongement disruptif de la durée de vie, ou encore le clonage, soulevant d’épineuses questions revêtant une forte dimension éthique. Ces questions inédites donneront lieu à de nouvelles dérives et transgressions, comme le trans-humanisme ou l’eugénisme, faisant alors naître de nouvelles inquiétudes et remises en question, en particulier quant au statut juridique et à la responsabilité sociale des robots, au partage du travail entre humains et machines, etc. Il en résultera vraisemblablement une radicalisation des réactions de rejet social de la technologie, déjà aujourd’hui en germe, ainsi qu’un risque exacerbé d’éclatement géopolitique de la gouvernance d’internet.

Et ainsi de suite, par cycles successifs, de phases enthousiastes portées par des visions utopiques à la Dr Jekyll, en phases d’alerte et de scepticisme provoquées par la peur que le rose ne vire au noir, que Mr Hyde ne parvienne à faire advenir ce revers consubstantiel à toute utopie : la dystopie. Oscillante et ouverte à la fois, la transition numérique ne mène certes pas linéairement d’un point de départ A à un point d’arrivée B. La destination B est inconnue et aucune route AB n’est donc tracée par avance !

Pour choisir la destination B puis construire à rebours une route de B vers A, selon la précieuse démarche de la prospective[10], il nous revient d’établir le bon équilibre que constitue un « principe d’audace responsable », dans la ligne des propositions du rapport de la commission « Innovation 2030 »[11] : un juste milieu entre un usage excessif du principe de précaution et une témérité irraisonnée. Osons donc la transition numérique, mais sans oublier que, pour être en mesure d’oser durablement, une certaine prudence est également de mise. Gardons avant tout à l’esprit que le plus sûr rempart contre la folie du trans-humanisme est le sage recours aux valeurs humanistes !

Face à l’indétermination structurelle propre à l’invention du futur, une bonne nouvelle est néanmoins certaine : décennie après décennie, internet puis ses successeurs – intermind ? – offriront à l’imagination de ses architectes, comme à l’intelligence de ses analystes, un grain indéfiniment renouvelé, à moudre et à remoudre !

Mots-clés : internet – numérique – expansion universelle – noosphère – utopie – dystopie – audace – précaution

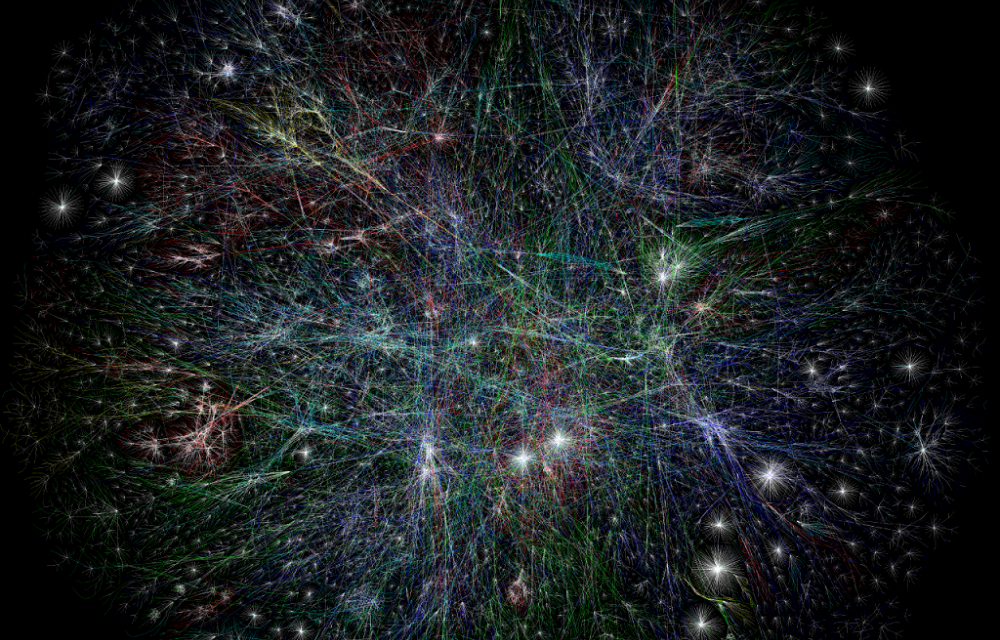

Illustration de l’article : carte des liens d’internet (OPTE Project, extrait) – http://www.opte.org/

Références

BROUSSEAU, Éric & Nicolas CURIEN, Internet Economics, Digital Economics, Cambridge University Press, 2007.

JOUVENEL, Bertrand de, L’art de la conjecture, 1967.

LAUVERGEON, Anne, (sous la direction de), Un principe et sept ambitions pour l’innovation, Rapport de la commission « Innovation 2030 », 2013.

PATINO, Bruno, La civilisation du poisson rouge : petit traité sur le marché de l’attention, Grasset, 2019.

TEILHARD de CHARDIN, Pierre, Le Phénomène humain, éditions du Seuil, 1955.

[1] Pierre Teilhard de Chardin, Le Phénomène humain, 1955, éditions du Seuil.

[2] « Governments of the industrial world, you weary giants of flesh and steel, I come from Cyberspace, the new home of Mind. On behalf of the future, I ask you of the past to leave us alone. You are not welcome among us. You have no sovereignty where we gather. »

[3] Asymmetric Digital Subscriber Line

[4] « NU » comme « Not Unix ».

[5] Éric Brousseau & Nicolas Curien, Internet Economics, Digital Economics, Cambridge University Press, 2007.

[6] L’économie de l’attention est la branche de l’analyse économique qui s’intéresse aux procédés par lesquels les firmes cherchent à capter l’attention des consommateurs afin de susciter des comportements d’achat, notamment via des plans de communication publicitaire dans les médias. Bien qu’ancien, ce domaine de réflexion connaît actuellement un fort regain d’intérêt, avec le développement des techniques mises en œuvre par les grands acteurs d’internet afin de maximiser le temps de présence devant les écrans.

[7] peur d’oublier son téléphone portable.

[8] Bruno Patino, La civilisation du poisson rouge : petit traité sur le marché de l’attention, Grasset, 2019.

[9] NBIC = Nano-Bio-Information-Communication

[10] Bertrand de Jouvenel, l’Art de la conjecture, 1967.

[11] Anne Lauvergeon, Un principe et sept ambitions pour l’innovation, rapport de la commission « Innovation 2030 », 2013.

- Le beau, le vrai et le bon - 19 décembre 2024

- Faire face à l’invasion du faux !* – Partie 2. Les remèdes technologiques et juridiques - 19 septembre 2024

- Faire face à l’invasion du faux !* – Partie 1. Les pathologies de l’information et leurs impacts - 12 septembre 2024

Pourquoi dater le smartphone de 2002 ? Il me semble que 2007 et l’Iphone serait plus réaliste.

Il serait sans doute plus juste de parler de la décennie 2000 comme période d’essor des mobiles. S’agissant de 2002, je pense au lancement du premier Blackberry. L’année 2007, avec l’arrivée du premier i-Phone (le 9 janvier), est également emblématique, ainsi que vous l’indiquez,