Cet article est publié en deux parties. La première partie commence au XIIIème siècle et s’achève aux neurones artificiels et aux travaux de Norbert Wiener. La seconde partie nous conduira de la naissance de l’informatique à l’actualité la plus récente autour du Learning.

Première partie : des origines à Norbert Wiener

Les mots « Intelligence artificielle » sont partout ces derniers temps. Ils apparaissent même en couverture de divers magazines, avec des articles intéressants et pertinents. Cette mise en avant de l’IA n’a pas toujours été la réalité du domaine, il y a eu des périodes où l’on parlait plus des « hivers » de l’IA.

En préambule, quelques définitions

Ces définitions sont utiles pour comprendre les thèmes abordés, et, partant, ceux qui ne le seront pas.

Empruntons la définition de Yann LeCun. Diplômé de l’ESIEE en 1983, docteur en 1987 à l’Université Paris 6, titulaire de la chaire « Informatique et sciences numériques » du Collège de France en 2016, premier directeur du Facebook Artificial Intelligence Center à New-York puis Paris, il est l’un des leaders français et mondiaux en matière d’Intelligence artificielle et de Deep Learning. Sa définition de l’IA est la suivante : « faire faire aux machines des activités que l’on attribue généralement aux animaux et aux humains ».

L’Intelligence artificielle couvre le champ de la robotique et de l’apprentissage. Sera abordé ici du seul apprentissage et plus précisément de la catégorie d’apprentissage qualifiée de numérique, par opposition à l’apprentissage symbolique. Ce dernier a été longtemps dominant quand il était question d’IA, avec, par exemple, les systèmes experts ou la représentation des connaissances. Il sera donc question de l’histoire de l’apprentissage numérique, supervisé ou non supervisé, et plus particulièrement du connexionnisme. Cette histoire est indissociable de celle du développement de l’informatique.

Comment distinguer apprentissage supervisé et apprentissage non supervisé ? En peu de mots, l’apprentissage consiste à faire apprendre de nombreux exemples ou cas à des algorithmes. En apprentissage supervisé, ces exemples ont des étiquettes, c’est-à-dire que l’on sait a priori ce que l’algorithme devrait trouver. Une illustration est le scoring bancaire, où pour évaluer la qualité future d’un emprunteur, la base d’exemples est constituée de vrais cas de bons ou mauvais payeurs du passé. Pour les spécialistes de la Statistique, il s’agit de régression, de classification : disposant d’une variable Y et de variables amont X, il convient d’expliquer Y par X et faire de la prédiction. Donc plutôt prédire qu’expliquer, détail qui a son importance.

L’apprentissage non supervisé consiste à essayer de classer, de trouver des structures sous-jacentes à partir de données non étiquetées.

En remontant loin dans le temps

Ramon Llull

Il serait peut-être possible d’aller jusqu’à Babylone ou l’Empire chinois, tant il semble naturel d’avoir très tôt cherché à modéliser le comportement du cerveau humain et à représenter l’homme comme une machine pour pouvoir ensuite concevoir des machines apprenantes : si la représentation du vivant par une machine est réussie, alors il « ne reste plus qu’à » créer des machines imitant l’homme.

Ramon Llull

Un précurseur est le catalan Ramon Llull (1232 – 1315 ; Raymond Lulle en français), philosophe théologien, inventeur des « machines logiques ». Les théories, sujets et prédicats théologiques, étaient organisés en figures géométriques considérées comme parfaites (cercles, carrés, triangles). A l’aide de cadrans, de manivelles, de leviers, et en faisant tourner une roue, les propositions et les thèses se déplaçaient pour se positionner en fonction de la nature vraie ou fausse qui leur correspondait. L’influence de Llull sur ses contemporains est considérable, et même au-delà, puisque quatre siècles plus tard, Gottfried Leibniz se considère comme inspiré par ses travaux.

De l’animal-machine à l’homme-machine

René Descartes est le tenant de l’animal-machine. Il considère qu’un animal n’est rien d’autre qu’une machine perfectionnée, une horloge composée de pièces mécaniques et de ressorts. Walter McCulloch, inventeur, avec Walter Pitts, des réseaux de neurones artificiels, estimait qu’il s’agissait de « très bonne physique » et que la cybernétique commençait plutôt avec Descartes qu’avec Leibniz.

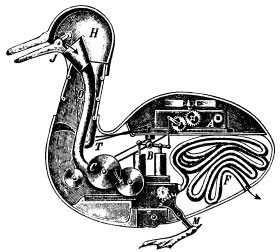

La représentation ci-dessus est celle du canard de Jacques Vaucanson (1709 – 1782), objet dont la trace a été hélas perdue. Inventeur et mécanicien français, spécialiste des automates, Vaucanson a conçu ce canard mécanique qui mange, digère, défèque. L’animal est une machine, mais pas encore une machine pensante. Vaucanson lègue sa collection d’automates au roi Louis XVI. Ce dernier achète alors en 1783 l’hôtel de Mortagne, dans l’actuel 11ème arrondissement, pour y créer le Cabinet des mécaniques du roi, ancêtre du Conservatoire National des Arts et Métiers.

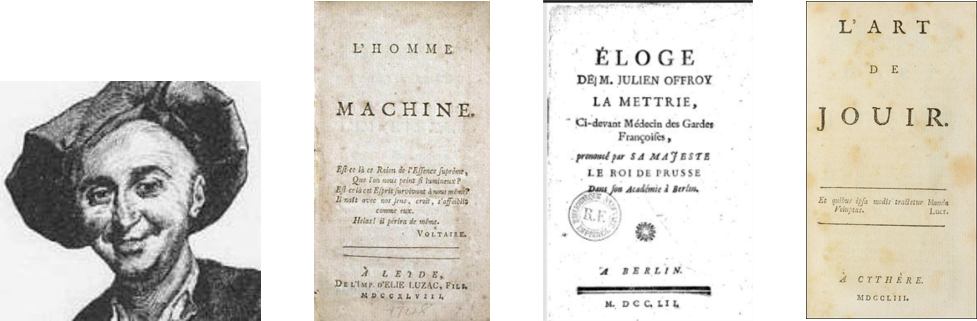

Le grand théoricien de l’homme machine est Julien Jean Offray de La Mettrie (1709 – 1751), précurseur des Lumières, médecin et philosophe matérialiste. Son œuvre principale est son livre « L’homme machine », publié en 1747.

Pas vraiment en odeur de sainteté sur le territoire français, car adepte des plaisirs des sens, il part pour Berlin, accueilli par Frédéric II, roi de Prusse, qui prononcera lui-même son éloge funèbre en français. Il a lui-même donné du grain à moudre à ses détracteurs, qui le considéraient comme libertin, dissolu ou corrompu, par ses livres « De la volupté » (1745) et « L’Art de jouir » (1751). Tout un programme.

Les neurones artificiels

Arrivons au XXème siècle et à l’histoire des réseaux de neurones.

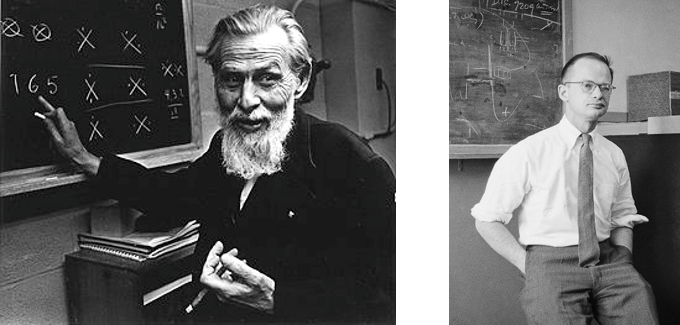

L’article « A logical calculus of the ideas immanent in nervous activity » des américains Warren McCulloch (1898 – 1969) et Walter Pitts (1923 – 1969) marque la naissance du connexionnisme. McCulloch est neurophysiologiste, Pitts est logicien, avec un écart de 25 ans d’âge, mais décédés la même année, en 1969.

Leur article, publié en 1943 dans le Bulletin of Mathematical Biophysics, a révolutionné le domaine. Leur objectif initial était de convaincre les neurophysiologistes de l’intérêt de leurs travaux, mais sans succès auprès des confrères de McCulloch. Par contre, d’autres personnes s’y sont intéressées.

W. McCulloch W. Pitts

Leur publication contient des schémas de modélisation de synapses, de neurones, etc. Bien sûr, leur approche est différente des représentations modernes d’un réseau de neurones. Dans le modèle de McCulloch et Pitts, les auteurs décrivent « seulement » ce que pouvaient faire les neurones artificiels quand on les mettait en réseau, mais il n’y a pas d’algorithmes d’apprentissage.

En conclusion de leur article, ils font référence à Alan Turing et sa fameuse machine (Turing a présenté dès 1936 une expérience de pensée qui prendra ensuite le nom de « machine de Turing »). Ils annoncent que leur réseau de neurones va être capable de réaliser le programme de la machine de Turing et que tout ce qui peut être fait par la machine de Turing peut l’être également par des réseaux de neurones. Ils mentionnent enfin les travaux d’Alonzo Church (1903 – 1995), considéré comme l’un des pères de l’informatique théorique, travaux publiés dans les années 1930, et dont Turing fut un élève à Princeton.

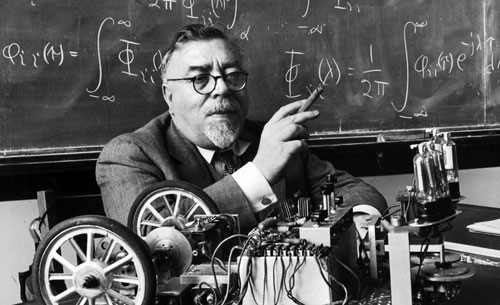

Si l’objectif de la famille des neurophysiciens n’a pas été atteint, l’article de McCulloch et Pitts attire l’attention de John von Neumann et du célèbre Norbert Wiener, à l’origine du mouvement de pensée de l’époque : la cybernétique et ses membres, les cybernéticiens. Le livre de Wiener « Cybernetics, or Control and Communication in the Animal and the Machine » est publié simultanément en 1948, en anglais, par la librairie Hermann & Cie (Paris), The MIT Press (Cambridge, Mass.) et Wiley (New York).

Qu’est-ce que la cybernétique ? Wiener la définit comme une science générale du fonctionnement de l’esprit. Le mot vient directement du grec ancien κυβερνητική, lui-même dérivé du verbe kubernan qui signifie le fait piloter un char ou un bateau, donnant naissance à gouvernail ou plus généralement gouvernance.

La pensée cybernétique connaît un grand succès, en particulier en URSS, après la période Staline et Lyssenko, qui s’y montrent peu favorables. Dès la fin des années 50, la cybernétique connait un mouvement extraordinaire et on trouve encore en Europe centrale, orientale et en Russie des facultés et des départements de cybernétique au sein des universités.

En Europe occidentale ou en Amérique, le mot n’est maintenant plus guère utilisé ; il n’en reste que les deux premières syllabes, que l’on retrouve dans cybercriminalité ou cyber-espion.

Norbert Wiener

Norbert Wiener (1894 – 1964) était ce qu’il est convenu d’appeler un enfant prodige : élève de professeurs de génie tels David Hilbert et Bertrand Russell, il obtint son doctorat à 16 ans à Harvard. Sa famille prétendait descendre de Moïse Maïmonide, médecin, talmudiste et philosophe juif (1138 – 1204), ce qui n’a jamais été prouvé. Il a été très inspiré par les travaux de McCulloch et Pitts ; il était fasciné particulièrement par la personnalité du jeune Pitts. En 1945, Wiener écrit à son propos : « C’est sans conteste le plus grand jeune scientifique que je n’ai jamais rencontré ».

La lune de miel entre les deux génies s’interrompt brutalement en 1952, du fait de Wiener. Wiener n’adressa plus jamais la parole à Pitts, sans la moindre explication. Dans le livre qu’ils consacrent à Wiener « Héros pathétique de l’âge de l’information », publié en 2005, Flo Conway et Jim Siegelman évoquent non pas une cause scientifique, mais une histoire personnelle.

A suivre, la deuxième partie : de la naissance de l’informatique au Deep Learning

Commentaires récents