Les deepfakes sont un outil de manipulation dont l’impact sur la société est encore peu maîtrisé. Leur existence et leur utilisation soulèvent de nombreuses questions d’ordre légal et éthique. Alors que la technologie évolue, il s’avère également de plus en plus compliqué d’identifier un faux, alors qu’il est urgent de pouvoir reconnaître le « vrai ». Face à ces enjeux, le dernier rapport du Club Praxis, « Deepfakes & Algorithmes », formule douze recommandations pour développer une connaissance européenne des outils de détection de faux. Emilie Rannou (ENSAE 2007), qui a encadré l’élaboration de ce rapport, répond aux questions de variances.eu.

- Comment est né ce rapport ?

J’ai travaillé quatre ans aux Etats-Unis et ai rejoint un think tank franco-américain, Praxis, fondé en 2007 par Yann Coatanlem[1] et regroupant des chercheurs, économistes, experts indépendants basés aux Etats-Unis qui se proposent d’analyser des données pour suggérer des politiques publiques innovantes. Nous avons entre autres publié un rapport sur l’impact du numérique sur le secteur de la santé.

En 2019 j’ai proposé l’idée d’un rapport sur les algorithmes de génération de contenu à Praxis car ces enjeux me paraissaient essentiels pour l’avenir de nos sociétés. Les aspects techniques sont passionnants et les applications multiples.

J’ai donc rassemblé un ensemble d’experts intéressés par ce sujet pour se pencher sur les enjeux liés aux algorithmes de génération de contenu et formuler des recommandations qu’il nous paraissait pertinent d’implémenter à un niveau européen. Le résultat en est un rapport très détaillé (https://www.clubpraxis.com/deepfakes-et-algorithmes) , dont l’élaboration a pris plus d’un an, et qui aborde les questions techniques, éthiques, légales soulevées par les deepfakes.

- Emilie, peux-tu nous dire ce que sont les deepfakes ?

Ce sont de faux contenus générés par des algorithmes d’apprentissage profond, le deep learning en anglais, d’où le nom de deepfake : deep pour profond et fake pour faux. Mais peut-être me demanderez-vous dans ce cas qu’est-ce que le deep learning ? C’est une méthode d’apprentissage basée sur ce qu’on appelle les réseaux de neurones profonds, c’est-à-dire des algorithmes d’intelligence artificielle qui s’inspirent du fonctionnement du cerveau, et plus particulièrement du transfert d’information entre les neurones via les synapses : une couche unique de neurones permet à l’algorithme d’apprendre des règles simples (par exemple de classifier un mot en féminin, masculin ou en neutre à l’aide d’un apprentissage sur un dictionnaire) quand un réseau de neurones profond se compose de plusieurs couches de neurones, permettant un apprentissage plus complexe, comme celui d’un concept – par exemple d’identifier une image comme celle d’un chat, d’un chien ou d’un singe.

Si les deepfakes peuvent être de fausses vidéos, comme dans l’exemple récent de la vidéo diffusée sur Channel 4 où une fausse reine d’Angleterre présente ses vœux avant de terminer par une danse, nombreux sont ceux qui oublient que les deepfakes peuvent aussi être de faux textes, de faux enregistrements audio, voire de fausses images.

- On évoque surtout les deepfakes pour souligner leurs applications malveillantes. Peux-tu nous en donner des exemples ?

Les premières applications malveillantes se sont répandues en 2018. Il s’agissait notamment de vidéos pornographiques ou humiliantes (deepfake porn) reconstituées avec les visages de simples étudiantes ou de stars – Scarlett Johansson entre autres a été victime de ce genre de deepfake.

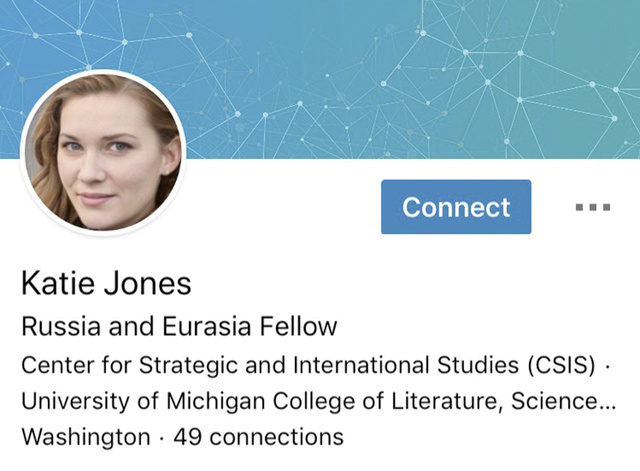

Un autre risque apparaît aujourd’hui de plus en plus prégnant : la création de faux profils postés sur Twitter, Facebook ou sur d’autres réseaux sociaux comme par exemple celui de « Katie Jones », détecté sur LinkedIn par Associated Press, qui a très vraisemblablement été généré par des GANs (Generative Adversarial Networks – techniques de deepfake sophistiquées).

Nombre de ces faux profils sont en fait ce qu’on appelle des bots, c’est-à-dire des robots programmés pour publier des commentaires et l’actualité récente a encore illustré l’utilisation de ces faux profils pour tenter d’influencer des élections locales.

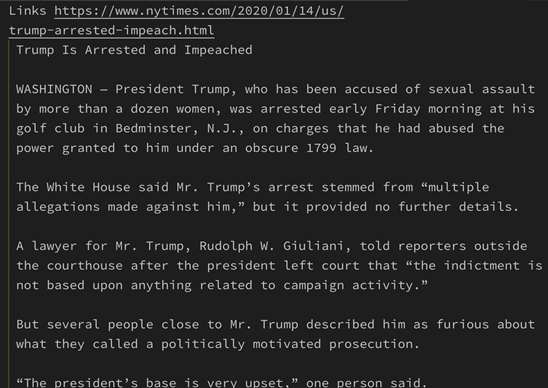

Cette capacité à créer de faux profils est d’autant plus dangereuse que les deepfakes s’appliquent également à des textes (les algorithmes de génération de texte comme BERT ou GPT3 développés par Google d’une part et Open AI d’autre part sont les plus avancés aujourd’hui), permettant par exemple de générer des commentaires à large échelle voire des « discussions » entre faux profils sur un forum – comme de faux articles de presse, dont le texte copié ci-dessous par exemple :

Le site « this person does not exist » https://thispersondoesnotexist.com/ a vocation à sensibiliser à ce sujet en montrant des photos de personnes générées par de l’IA. Deux « hacktivistes » anglais se sont aussi penchés sur le sujet et ont créé une vidéo mettant en scène Mark Zuckerberg qui avoue avoir compris l’intérêt de voler des milliers de données grâce à une organisation secrète.

- Pourtant, les deepfakes peuvent également donner lieu à des applications utiles ?

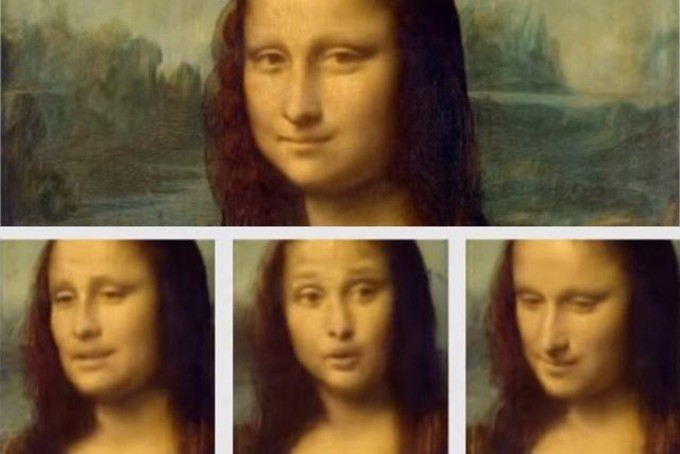

Il est important de souligner la diversité des applications plus positives pour la société. Ainsi, les premières applications des algorithmes de génération de contenu étaient ludiques. Par exemple, l’application russe FaceApp permettait de faire vieillir une photo ou d’ajouter un sourire sur un tableau :

Grâce à cette technologie, des chercheurs de Samsung ont aussi fait revivre le fameux tableau de Léonard de Vinci, La Joconde.

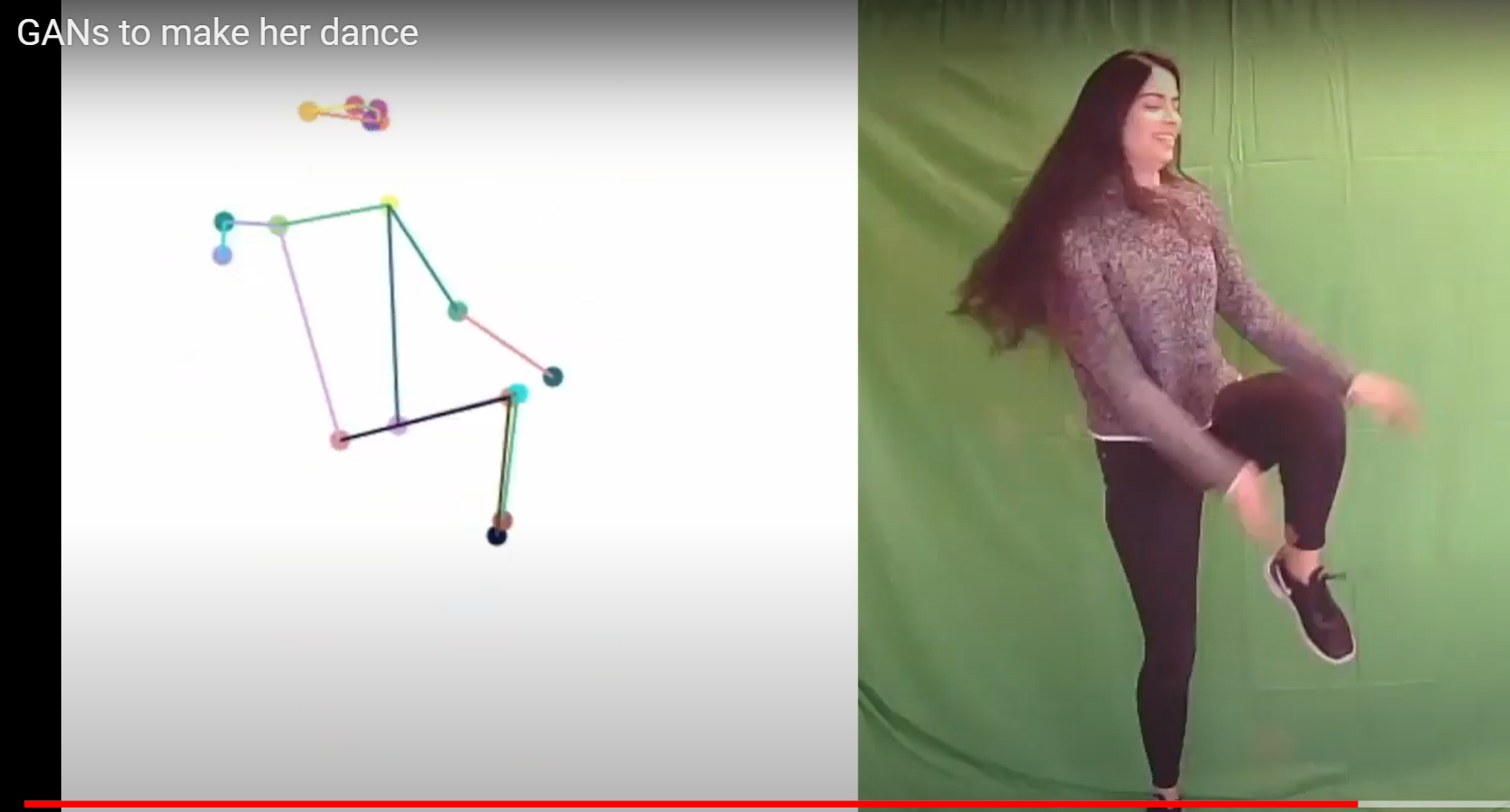

Dans le domaine de la vidéo ils peuvent transférer un mouvement et faire danser une personne qui ne sait pas danser (https://www.youtube.com/watch?v=TXc6-ZTtlHw).

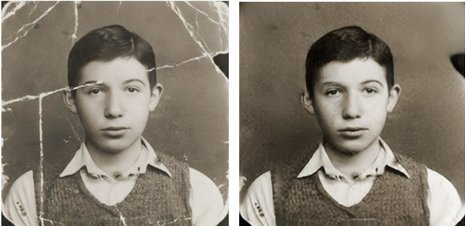

Ces technologies de deepfake sont utiles pour la restauration d’image. Voici par exemple le résultat obtenu en utilisant des VAEs (Variational Auto Encoders, https://arxiv.org/pdf/2009.07047v1.pdf) :

Elles sont aussi utiles pour remplacer un acteur par un autre, comme ci-dessous dans la série « Plus belle la vie » (à gauche l’actrice réelle et à droite le résultat du deepfake).

D’une manière générale ils permettent aussi de compenser le manque de données existantes. Ceci peut s’avérer très utile pour mieux prédire ou contrôler un phénomène comme en cybersécurité ou en épidémiologie. Par exemple, Gabriel Turinici, qui a participé au groupe de travail que j’ai encadré, mène des recherches sur la manière dont ces algorithmes peuvent être utilisés pour mieux prédire l’impact d’une épidémie de grippe.

- Quelles sont les principales recommandations de ce rapport ?

Ce rapport se penche sur les enjeux sociaux, légaux mais aussi techniques liés aux deepfakes, notamment pour lever la difficulté de détection de faux.

Nous avons publié ce rapport juste avant la publication du DSA Digital Services Act, proposition de texte pour une régulation des géants du numérique par la Commission Européenne, et nous avons été surpris de voir que le DSA ne mentionnait pas les deepfakes alors que le risque d’ingérence qu’ils représentent est significatif.

Tout d’abord nous pensons que le plus urgent est d’investir dans la recherche sur le sujet au niveau européen, à travers une meilleure coordination européenne, par exemple en créant une entité de recherche axée sur la compréhension des outils de faux et le développement de techniques de détection de faux. Cette institution pourrait travailler en coordination avec l’ENISA (Agence de l’Union européenne pour la cyber-sécurité). Un des objectifs de cette institution pourrait être de développer des standards de détection de faux, que les géants du numérique seraient obligés d’utiliser.

Ensuite, il nous parait essentiel de mettre en place un cadre légal plus clair pour pénaliser l’utilisation malveillante de deepfakes. Selon nous, l’utilisation de deepfakes devrait être considérée comme un facteur aggravant dans toute violation qui concerne le droit à l’image et le droit à la propriété notamment.

Enfin, pour protéger les citoyens, il est nécessaire de mieux encadrer les plateformes internet et leurs utilisateurs. De nombreuses vidéos de deepfakes ont été postées récemment pour sensibiliser les citoyens aux deepfakes et leur dire de ne pas systématiquement croire ce qu’ils voient ; mais comment savoir ce qu’on peut croire ou non ?

A cette fin nous recommandons que les plateformes fassent preuve de plus de transparence, en imposant aux auteurs des posts de signaler l’utilisation d’un algorithme de génération de faux, que le contenu créé soit fait pour un objectif malveillant ou non comme pour une simple parodie, mais aussi qu’elles mettent en place des mesures de sanctions dissuasives en cas de détection d’un deepfake non signalé comme tel (limitation du nombre de posts voire suspension du compte).

- Quelques mots pour terminer sur ta situation professionnelle actuelle : tu travailles au sein d’Ekimetrics, disposez-vous d’outils de détection de faux dans ton entreprise ?

Ekimetrics est une entreprise de data science française fondée en 2006 qui accompagne les entreprises dans le développement de solutions d’intelligence artificielle. Ekimetrics est leader européen dans ce domaine. Même si nous avons encore aujourd’hui peu de demandes de la part des entreprises sur des sujets liés aux deepfakes, nous les étudions dans le cadre de nos projets de recherche.

Par construction, un algorithme de création de faux constitue également un outil précieux pour détecter du faux. Notamment les GANs (Generative Adversarial Networks) sont des algorithmes qui sont composés de deux sous-algorithmes, l’un qui génère un contenu et l’autre qui détecte si le contenu est faux. Une fois l’algorithme entrainé pour générer un contenu réaliste, il peut aussi être utilisé pour détecter si un contenu est faux !

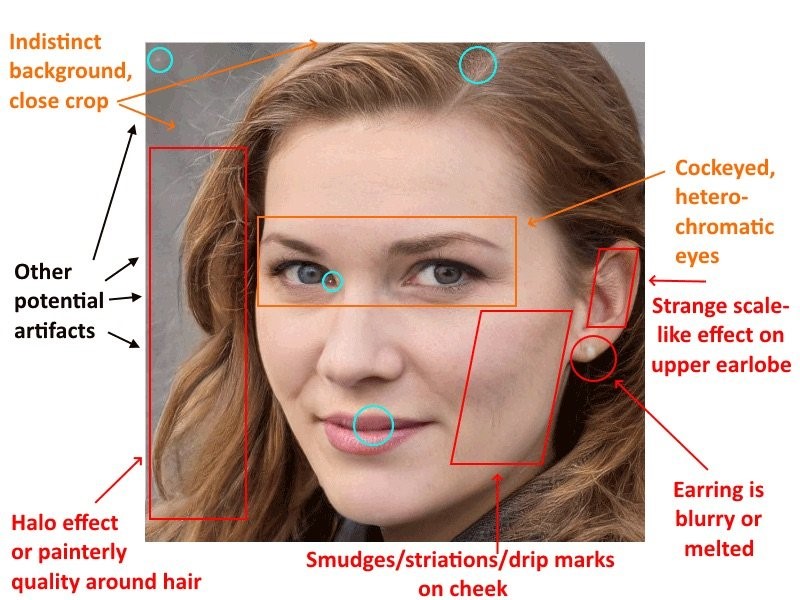

En plus de la possibilité d’utiliser les algorithmes, nous maîtrisons des techniques de détection d’anomalies qui permettent de détecter certains faux. Le faux profil LinkedIn décrit plus haut a ainsi pu être identifié comme faux grâce à des incohérences visuelles comme détaillé ci-dessous.

Les algorithmes de génération de faux ne sont heureusement pas encore parfaits !

Commentaires récents