Contexte personnel

Travaillant dans un laboratoire du CNRS sur l’interaction humain-machine, j’ai été associée début 2017 à la grande réflexion sur l’Intelligence Artificielle, qui allait donner naissance à France IA, et notamment dans le groupe animé par Lionel Janin et Laurent Vitti sur la thématique du travail et l’IA, tout particulièrement sur la thématique de l’acceptation et la confiance autour des modifications dans le travail.

Je contribue à l’institut de convergence appelé DATAIA, pour trouver des outils de mesure des systèmes, contrôler ce qu’on fait dans l’apprentissage machine et l’Intelligence artificielle ; également à TransAlgo, sur la transparence des algorithmes et j’anime, dans l’écosystème public-privé France IA, un groupe de travail sur l’éthique dans l’industrie : comment faire pour insuffler plus d’éthique et plus de réflexions autour des produits en cours d’élaboration ? J’encadre également une équipe de recherche travaillant sur les dimensions affectives et sociales dans les interactions parlées, donc les émotions dans les interactions. Comment travailler sur ces sujets, quels outils utilise-t-on, voici le thème global ce mon intervention. Je suis aussi membre de la CERNA, Commission de réflexion sur l’Éthique de la Recherche en sciences et technologies du Numérique d’Allistene, l’une des alliances autour de l’INRIA, avec le CNRS, le CEA, et des grandes écoles comme l’X, Mines-Télécom, etc. Le groupe animé par Raja Chatila, professeur et directeur de l’Institut des Systèmes Intelligents et de Robotique (ISIR), ancien président de l’IEEE Robotics and Automation Society, a produit en 2014 un rapport sur l’éthique du chercheur robotique, contenant des préconisations pour les secteurs de la recherche et, plus largement, pour nos gouvernements décideurs.

Mon expertise touche le machine learning et les réseaux de neurones, passion depuis longtemps puisque dès ma thèse je faisais des réseaux de neurones hybridés pour la reconnaissance de la parole et le traitement du signal. Beaucoup de travaux autour de la santé, d’où le titre de cette communication, la robotique évoquée ayant plutôt l’idée d’assister, de stimuler les réflexions autour des sujets de santé.

Robots et systèmes complexes

Qu’est-ce qu’un robot conversationnel empathique ? Et, en amont, qu’est-ce que l’Intelligence Artificielle ? C’est une discipline qui vise à modéliser et simuler les capacités cognitives de l’humain. Le terme d’Intelligence Artificielle est un oxymore. Si nous revenons à l’origine du terme, il nous faut relire Turing. Une définition simplifiée, c’est dire que l’IA est principalement de la simulation de comportement.

La robotique a engendré beaucoup de peurs. L’Intelligence Artificielle permet, à la fois, de modéliser des capacités de perception, de raisonnement. Un robot contient tout cela. Différents modules d’Intelligence Artificielle vont être utilisés, à partir de capteurs, pour comprendre l’environnement ; des processeurs avec de l’IA vont prendre des décisions, raisonner autour des paramètres qui ont été capturés ; des actionneurs pour aller dans le monde en trois dimensions, qui est le nôtre, pour agir et proposer des solutions, exécuter des actions.

Les robots conversationnels empathiques ont, en plus, la capacité de dialoguer et donc d’utiliser la parole pour interagir avec une personne. Ils vont jusqu’à simuler l’humour et l’empathie. Dans le monde robotique de l’IA sont employés des termes liés à l’intelligence humaine, ce qui est aussi une source de facteurs embrouillant le débat actuel.

Pourquoi, nous, chercheurs, allons-nous vers cette complexité ? Les premiers systèmes que j’ai conçus étaient pour les call centers. Ensuite, il y eut des agents conversationnels qui peuvent être juste une tête sur un écran en 2D ou alors en trois dimensions avec un corps, c’est-à-dire un chatbot avec un corps ; les chatbots sont les agents conversationnels. L’étape ultérieure est le robot. A propos du robot, la différence est la complexité de l’environnement à comprendre. En effet, dans un environnement virtuel, il est possible de connaître tout l’environnement. Les agents qui interagissent au sein de cet environnement virtuel connaissent ce que sont les autres. Mais dans le monde réel, un robot ne connaît plus rien, il ne voit pas grand-chose et ne comprend pas grand-chose.

Cependant, cette situation complexe laisse entendre que l’on construit des systèmes fortement intelligents, ce qui est totalement faux. Ce n’est pas parce qu’on met plusieurs briques d’Intelligence artificielle au sein d’un système complexe que l’on a résolu tous les problèmes, et il y a un écart énorme avec ce que l’on sait faire sur des domaines très spécifiques avec des outils d’apprentissage de machines génératives, de Deep Learning, ou autre. Les usages sont multiples : faire de la détection des émotions, de la détection de la parole, de la reconnaissance d’images, pour susciter le dialogue et enchaîner les différents axes de dialogue, pour synthétiser de la parole qui s’approche de la parole humaine ou est une parole humaine ; des personnes décédées continuent à parler. Tout ceci laisse entendre que, derrière cette capacité, existerait une personnification de la machine ayant toutes ces facultés, mais rien ne fait le lien : aucun moteur particulier, sauf ce que les ingénieurs ont mis dans ces systèmes. Autre point : la forte capacité du public à « projeter », fantasmer sur ces machines.

Abordons donc ces deux sujets, à la fois la technologie et en même temps la projection faite sur ces machines, et le besoin d’éthique à tous les moments. Il est donc pertinent de sortir de mon laboratoire pour parler de façon plus vulgarisée, plus ouverte, plus transdisciplinaire ou interdisciplinaire et bien faire comprendre les soucis éthiques et les besoins de régulation.

Des exemples actuels

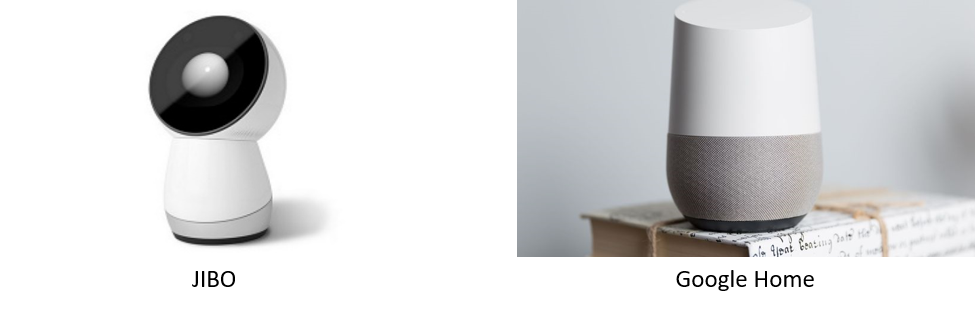

Actuellement, quels sont les robots empathiques ? Le premier est un robot domestique qui devrait bientôt être commercialisé, dont le nom, aux Etats-Unis, est Jibo

Jibo est un robot qui bouge le visage. On peut parler de « bot » quand il n’y a pas du tout « d’incarnation ». Dès lors que l’on a une incarnation… Google Home est une enceinte, un micro. Jibo a une esquisse de visage, des yeux, et il va plus susciter l’attention du public qui lui confèrera probablement plus de capacités.

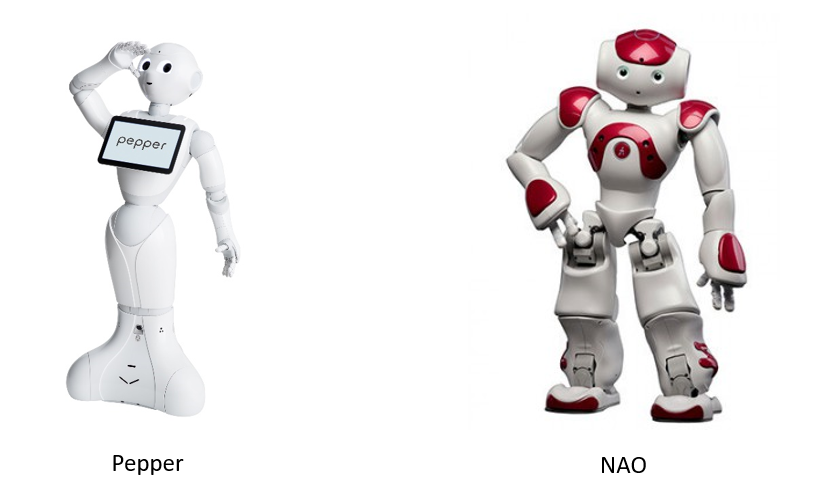

Ensuite , voici les robots qui marchent, auxquels on demande un mouvement.

Paro, le phoque, a été conçu en 1993 au Japon, montré publiquement pour la première fois en 2001 ; c’est une peluche robotisée représentant un bébé phoque. Son public est les personnes âgées, avec la mission de les occuper et réduire leur stress, pas pour les assister et stimuler certaines de leurs capacités. En général, l’utilisation de ces robots est faite conjointement avec un thérapeute ou un gériatre. Ils sont efficaces pour éveiller les personnes qui sont vraiment dans un repli sur soi, ou atteintes par une maladie dégénérative comme Alzheimer, avec accompagnement d’un référent pour suivre des conférences sur ces machines et leur expérimentation, pour une bonne compréhension des usages et de leurs bénéfices. Voici un sujet actuel de société : comment éviter le potentiel clivage entre les personnes connaissant ces sujets et celles qui les ignorent, mais utilisatrices possibles pour réduire leurs peurs.

J’ai pu assister à une expérience avec Paro, par une personne totalement repliée sur elle-même, sans aucun échange en parole avec son groupe environnant. Elle a pris cet objet dans ses bras et a immédiatement changé et s’est éclairée. Ce phoque réagit au toucher, à la chaleur et un peu à la voix, comme un animal familier. La personne âgée s’en est occupé, lui a porté une attention particulière. Cela ne nécessite pas de mots. Mais en plus, les autres personnes autour d’elle se sont approchées, et un lien social s’est établi autour de cette machine.

Pepper et NAO, sur l’image ci-dessus, sont deux autres robots conçus et développés par la société française Aldebaran, rachetée en 2015 par la société japonaise Softbank Group du secteur de la téléphonie, et renommée maintenant Softbank Robotics. Pepper peut être vu dans la grande distribution par exemple pour soumettre des questionnaires clients. NAO est utilisé dans des EHPAD et des maisons de retraite, ou en milieu hospitalier. Des expériences très intéressantes sont menées par le CHU de Nantes : le robot n’est pas utilisé comme une personne, mais comme un moyen de communication auprès d’enfants ou adolescents autistes. Ils ont appris à utiliser le logiciel chorégraphe pilotant le robot, logiciel graphique assez simple basé sur la voix, qui permet au robot de bouger et s’exprimer à la place des enfants. Les chercheurs du CHU de Nantes se sont aperçus que des enfants qui ne parlaient pas ou peu aux autres enfants autour d’eux se sont mis à beaucoup plus leur parler à travers cet objet.

Donc NAO est plus qu’un objet extérieur, c’est un objet qui est aussi un médium. Non seulement il existe un lien avec la personne qui l’utilise, mais aussi, par exemple, avec un médecin qui peut ainsi interagir via le robot. Il faut, bien sûr, arriver à comprendre cette interaction complexe et qui rompt l’isolement.

Les émotions

Dialoguer, c’est co-construire, détecter les émotions de l’autre. On utilise la théorie de l’esprit pour essayer de comprendre, à partir de l’expressivité de quelqu’un, dans quel état il se trouve. A-t-il compris ce qui a été dit ? Est-il attentionné ? A-t-il un affect particulier ? Tout se voit dans nos visages, qui expriment tant de choses. Cicéron disait déjà, avant notre ère, « le visage est le miroir de l’âme ». Même quand nous avons l’impression de ne rien exprimer, il est encore possible de déceler de l’attention, de l’intérêt, du désintérêt, de la désapprobation et de l’affectif. Au-delà du langage verbal, ces indices apportent de l’information.

Le langage verbal est de la linguistique. On peut parler de linguistique, plus généralement, lorsqu’on s’intéresse à tous les indices corporels issus du visage, des gestes, de la voix. Mon thème de recherche est principalement la détection des informations de type émotionnel dans la voix.

La machine fait de la simulation grâce à des modèles d’Intelligence Artificielle. Il faut mentionner les travaux et l’apport de Rosalind Picard, professeure d’Arts des médias et Sciences au MIT, et directrice du Groupe de recherche en Informatique affective du MIT Media Lab (cf Affective Computing, MIT Press, 1997), avec trois grands domaines : la détection des émotions, le fait de comprendre et le fait de raisonner dans le dialogue, en prenant aussi en compte la façon dont les personnes émettent leurs sons. Une phrase comme « je suis d’accord ! » prononcée de manière agressive ou de manière douce n’aura pas le même impact, bien que la phrase soit identique sémantiquement. Le ton de la voix joue énormément. Pour exprimer un accord, selon la tonalité, des « oui » valent un non et inversement, des « non » sont pratiquement des acceptations.

Beaucoup de chercheurs travaillent sur ces fonctions autour des émotions. Le sujet est revenu à la mode grâce aux recherches en neurosciences. En particulier, Antonio Damasio, médecin, professeur de neurologie, neurosciences et psychologie, directeur depuis 2005 de l’Institut pour l’étude neurologique de l’émotion et de la créativité de l’University of Southern California, a écrit deux livres très pertinents : « L’erreur de Descartes » (Ed. Odile Jacob, 1995) et « Spinoza avait raison » (Ed. Odile Jacob, 2003). Ces ouvrages abordent le fait qu’émotions et impact émotionnel dans l’interaction sont nécessaires au raisonnement rationnel, contrairement à l’approche de René Descartes. Si l’on ne comprend pas les émotions des autres et si l’on ne sait pas réguler ses propres émotions, alors on est incapable de s’adapter, de diriger une équipe, de comprendre les non-satisfactions d’autrui, et de pouvoir les encadrer au mieux.

Le QI, quotient intellectuel, est connu depuis longtemps. Le quotient émotionnel, reconnu dans les années 1990, est tout aussi important, même si l’on en entend moins parler. Klaus Scherer, psychologue à l’université de Genève, a travaillé toute sa vie sur les théories des émotions, leur représentation et leur modélisation en machine. Bien que n’étant pas en IA, il a contribué à un réseau d’excellence européen très pluridisciplinaire : neuroscientifiques, linguistes, philosophes, psychologues, sociologues. De toutes ces théories sont issues des informations nécessaires lorsque l’on veut faire de la simulation sur machine, en étant conscient que, dans tous les cas, l’on réduit de beaucoup la complexité.

La détection des émotions se réduit à l’expressivité de la personne, pas plus ! Quand des chercheurs qui ne sont pas du domaine prétendent que la machine comprend les émotions, il s’agit de communication industrielle, de marketing. Une machine ne comprend rien, elle n’a pas d’émotion. Le reste n’est que fiction ou mensonge.

On peut essayer de déceler la réaction individuelle à un stimulus particulier, ou détecter les réactions psychologiques et physiologiques de l’organisme, comme le fait de parler plus vite en état de stress, de rougir. Le rythme cardiaque est estimable à partir d’informations visuelles. Beaucoup de travaux sont faits dans ces domaines. Mais tout reste en surface, au niveau des apparences ; l’intériorité, les sentiments profonds sont cachés, et il est important de le rappeler systématiquement

L’industrie de la détection d’émotions a activé diverses recherches. Le Deep Learning utilise des étiquettes d’impact, en analysant plutôt de la colère ou de la joie. A l’entrée du réseau, il est possible de mettre une image d’une personne souriante en analogie avec de la joie, une autre image en tant que colère. Mais ceci est une vision statique.

Or, les visions en ce moment les plus intéressantes sont les visions dynamiques. L’émotion est un processus dynamique commençant par l’évaluation d’un constat quelconque : voir une branche d’arbre dans une forêt, penser qu’il s’agit d’un serpent, et s’enfuir. Klaus Scherer est celui qui a le plus avancé avec d’autres personnes en sciences cognitives, parlant de modèle théorique et d’évaluation, avec différents niveaux d’évaluation de l’environnement liés à la familiarité de ce que l’on perçoit à un niveau très bas. Réciproquement, un avis de très haut niveau va-t-il dans le sens de notre éthique et notre morale individuelles et dans l’éthique et dans celui de la morale de la société ?

Notre réaction est en fait un mélange de tout cela, qui a lieu dans une fulgurance corporelle. La générer par des images en passant par les différentes étapes est possible et très naturel, à l’inverse ce que proposait Paul Ekman, psychologue américain pionnier de l’étude des émotions et micro-émotions et leurs expressions faciales. Ekman a apporté beaucoup d’éléments sur la détection faciale et l’émotion, à partir d’images statiques. Pour autant, ce sont des faction units, des parties de notre visage décrites en tant que parties. Lever le sourcil droit, émettre un léger rictus sur la bouche vers la gauche, peuvent être encodés.

Des machines permettent d’analyser les attitudes, allant jusqu’aux micro-expressions du visage pouvant amener à être un menteur. Ce genre de système a commencé à être testé dans les aéroports, mais a engendré de nombreuses polémiques dans le monde scientifique.

A propos des robots sociaux, le travail a été fait par la Softbank Robotics. Un système de dialogue est constitué d’un ensemble de parties où l’on perçoit, où l’on raisonne sur les dialogues ou l’on actionne du contenu verbal. Les émotions et le profil de la personne sont détectées en essayant de trouver les tendances liées à sa personnalité.

Une de mes étudiantes soutiendra bientôt sa thèse sur l’humour machine. Quel sens donner à l’humour en machine ?

Pour assister quelqu’un dans une communication, quand une machine réalise que la personne n’arrive pas à s’exprimer, elle va « baisser sa garde », selon la théorie du sociologue Kaufmann, afin d’équilibrer le dialogue. La meilleure façon de dialoguer avec quelqu’un est de se mettre à son niveau ou juste en dessous : il s’agit d’une machine et il est impossible qu’elle soit dominante.

Imaginons que ces systèmes soient utiles en fin de vie, dans l’aide aux personnes dépendantes. Il faut rester attentif à ce qui sera mis dans ces machines. La recherche se poursuit sur ces objectifs..

Lors de l’acquisition d’un système, par exemple Google Chrome, il est impossible de savoir si l’on est écouté en permanence, mais c’est un fait. Impossible de savoir a priori si l’on est manipulé : se voir proposer des films ou être l’objet d’actions marketing. Il s’agit donc d’être vigilant à l’égard de ces machines quotidiennement autour de nous.

En Corée du Sud, il existe une machine qui est un agent conversationnel sur écran. Son but est de dialoguer avec des militaires ayant subi des traumatismes pendant la guerre et elle recherche des syndromes post-traumatiques d’une dépression. Elle est aussi utilisée dans le cas de viols :il s’agit dans ce cas d’élaborer le ressenti de la personne face à une machine qui ne juge pas et renvoie une réponse.

Eliza a été le premier système de ce type : programme informatique écrit par Joseph Weizenbaum entre 1964 et 1966, il simule un psychothérapeute en transformant en questions, à l’aide d’un modèle de Markov, les mots du patient. Lorsque la machine ne pouvait relancer la conversation, elle disait simplement : « je vous comprends ».

L’empathie

Abordons maintenant les robots empathiques. Il est possible d’éprouver des émotions de toute nature et vis-à-vis de multiples situations, personnes ou objets. Par exemple, il m’a été demandé : « Mon aspirateur est autonome ; s’il traverse le salon et s’arrête, à quoi pense-t-il ? ». Eh bien non, il ne pense pas. Il y a un écart énorme entre certaines croyances individuelles et les capacités techniques d’une machine. Les robots démineurs ne sont que des objets téléopérés, sans aucune intelligence. Ils ont sauvé des vies. Évidemment, il a été possible que s’établissent des transferts entre l’objet et les soldats. L’anthropomorphisme, ou attribution des caractéristiques de l’humain aux machines, peut être tout à fait naturel.

Au Japon et aux États-Unis, on voit apparaître le concept de clone. Ce sont des « géminoïdes », mélange de « gémeau » et « droïde », des jumeaux androïdes.

La photo ci-dessus représente le professeur Hiroshi Ishiguro, roboticien japonais, directeur de l’Intelligent Robotics Laboratory à l’Université d’Osaka, et son clone. A l’inverse du Portrait de Dorian Gray, d’Oscar Wilde, le clone, lui, ne vieillit pas.

Il faut mentionner aussi Hanson Robotics avec Sophia, dont la notoriété vient de son « discours » aux Nations Unies ou de ses passages dans des émissions de télévision. C’est un système robotique téléopéré, donc pas très intelligent mais qui synthétise beaucoup, et possède une dissymétrie entre ce qu’elle synthétise et ce qu’elle reconnaît, laissant croire qu’elle comprend plus de choses qu’elle n’en comprend vraiment. En réalité, elle ne comprend rien, et ce genre d’objet peut affecter les croyances de personnes éloignées de la technologie. Sophia a même obtenu la nationalité saoudienne ! Et la mode des robots clones est partout ; par exemple, l’actrice Scarlett Johansson a été clonée en Corée.

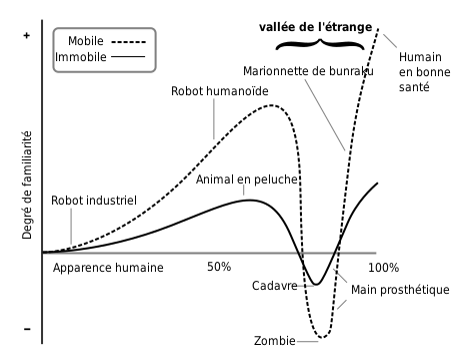

Cela étant, une théorie scientifique, publiée en 1970, du roboticien japonais Masahiro Mori fait référence à la vallée de l’étrange (cf graphe ci-dessous). Ce concept, plutôt qu’une théorie, énonce que plus un robot androïde ressemble à un être humain, plus l’homme ou la femme développent un affect pour la machine, avec un degré de familiarité croissant. Cette proximité s’interrompt avec l’apparition de la vallée de l’étrange (uncanny valley), où les imperfections du robot, même mineures, paraissent monstrueuses.

Mentionnons une autre illustration, à nouveau originaire du Japon. Au Japon, le risque d’isolement individuel et la déshumanisation sont des vrais sujets d’attention. La société Vinclu commercialise depuis la fin 2016 un système qui est un assistant personnel présentant une jeune fille, nommé Azuma Hirari, sous forme d’hologramme, qui rappelle la fée clochette de Peter Pan et éveille des sentiments à ses utilisateurs (voir ci-dessous).

Son prix unitaire est de 2600 euros. Cela ressemble au film « Her » de Spike Jonze, sorti en 2013. Le système s’appelle Gatebox et fait l’objet d’une publicité convaincante sur le marché japonais. Il pourrait y avoir un souhait d’aller vers ce genre de système, et donc un marché. Il sera intéressant de suivre l’avenir de la Gatebox, même si l’on peut penser que c’est le signe d’une triste pauvreté pour les relations humaines. Il vaut mieux éviter de tomber dans ce piège et contrôler tous ces systèmes., notamment les machines qui vont apprendre de nous et s’adapter à nous. Rappelons-nous Tay, agent conversationnel de Microsoft mis sur Twitter en fin du premier trimestre 2016. Après 24 heures d’utilisation, Tay tenait des propos haineux ou racistes alors qu’au début il disait aimer toute l’humanité. Microsoft a déconnecté Tay de Twitter. Côté négatif de l’apprentissage, puisque, comme agent conversationnel, Tay était conçu pour apprendre des échanges avec les personnes. Biais d’apprentissage, car les personnes ont commencé à tenir des propos indécents, engendrant des réactions multiples, et le buzz a atteint Tay. Il ne s’agit donc pas de parler d’intelligence machine, mais seulement du manque d’anticipation des ingénieurs en amont qui n’avaient pas prévu les effets secondaires.

Mon opinion est qu’il vaut mieux parler de co-évolution de la machine. On cherche à adapter la machine à l’humain et l’humain va s’adapter aux machines. Il faut donc faire extrêmement attention ; ceci ouvre un nouveau champ de recherche d’ethnologie..

En guise de conclusion

Pour terminer, un sujet d’intérêt général et international, dépassant le cadre français ou européen, porte sur le cadre général concernant ces systèmes technologiques.

Il y a quatre leviers importants.

Le premier consiste à éduquer le plus possible sur ces systèmes, et au plus tôt dans la vie, et de favoriser une plus forte mixité dans les sciences en attirant les filles dans ces domaines.

Il faut ensuite expliciter des règles éthiques, et même comprendre ce qu’est l’éthique de ces systèmes pour décider de notre degré d’acceptation ou de refus.

Il convient également de mettre en œuvre des outils. Nous espérons tous que la mission de Cédric Villani va insister sur ce point. Nous sommes a priori tous d’accord avec les résultats de cette mission, qui iront de plus en plus vers des instituts pluridisciplinaires. A titre personnel, je travaille avec des économistes ou des juristes ; il faut absolument réfléchir en pluridisciplinarité et de façon internationale. Alors, nous passerons efficacement aux nécessaires réglementations juridiques.

Le quatrième levier consiste à éveiller, sinon réveiller, l’intelligence de chacun. Je pilote un groupe sur les normes standards, dénommé P7008 à l’IEEE, en particulier sur le « nudging ». Le « nudging » est bien appliqué en marketing publicitaire et en publicité. L’américain Richard Thaler, prix Nobel d’économie en 2017, a produit des travaux éminemment intéressants à propos de la manipulation fine, ou incitation. Le « nudge » peut vous inciter à faire évoluer « naturellement » votre comportement en jouant sur les caractéristiques individuelles : paresse, mimétisme, reproduction de choses vues sans raisonner. Les machines peuvent nous entraîner à la paresse ; il est donc important d’éveiller l’intelligence de tout citoyen pour bien comprendre les éventuels objectifs de manipulation visés.

Tous les facteurs sont donnés, sans véritable manipulation, mais certains sont mis plus en évidence. Les éléments de marketing, de publicité, employés dans Google Home, dans des robots, dans des agents conversationnels, vont être omniprésents dans la société ; ce sont par conséquent des sujets majeurs sur lesquels il faut urgemment travailler, et ce travail a commencé. Il faut ensuite que cette réflexion et les propositions qui en résulteront passent au niveau des décideurs politiques.

Merci pour cet excellent tour d’horizon. Je pense que vous avez raison d’insister sur la co-évolution entre humains et machines. On se pose souvent la question des progrès accomplis en robotique et en intelligence artificielle, moins souvent celle de la manière dont nous adaptons notre comportement aux limites des systèmes informatiques avec lesquels nous interagissons en permanence (choix fermés plutôt qu’ouverts, prépondérance du quantitatif sur le qualitatif etc.).

Merci beau coup pour cet article….que je vais relire plusieurs fois pour mieux le comprendre!!

Je pense nécessaire d’informer régulièrement les lecteurs de Variances et aussi les citoyens des évolutions de ces domaines qui recèlent de fantastiques opportunités, en particulier dans la santé, mais aussi des risques de manipulations et de grandes réductions de nos domaines de liberté.

En tout cas bravo et merci en attendant de futurs articles